AI 繪圖原理深度解析:帶您一步步了解從文字提示到影像生成的運作機制

最後更新: 2026-01-22 18:08:25

深入探索 AI 智慧作圖的運作原理,了解系統如何透過擴散模型與數學運算,將文字提示詞轉化為細膩的影像像素。

輸入提示詞後會發生什麼?深入淺出地為您解析 AI 繪圖的運作原理

相信許多人都曾有過這樣的體驗:只需在 Midjourney 或 DALL-E 輸入「一隻戴著巫師帽的貓,油畫風格」等提示詞,短短 30 秒內,一張世上絕無僅有的全新影像便會躍然眼前,整個過程簡直如同魔法般令人驚嘆。

這並非魔法,而是源自大量的數學運算。深入理解這項技術的運作原理,不僅能滿足求知欲,更能顯著提升您對工具的掌控力;當您洞悉了提示詞生效的內在邏輯後,便能告別盲目摸索,轉而以專業的思維精準構思並進行創作。

接下來,我們將帶您深入剖析 AI 繪圖的技術核心。無需深究艱澀的學術論文,透過深入淺出的講解,您將能透視底層運作機制,真正掌握 AI 生圖背後的邏輯與原理。

核心摘要(30 秒速讀):

AI 繪圖工具的運作核心是將您的提示詞轉化為數字化的文本嵌入(Text Embeddings),並在壓縮的「潛空間」中從隨機噪訊出發,透過擴散模型在提示詞的引導下逐步去噪,最終將運算結果解碼為像素影像。此外,藉由調整 CFG 指令遵循度、疊代步數與種子碼等關鍵參數,您可以精準掌握圖像與描述的契合程度,並確保生成結果的一致性。

AI 繪圖工具如何攻克影像生成的兩大核心挑戰

所有 AI 繪圖工具的運作原理,皆在於處理兩個獨立卻又環環相扣的核心任務:首先必須精準解析您的提示詞意涵,進而據此生成對應的影像內容。

首要挑戰:精準理解創作意圖。當您輸入如「山巒上的壯麗夕陽」等提示詞時,系統會透過自然語言處理技術將文字解析為可運作的視覺概念,不僅能精準領會「壯麗」一詞的視覺表現,更能掌握落日餘暉與山巒陰影間的色彩互動細節。

挑戰之二:像素生成的具體實踐。 為了落實用戶的指令,系統必須精確輸出數百萬個顏色數值,從而建構出物體結構連貫、光影逼真且透視精準的影像,這正是電腦視覺技術發揮作用的核心環節。

現代系統透過類神經網路有效解決了這兩大難題,這種運算架構的靈感源自人類大腦神經元間的連結與溝通模式。

類神經網路:構建 AI 影像的核心基石

在深入探討具體的技術架構前,建議先瞭解神經網路處理影像的核心原理與運作機制。

與人類的視覺直覺不同,電腦是透過龐大的數據矩陣來理解影像的。以一張 512×512 的彩色影像為例,其中包含了高達 786,432 個獨立數值(即像素與三原色通道的乘積),而神經網路的核心任務,正是從這片紛繁的數據之海中精準辨識並捕捉特定的視覺模式。

這些神經網路在訓練階段會處理海量影像。以 Stable Diffusion 為例,其透過廣泛蒐集自網路公開資源的 LAION 5B 數據集進行訓練,內含約 58.5 億組「圖文對」;藉由分析每張影像所附帶的替代文字(alt tags)、說明及其周邊敘述,模型能精準建立起語言與視覺概念間的關聯。

透過此訓練過程,神經網路能由淺入深地學習圖像模式,從初始層捕捉邊緣與基本輪廓,到中層識別如眼睛、輪子及葉片等局部特徵,最終在深層網路中精準掌握整體的創作概念與視覺風格。

從 GAN 到擴散模型:深度解析 AI 繪圖技術的演進歷程

近年來 AI 繪圖領域經歷了翻天覆地的技術變革,透過深入了解這段演進歷程,即可揭開現今工具相較於三年前大幅進步的關鍵奧秘。

GAN 時代 (2014~2021)

自 2014 年由 Ian Goodfellow 提出以來,生成對抗網絡 (Generative Adversarial Networks, GANs) 憑藉其讓兩個神經網絡相互博弈的優雅核心設計,在 AI 領域引領風騷多年。

系統透過「生成器」與「辨別器」兩大網絡的交互競爭不斷進化:前者致力於生成栩栩如生的圖像,後者則負責精準識破偽造。在這場如同軍備競賽般的對抗過程中,隨著辨別能力的日益提升,生成器亦須持續優化以求突破,進而推動兩大網絡共同邁向卓越的成像品質。

截至 2019 年,生成對抗網路(GANs)的發展已相當成熟,其中 StyleGAN 甚至能產出幾可亂真的虛擬人臉,展現出驚人的生成實力;然而,該技術在訓練過程中常面臨兩組網路不同步所導致的不穩定性,且在處理多物件的複雜場景或如手部等精微細節時,表現仍顯得力有未逮。

擴散模型革命 (2020 年至今)

2020 年,加州大學柏克萊分校的 Jonathan Ho、Ajay Jain 與 Pieter Abbeel 共同發表了具有里程碑意義的《Denoising Diffusion Probabilistic Models》(DDPMs) 論文,自此徹底改變了 AI 影像生成的發展格局。

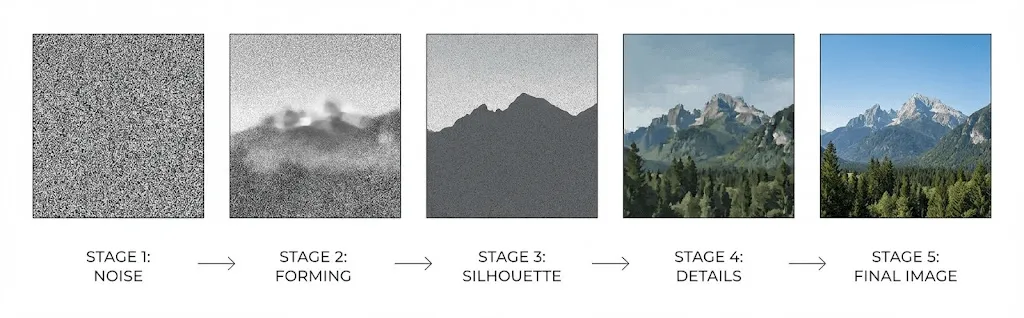

擴散模型的運作核心在於學習如何逆轉雜訊過程,即從隨機的雜訊起點出發,透過逐步「去噪」程序將其轉化為清晰影像;其原理是藉由在原始圖像中不斷加入雜訊直至完全模糊,進而訓練神經網路精準掌握反轉還原的技術,最終實現高品質的圖像生成。

前向過程:此階段會將高斯雜訊逐步導入訓練圖像中,通常需歷經 1,000 個處理步驟,直至影像最終轉化為完全無法辨識的隨機雜訊。

逆向過程:透過訓練網路在每一階段精確預測並消除雜訊,進而從純粹的隨機狀態中逐步重構出結構完整的清晰圖像。

相較於傳統 GAN,此技術憑藉其逐步生成的機制,有效避開了複雜的對抗動態平衡,不僅在過程上更加穩定,更能產出多樣化的視覺效果,並精準且可靠地回應複雜提示詞的各項細節。

2021 年,隨著 Dhariwal 與 Nichol 發表《Diffusion Models Beat GANs on Image Synthesis》論文,正式宣告了擴散模型在影像合成領域已全面超越 GAN,奠定了其不可撼動的技術領先地位。

AI 繪圖技術原理解析:從文本提示到影像生成的完整運算流程

當您在 Stable Diffusion、DALL-E 或 Midjourney 輸入提示詞後,系統後台便會開始執行以下運算程序,將您的創意構思轉化為數位影像:

第一步:透過 CLIP 進行文本編碼

您的文字輸入首先會經由 OpenAI 所研發的 CLIP(對比語言圖像預訓練)文本編碼器進行處理,以完成初步的解析與轉換。

CLIP 憑藉著 4 億組圖文對的深度訓練,得以精準掌握語言與視覺概念間的關聯,進而將您的提示詞轉化為蘊含語義資訊的高維向量(通常為 768 或 1024 維)。

這些向量存儲於共享的「嵌入空間」內,使語意相近的概念得以匯聚;例如「狗」與「小狗」會生成極為接近的向量,而「狗」與「摩天大樓」之間則會產生截然不同的向量特徵。

第二步:深入潛空間進行運算

現代系統的精巧之處,在於能避開直接處理高解析度圖像所需的龐大運算負擔,轉而於壓縮後的「潛空間」(Latent Space)中進行高效處理。

Rombach 等人於 2022 年發表 Stable Diffusion 論文時證實,擴散程序能在維持高品質輸出的同時,於此壓縮空間內順利運作;這項關鍵突破大幅降低了技術門檻,成功讓 AI 生圖技術得以普及並為大眾所用。

Stable Diffusion 透過將 512×512 圖像(786,432 個數值)大幅壓縮至 64×64 的潛空間表示(僅 16,384 個數值),成功實現高達 48 倍的數據縮減,這也正是其無需依賴大型數據中心,僅憑消費級 GPU 即可高效運行的關鍵所在。

影像生成始於潛空間中的隨機噪聲,您可以將其想像成一幅高度壓縮且佈滿模糊雜訊的原始畫布。

步驟三:執行迭代降噪處理

接著進入最關鍵的核心流程:透過最初為醫學影像分割所研發、因其 U 型神經網路架構而得名的 U-Net,進行通常為 20 至 50 次的迭代去噪處理。

在處理流程的每一環節中,U-Net 都會接收以下核心資訊:

- 當前含有雜訊的潛空間特徵表示

- 經由 CLIP 編碼處理後的提示詞文本嵌入

- 標註目前生成進度與階段的時間戳記

系統會預測影像中的噪點含量並精準消除,藉此在生成初期先行確立構圖與大略輪廓,隨後再逐步精煉以呈現細膩的紋理與各項細節。

透過「交叉注意力機制」,文本嵌入能有效引導生成過程,使網路在決定各個位置的增減細節時,能精確對焦並參考提示詞中的相關內容。

步驟 4:影像解碼與像素還原

當降噪程序完成後,系統會利用解碼器(即變分自編碼器 VAE)將原本被壓縮的潛空間數據還原為完整解析度,並透過此「上採樣」過程,精準重構出影像最初被壓縮掉的細膩紋理與細節。

掌握提示詞精準度的關鍵:CFG (引導比例) 設定解析

在使用 Stable Diffusion 時,您可能常會看見「CFG Scale」或「提示詞相關性」等參數,這直接決定了模型遵循指令的嚴謹程度。雖然多數使用者往往習慣照搬教學建議,將數值固定在 7,但深入了解其背後的運作邏輯,將能助您更精確地掌控生圖效果並優化產出品質。

CFG(全稱為 Classifier Free Guidance,即無分類器指導)的運作原理,是在每個去噪步驟中讓模型實際進行兩次運算:

- 結合您的提示詞:根據特定的文本指令,分析圖像應呈現的具體視覺細節。

- 完全不使用提示詞:探討在缺乏特定指引下,一張「通用型」圖像的基礎樣貌。

最終輸出透過強化兩項預測間的差異,當 CFG 數值越高,便能更有效地引導生成結果精準貼合您提示詞中的創意構思。

然而,這在實際應用中仍涉及一定的權衡與取捨:

- 低 CFG 值(1-5):能賦予 AI 較高的創作靈感,但也可能導致生成內容偏離原始提示詞。

- 中等 CFG 值(7-12):通常能在創意表現與指令精準度之間取得理想平衡,是多數場景下的最佳設定。

- 高 CFG 值(15 以上):雖能極其嚴格地遵循指令要求,但往往會引發色彩過度飽和或產生不自然的影像偽影。

主流生圖工具深度對比:DALL-E、Midjourney 與 Stable Diffusion

目前主流的 AI 圖像生成器均已採用擴散模型作為核心技術,但在實際的開發架構與應用細節上,各家方案仍展現出顯著的差異性。

DALL-E 3 (OpenAI)

OpenAI 採取直接整合 ChatGPT 的策略,透過 GPT 4 在生圖前先行重寫並擴充提示詞,使 DALL-E 即使面對簡單指令,也能呈現出驚人且細膩的視覺效果。這種機制對於一般使用者而言極具優勢,能輕鬆獲得高品質影像,但對於追求極致指令精確度的進階用戶,自主掌控權則相對受限;值得一提的是,它在處理影像中文字渲染的表現極為優異,成功克服了 AI 繪圖長久以來的技術瓶頸。

Midjourney

Midjourney 的模型設計顯然更注重視覺美感而非字面上的精確還原,其生成的影像往往具備豐富的藝術繪畫感或電影運鏡張力;即便未必能百分之百精確契合提示詞,其卓越的視覺吸引力仍使其在眾多生成器中脫穎而出。此外,雖然基於 Discord 的操作介面較為獨特,卻也成功形塑了互動緊密的社群生態,惟其在技術細節的透明度上相較於競爭對手則更為有限。

Stable Diffusion 擴散模型

作為開源方案的首選,本工具支援本地端運行,讓您在深入掌握運作機制的同時也能自由修改設定,並由此催生了包含精調模型、LoRA(用於導入特定概念的低秩自適應)及豐富擴充組件的龐大生態系統。雖然學習曲線相對較高,但對於追求極致掌控權、重視隱私或需訓練客製化模型的用戶而言,這絕對是您的最佳選擇。

Adobe Firefly

嚴選 Adobe Stock 影像、公開授權內容及公有領域作品進行訓練,確保生成影像具備極高的商業合規性,特別適合對版權要求嚴格的專業應用情境。除了能與 Photoshop 及 Illustrator 深度整合,更在生成策略上採取穩健作風,主動避免產生具爭議性的內容,為您提供更安全且符合品牌形象的創作產出。

超越基礎生成,探索影像創作新境界

除了基礎的「文本轉圖片」功能外,現代 AI 生圖系統更具備多項強大技術,其背後的多元應用能力同樣值得深入了解。

圖生圖 (img2img)

不同於從純雜訊開始生圖,此過程是以現有圖像為基礎並加入部分雜訊,再透過「去噪強度」(Denoising Strength)參數精準控制雜訊比例,進而決定生成結果與原圖的偏離程度。較低的強度能實現細微的風格轉換,而高強度則能在僅保留原圖構圖框架的基礎上,賦予影像徹底重塑的全新面貌。

局部重繪與影像延伸

「區域重繪」功能可針對特定遮罩區域進行再生,在確保其餘畫面完整的前提下,不僅能有效移除多餘物件,更能靈活替換影像元素;與此同時,「影像延伸」技術則突破了原始畫框的限制,透過生成與現有場景完美銜接的連貫內容,讓視覺空間得以向外擴展。

ControlNet

ControlNet 為圖像生成過程引入了關鍵的結構化引導,讓您能透過邊緣圖、深度圖、人體骨架或分割遮罩,精確定義畫面中各個元素的呈現位置。這項技術不僅能維持角色設計的一致性,更解決了純文字提示詞難以實現精準空間控制的痛點,顯著提升了創作的自由度與精確度。

LoRA 與 DreamBooth 模型技術

如果您希望 AI 能夠生成原始訓練資料以外的特定人物、產品或視覺風格,可透過 LoRA (Low Rank Adaptation) 與 DreamBooth 技術,僅需 20 至 30 張圖片的小型自定義資料集即可完成模型微調,從而讓 AI 能夠隨心所欲地精準生成您所需的特定概念圖像。

深入解析當前技術局限及其成因

掌握 AI 生圖工具常見的局限與生成瓶頸,將有助於您在創作過程中靈活應對並有效規避相關問題。

眾所皆知的 AI 生圖手部描繪難題

AI 生圖工具常因生成手指數量有誤、指節融合或不合人體構造的手部影像而為人詬病,然而這並非單純待修復的程式漏洞,而是技術研發中面臨的一項核心挑戰。

由於手部在訓練數據中的角度、位置及遮擋情況極為多變,且相較於整幅圖像佔比微小,因此在訓練過程中獲得的「注意力」相對有限。與五官等特徵更為一致的部位相比,手部的統計規律更難以掌握,儘管近期模型已顯著提升了精確度,但這仍是一項持續存在的挑戰。

文字渲染

在 DALL-E 3 問世之前,要在 AI 圖像中生成清晰可讀的文字幾乎是一項不可能的任務,這主要是因為模型雖能理解詞彙語義,卻難以掌握字體的視覺排版。儘管 DALL-E 3 已在此領域取得顯著進展,但目前各類平台在處理複雜文字佈局時,依然面臨穩定性不足的挑戰。

維持跨圖像的一致表現

由於 AI 生圖的起點均源自隨機噪點,導致維持特定角色或場景的一致性極具挑戰。即便目前已有固定種子碼 (Seed Locking)、參考圖或角色 LoRA 等技術手段,仍難以徹底解決此問題,進而限制了漫畫創作與品牌角色開發等專業場景的應用發展。

空間推理能力

當輸入如「紅球在藍色方塊左側,且方塊位於綠色金字塔後方」這類複雜指令時,AI 生成的圖像往往難以精確呈現,這反映出模型雖然能識別個別物件,但在處理多個元素間的複雜空間邏輯時仍力有未逮。

版權歸屬與法律問題探討

在此階段,法律規範與倫理道德層面的挑戰也隨之變得愈發錯綜複雜。

訓練數據

多數 AI 圖像模型皆是利用從網路蒐集的數十億張圖片進行訓練,然而此舉往往未取得原創者的明確授權,因而引發了多起關於版權侵權的法律訴訟,使得目前的法律定位仍處於懸而未決的狀態。

產出作品所有權歸屬

根據美國版權局的現行規範,著作權保護的前提必須具備「人類原創性」,因此純粹由 AI 生成的圖像無法獲得版權保障。雖然在製作過程中包含「充足人類創意投入」的作品可能符合資格,但具體的判定界限目前仍不明確,相關法律爭議也正處於訴訟階段。

此外,平台的服務條款亦不容忽視。儘管多數商業平台皆會賦予用戶對生成圖像的使用權限,但仍建議您針對具體的使用場景,詳閱相關細則以確保權益。

提升生成效果的實用技巧

深入理解技術背後的運作原理,能幫助您更精準地掌握提示詞技巧;以下為您揭秘實現卓越成效的實務心法:

深入掌握核心概念

由於文字編碼器會依據單詞順序分配權重,關鍵詞的排列位置將直接影響生成的強調重點;例如「日落、強烈光影、山脈景觀」與「落日下的山脈景色」便有顯著差異,建議您將核心元素置於提示詞前端以優化成效。

運用模型已掌握的參考知識

AI 模型主要透過海量數據進行學習,因此在撰寫提示詞時,與其使用抽象描述,不如具體引用知名藝術家、藝術流派或相機與底片型號(如「Kodak Portra 400 拍攝」),以更精準地觸發特定的視覺特徵;例如,標註「林布蘭光」會比單純描述「戲劇性側光」更能呈現出明確且穩定的光影效果。

以持續迭代取代追求一次到位

AI 繪圖鮮少能一蹴而就,建議您先嘗試生成多種變體以篩選理想方向,並據此持續精進提示詞;針對滿意的作品,更可善用 img2img 功能,在維持原有構圖的基礎上針對局部細節進行迭代優化,逐步打造出最完美的視覺呈現。

善用反向提示詞

負向提示詞旨在精確排除模糊、肢體扭曲、多餘手指、浮水印或畫質低劣等不理想元素,透過在去噪過程中削弱特定概念的影響力,從源頭優化生成結果。藉由建立完善的負向提示詞庫,您能有效避免常見的生圖瑕疵,確保視覺產出始終穩定且專業。

未來展望與後續發展

AI 生圖領域正以前所未有的速度飛速演進,以下幾項關鍵技術動態非常值得您持續關注:

- Sora 與 Runway Gen 3 等技術正將擴散模型延伸至影片生成領域,讓高品質的「文本轉影片」功能逐漸成為現實。

- 隨著文本轉 3D 與圖像轉 3D 工具的快速成熟,遊戲開發、產品視覺化及虛擬實境(VR)產業將迎來革命性的變革。

- 透過持續的效能優化,AI 生圖已邁向即時互動的境界,部分技術甚至能在不到一秒的時間內完成影像生成。

- 新型架構正致力於突破角色與場景的一致性挑戰,這將全面解鎖漫畫創作與動畫製作的廣泛應用潛力。

常見問題

AI 影像生成需要多少時間?

雲端服務生成圖像通常約需 10 至 30 秒,而若採用配備 RTX 3060 或更高等級顯卡的現代 GPU 運行本地端 Stable Diffusion,生成 512×512 圖像僅需 2 到 5 秒;此外,生成時間也會隨著解析度提升或運算步數增加而相應延長。

AI 繪圖工具是否會複製既有圖像?

事實並非如此,AI 並非透過儲存圖像副本來運作,而是學習數據間的統計規律。然而,部分極具知名度的影像仍可能在一定程度上被模型「記住」,因此當使用者在提示詞中指定特定藝術家風格時,生成的作品往往會與其原作高度相似,這也正是目前版權爭議最為激烈的核心所在。

剖析 AI 繪圖難點:為何手部細節難以完美呈現?

由於手部在訓練數據中展現出極為多變的角度、位置與可見度,且在多數全身構圖中佔比相對較小,導致模型難以分配充足的訓練權重。相較於其他規律特徵,手部複雜的統計模式更難以被精準捕捉,即便目前技術正持續進化,精確生成手部細節仍是一項不小的挑戰。

我能將 AI 生成的圖像用於商業用途嗎?

商業使用權限主要視各平台服務條款及所在地法律而定;儘管多數服務均會授予用戶商業權利,但純粹由 AI 生成的作品在美國等地可能無法取得版權。其中,Adobe Firefly 專為商業應用量身打造,其模型僅採用經授權的內容進行訓練,以確保使用上的合規與安全。

解析擴散模型與 GAN 之間的技術差異

GAN 採用生成器與判別器相互競爭的對抗式架構,而擴散模型則透過學習逆轉逐步加噪的過程來生成影像。憑藉著更穩定的訓練機制、更豐富多樣的輸出內容,以及能精準對齊提示詞要求的優勢,擴散模型目前已成為 AI 繪圖領域的主流技術。

核心要點

AI 繪圖技術並非憑空產生的魔術,而是透過「擴散模型」將文字指令轉化為循序漸進的引導式去噪過程。這套精密系統整合了深度的文本理解與視覺模式學習,並經由不斷的迭代優化,最終能根據文字描述精準產出高品質圖像。

當您輸入提示詞後,系統會透過經數億組圖文數據訓練的編碼器進行解析,進而引導壓縮潛空間內的去噪流程,最終解碼還原成高解析度影像;即便僅是初步掌握這套運作機制,也能助您更精準地駕馭 AI,從而提升您的創作效率。

提示詞生圖並非單純在輸入框中許願,而是透過您提供的引導信號驅動精密的數學運算。系統會深入解析您的語言指令,並運用預訓練模式引導去噪程序,進而從底層架構重構出高品質的完整影像。

掌握這些原理不僅能滿足您的好奇心,更能助您精確撰寫提示詞、建立合理的產出預期,並針對不同需求挑選最適用的工具;在科技日新月異的浪潮下,深厚的基礎將成為您靈活應變並與時俱進的關鍵。