Como funcionam os geradores de imagens IA: o passo a passo do prompt à imagem final

Última atualização: 2026-01-22 18:08:25

Descubra como os geradores de imagens por IA utilizam modelos de difusão e fundamentos matemáticos para transformar, com precisão, prompts de texto em pixels.

Descubra como os geradores de imagens por IA utilizam modelos de difusão e fundamentos matemáticos para transformar, com precisão, prompts de texto em pixels.

O que acontece após o envio do seu prompt? Entenda o processo através de uma explicação simples e precisa.

Muitos de nós já vivenciamos a experiência quase mágica de inserir comandos como "um gato com chapéu de mago em estilo pintura a óleo" no Midjourney ou DALL-E e, em apenas 30 segundos, ver surgir uma imagem totalmente inédita que nunca existiu antes.

Longe de ser um processo mágico, esta tecnologia fundamenta-se em cálculos matemáticos complexos, cujo entendimento transcende o interesse acadêmico ao potencializar o domínio prático sobre essas ferramentas. Ao compreender os mecanismos por trás do sucesso de cada comando, você deixa de depender do acaso para criar com precisão, técnica e intenção.

Vamos analisar detalhadamente o funcionamento dessa tecnologia sem a complexidade de um nível acadêmico, mas com a profundidade necessária para que você compreenda verdadeiramente os processos que ocorrem nos bastidores.

Resumo Rápido (30 segundos):

Os geradores de imagens por IA transformam seus prompts em representações numéricas (text embeddings) para processá-los em um "espaço latente" comprimido, onde um modelo de difusão elimina gradualmente o ruído inicial sob a orientação das suas instruções. Após esse refinamento progressivo, o resultado é decodificado em pixels, permitindo que parâmetros como a escala de orientação (CFG), o número de passos e as sementes (seeds) controlem com precisão a fidelidade ao comando e a consistência visual das criações.

Os dois principais desafios solucionados pelos geradores de imagens IA

O funcionamento de qualquer gerador de imagens por IA fundamenta-se na resolução de dois processos distintos e complementares: a interpretação precisa do seu prompt e a criação técnica da imagem.

O primeiro desafio: a interpretação da sua intenção. Ao inserir um comando como "pôr do sol sobre montanhas com iluminação dramática", o sistema utiliza o processamento de linguagem natural para decompor a frase em conceitos visuais, permitindo que a IA compreenda desde o significado estético de termos como "dramático" até a complexa interação entre as cores do entardecer e as sombras das montanhas.

O segundo desafio reside na geração efetiva dos pixels: para converter suas instruções em milhões de valores cromáticos que componham objetos coerentes, iluminação realista e perspectivas precisas, o sistema mobiliza processos avançados de visão computacional.

Os sistemas modernos solucionam ambos os desafios através de redes neurais, estruturas computacionais inspiradas na forma como os neurônios humanos se conectam e comunicam entre si para processar informações.

Redes Neurais: O Alicerce Fundamental

Antes de explorarmos as arquiteturas específicas, é fundamental compreender como as redes neurais efetivamente processam e interagem com as imagens.

Ao contrário da percepção humana, os computadores não "enxergam" imagens, mas as interpretam como vastas grades numéricas. Em uma imagem colorida de 512x512 pixels, por exemplo, existem 786.432 valores individuais (512 × 512 pixels × 3 canais de cores), cabendo à rede neural a tarefa de identificar padrões complexos dentro desse imenso mar de números.

Durante a fase de treinamento, estas redes processam milhões de imagens, a exemplo do Stable Diffusion, que utilizou o dataset LAION 5B — um conjunto de dados com cerca de 5,85 bilhões de pares de imagem e texto coletados de fontes públicas na web. Ao analisar cada imagem em conjunto com seu texto associado, como tags alt e legendas, o modelo aprende a estabelecer correlações precisas entre a linguagem e os conceitos visuais.

Ao longo deste processo, a rede assimila padrões em múltiplos níveis de complexidade: enquanto as camadas iniciais identificam contornos e formas básicas, as intermediárias reconhecem elementos específicos — como olhos, rodas ou folhagens —, culminando em camadas profundas capazes de compreender estilos e conceitos abstratos em sua totalidade.

Das Redes GAN aos Modelos de Difusão: A Evolução da Tecnologia

O cenário da geração de imagens por IA passou por transformações profundas nos últimos anos, sendo que compreender essa evolução é fundamental para entendermos por que as ferramentas atuais apresentam uma performance e qualidade imensamente superiores às tecnologias de apenas três anos atrás.

A Era das GANs (2014–2021)

As Redes Neurais Adversárias (GANs), apresentadas por Ian Goodfellow em 2014, consolidaram-se como a tecnologia predominante por anos ao utilizarem uma premissa elegante: o confronto direto entre duas redes neurais distintas.

Enquanto uma rede, denominada gerador, se dedica à criação de imagens sintéticas, o discriminador atua na identificação de falhas, estabelecendo um ciclo de aprimoramento constante em que a maior precisão na detecção exige uma evolução contínua do gerador para superá-la, impulsionando ambos os sistemas rumo à excelência.

Embora as GANs tenham alcançado marcos impressionantes até 2019, com o StyleGAN sendo capaz de gerar rostos fotorrealistas de pessoas inexistentes, a tecnologia ainda apresentava limitações, como a instabilidade no treinamento entre as redes e a dificuldade em processar cenas complexas ou detalhes anatômicos minuciosos, como as mãos.

A Revolução da Difusão (2020–Presente)

Explore como os geradores de imagens por IA convertem prompts de texto em pixels por meio de modelos de difusão e fundamentos matemáticos.

Em 2020, a publicação do artigo "Denoising Diffusion Probabilistic Models" (DDPMs) por Jonathan Ho, Ajay Jain e Pieter Abbeel, pesquisadores da UC Berkeley, marcou um ponto de virada histórico que transformou radicalmente o setor.

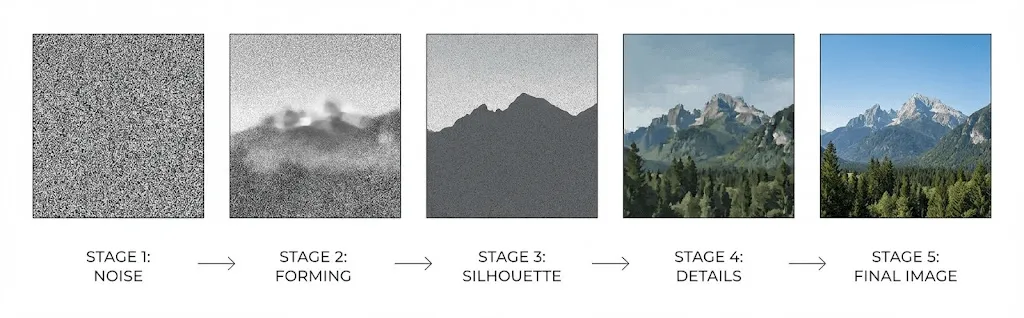

Os modelos de difusão operam através da aprendizagem da reversão de ruído, partindo de uma estática aleatória que é gradualmente refinada até se tornar uma imagem nítida. Ao treinar redes neurais para inverter o processo de adição progressiva de ruído a uma imagem original, essa tecnologia permite reconstruir visualmente conteúdos complexos a partir de um estado de estática pura.

Processo direto: Durante esta etapa, uma imagem de treinamento recebe a adição progressiva de ruído gaussiano que, ao longo de cerca de mil passos, a converte gradualmente em uma estática visual irreconhecível.

Processo de reversão: Por meio do treinamento de uma rede capaz de prever e remover o ruído em cada etapa, reconstrói-se gradualmente uma imagem coerente a partir de uma base de pura aleatoriedade.

A superioridade desta tecnologia em relação às GANs reside em sua abordagem processual, que oferece uma estabilidade inerente ao dispensar o equilíbrio de dinâmicas adversárias. Graças a esse método, os modelos conseguem gerar resultados mais diversificados e interpretar comandos complexos com uma precisão e confiabilidade significativamente maiores.

Com a publicação do artigo "Diffusion Models Beat GANs on Image Synthesis" em 2021, Dhariwal e Nichol oficializaram a supremacia dos modelos de difusão, consolidando-os definitivamente como a tecnologia de ponta para a síntese de imagens.

Como funciona a IA de texto para imagem: entenda o fluxo passo a passo

Entenda o que acontece nos bastidores quando você insere um prompt no Stable Diffusion, DALL-E ou Midjourney:

Etapa 1: Codificação de texto via CLIP

O processo inicia-se com a análise do seu texto por um codificador, geralmente o CLIP (Contrastive Language Image Pre-training), desenvolvido pela OpenAI.

Treinado com 400 milhões de pares de imagens e textos para compreender as complexas relações entre a linguagem e os conceitos visuais, o CLIP converte seus prompts em vetores de alta dimensão — geralmente de 768 ou 1024 dimensões — que capturam com precisão todo o significado semântico.

Este vetor reside em um "espaço de incorporação" compartilhado que agrupa conceitos correlatos, permitindo que termos como "cachorro" e "filhote" gerem vetores próximos, enquanto palavras como "cachorro" e "arranha-céu" resultam em coordenadas totalmente distintas.

Etapa 2: O processamento no espaço latente

É aqui que a tecnologia se torna verdadeiramente sofisticada: para contornar a alta exigência computacional do processamento direto de imagens em alta resolução, os sistemas modernos operam no chamado "espaço latente", uma representação comprimida e altamente eficiente.

Ao apresentarem o Stable Diffusion em seu artigo de 2022, Rombach et al. demonstraram que o processo de difusão poderia ocorrer nesse espaço comprimido sem qualquer perda de qualidade, um avanço tecnológico fundamental que democratizou o acesso a essa inovação para o grande público.

Ao comprimir imagens de 512x512 para uma representação latente de apenas 64x64, o Stable Diffusion alcança uma redução de 48 vezes no volume de dados, o que permite seu processamento em GPUs domésticas sem a necessidade de infraestruturas complexas como centros de dados.

O processo de geração inicia-se com a introdução de ruído aleatório neste espaço latente, funcionando como uma tela de estática altamente comprimida e difusa.

Etapa 3: Redução iterativa de ruído

O núcleo deste processo reside na U-Net — uma arquitetura de rede neural em formato de "U" originalmente desenvolvida para segmentação de imagens médicas — que realiza a remoção progressiva de ruído ao longo de um ciclo que compreende, geralmente, de 20 a 50 iterações.

Em cada etapa do processo, a rede U-Net recebe:

- A representação latente ruidosa processada no estágio atual

- O embedding de texto derivado do CLIP, que integra o prompt codificado

- Um marcador temporal que sinaliza a etapa exata do ciclo de difusão

A rede estima a quantidade de ruído presente na imagem para removê-lo de forma calculada, estabelecendo a composição e as formas principais nas etapas iniciais e refinando texturas e detalhes nas fases posteriores.

O embedding de texto orienta esse processo por meio de mecanismos de "atenção cruzada", permitindo que a rede analise criteriosamente as partes mais relevantes do seu prompt ao determinar exatamente o que deve ser adicionado ou removido em cada ponto da composição.

Etapa 4: A decodificação final em pixels

Após a conclusão da redução de ruído, um decodificador (Autoencoder Variacional ou VAE) restaura a representação latente à sua resolução total por meio do "upsampling", reconstruindo meticulosamente os detalhes refinados que haviam sido comprimidos inicialmente.

CFG (Guidance Scale): O ajuste fundamental que define o nível de precisão e fidelidade aos seus prompts

Quem utiliza o Stable Diffusion certamente já se deparou com os termos “CFG” ou “guidance scale”, parâmetros que determinam o nível de fidelidade do modelo em relação ao prompt inserido. Embora a maioria dos usuários mantenha o valor padrão de 7 recomendado em tutoriais, compreender o funcionamento dessa escala é fundamental para obter um controle mais preciso e refinado sobre os resultados gerados.

O termo CFG, abreviação de "classifier free guidance", refere-se ao processo em que o modelo realiza uma execução dupla durante cada etapa de redução de ruído (denoising):

- A primeira etapa analisa como a imagem deve ser construída a partir do seu prompt, traduzindo o texto em elementos visuais específicos.

- Simultaneamente, o sistema processa uma versão sem qualquer instrução para determinar qual seria a aparência de uma imagem genérica naquela base.

O resultado final destaca o contraste entre essas duas previsões, sendo que valores de CFG mais elevados orientam a imagem para que esta reflita com maior fidelidade os conceitos definidos no seu prompt.

No entanto, há um ponto de equilíbrio necessário:

- CFG Baixo (1-5): Prioriza a liberdade criativa, embora possa resultar em imagens que ignoram parte das instruções do prompt.

- CFG Médio (7-12): Representa o ponto de equilíbrio ideal, sendo a configuração mais indicada para obter resultados consistentes.

- CFG Alto (15+): Garante uma adesão rigorosa ao comando, mas corre o risco de gerar saturação excessiva e artefatos visuais indesejados.

Comparativo entre as Principais Ferramentas: DALL-E, Midjourney e Stable Diffusion

Atualmente, os principais geradores de imagens baseiam-se em modelos de difusão, embora apresentem variações significativas em suas implementações técnicas.

DALL-E 3 (OpenAI)

Ao integrar o ChatGPT diretamente, a OpenAI utiliza o GPT-4 para expandir e refinar os comandos inseridos, permitindo que o DALL-E entregue resultados surpreendentemente sofisticados mesmo a partir de instruções simples. Se por um lado essa facilidade favorece usuários casuais, por outro pode reduzir o controle de usuários avançados que buscam precisão absoluta, destacando-se notavelmente pela sua capacidade de renderizar textos internos — uma funcionalidade que historicamente representava um desafio para os geradores de IA.

Midjourney

O modelo do Midjourney privilegia a qualidade estética em detrimento da precisão literal, produzindo resultados com um estilo artístico ou cinematográfico que muitos consideram visualmente superior ao de outros geradores, ainda que as imagens nem sempre correspondam fielmente ao prompt original. Embora sua interface baseada no Discord seja considerada atípica, ela foi fundamental para consolidar uma comunidade robusta, apesar de a plataforma ser menos transparente sobre seus detalhes técnicos em comparação aos seus principais concorrentes.

Stable Diffusion

Esta solução de código aberto permite a execução local com total transparência e liberdade de modificação, o que impulsionou a criação de um vasto ecossistema de modelos ajustados, extensões e LoRAs para a inclusão de conceitos específicos. Ideal para quem exige controle máximo, privacidade ou o treinamento de modelos próprios, esta opção destaca-se pela sua versatilidade, embora apresente uma curva de aprendizado mais acentuada do que as demais alternativas.

Adobe Firefly

Treinado exclusivamente com o acervo do Adobe Stock, conteúdos de licença aberta e obras de domínio público, nosso modelo oferece a segurança jurídica necessária para aplicações comerciais de alto nível. Além da integração nativa com o Photoshop e Illustrator, a ferramenta diferencia-se por priorizar resultados equilibrados e profissionais, evitando deliberadamente a geração de conteúdos controversos ou inadequados.

Muito além da geração básica

A geração de imagens a partir de texto é apenas o ponto de partida, visto que os sistemas modernos contam com funcionalidades avançadas que ampliam significativamente as possibilidades de criação.

Imagem para Imagem (img2img)

Diferente do processo que parte do ruído absoluto, este método utiliza uma imagem base que recebe uma carga parcial de ruído, sendo que a intensidade dessa transformação é gerida pelo parâmetro "força de redução de ruído" (denoising strength). Enquanto níveis baixos resultam em refinamentos estilísticos sutis, valores mais elevados permitem uma reimaginação completa da imagem, preservando apenas a estrutura composicional do arquivo original.

Inpainting e Outpainting

Com o recurso de inpainting, é possível regenerar áreas específicas de uma imagem para remover ou substituir elementos com precisão e sem afetar o restante da composição, ao passo que o outpainting permite expandir os limites originais para criar novos conteúdos que dão continuidade à cena de forma natural e perfeitamente coerente.

ControlNet

O ControlNet introduz uma camada de orientação estrutural ao processo de geração, permitindo o uso de mapas de bordas, profundidade, esqueletos de pose ou máscaras de segmentação para definir com exatidão o posicionamento dos elementos. Esse nível de controle é essencial para garantir a consistência no design de personagens e para obter uma precisão espacial que vai além das capacidades de um prompt de texto convencional.

LoRA e DreamBooth

Deseja que a IA gere imagens de pessoas, produtos ou estilos específicos que não constavam nos dados de treinamento originais? Por meio do LoRA (Low Rank Adaptation) e do DreamBooth, é possível realizar o ajuste fino de modelos utilizando pequenos conjuntos de dados personalizados — muitas vezes com apenas 20 ou 30 imagens —, permitindo a criação precisa de qualquer conceito sob demanda.

Limitações Atuais e Suas Origens

Compreender as limitações inerentes aos geradores de imagens por IA é o primeiro passo para aprender a contorná-las de maneira eficaz.

O Notório Desafio da Representação de Mãos

Os geradores de IA são amplamente conhecidos pela dificuldade em representar mãos, gerando frequentemente dedos fundidos, em número incorreto ou em anatomias impossíveis; longe de ser um mero erro técnico, tal limitação constitui um desafio fundamental da própria tecnologia.

Nos dados de treinamento, as mãos surgem em ângulos, posições e níveis de oclusão extremamente variados, recebendo menos atenção durante o processo por serem pequenas em relação à imagem total. Como os padrões estatísticos de uma mão correta são mais complexos de aprender do que feições consistentes como rostos, o tema permanece um desafio técnico, apesar dos avanços significativos nos modelos recentes.

Renderização de Texto

Até o lançamento do DALL-E 3, gerar textos legíveis em imagens era um desafio quase intransponível, visto que os modelos compreendem a semântica das palavras, mas têm dificuldade em representar visualmente a tipografia. Embora o DALL-E 3 tenha progredido consideravelmente nessa área, layouts de texto complexos ainda não apresentam total confiabilidade em nenhuma das plataformas atuais.

Consistência visual entre as imagens

Como cada processo de geração se inicia a partir de um ruído aleatório distinto, manter a consistência de personagens ou cenários torna-se um desafio complexo; embora existam recursos como o bloqueio de sementes, imagens de referência e LoRAs, tais soluções ainda não resolvem o problema plenamente, o que acaba por limitar casos de uso como a produção de histórias em quadrinhos ou o desenvolvimento de identidades visuais de marcas.

Raciocínio Espacial

Comandos como "a bola vermelha à esquerda do cubo azul, que está atrás da pirâmide verde" frequentemente resultam em composições imprecisas, visto que, apesar de identificarem objetos individuais, os modelos ainda enfrentam desafios ao interpretar relações espaciais complexas entre múltiplos elementos.

A Questão dos Direitos Autorais

É neste ponto que as implicações se tornam mais complexas, envolvendo desafios significativos nos âmbitos jurídico e ético.

Dados de Treinamento

A maioria dos modelos de IA geradora de imagens baseia-se no treinamento com bilhões de arquivos coletados na internet, muitas vezes sem o consentimento explícito dos autores originais, o que tem motivado diversos processos judiciais sobre possíveis violações de direitos autorais em um cenário jurídico que permanece incerto.

Propriedade dos Resultados

Nos Estados Unidos, o Escritório de Direitos Autorais estabeleceu que imagens geradas exclusivamente por IA não podem ser protegidas, uma vez que o direito autoral exige obrigatoriamente a autoria humana. Contudo, obras que apresentem uma "contribuição criativa humana suficiente" durante o processo podem ser qualificadas para proteção, embora a definição exata desse limite permaneça incerta e continue sendo objeto de intensos debates e litígios judiciais.

Os termos de serviço da plataforma também são fundamentais e, embora a maioria das soluções comerciais conceda aos usuários os direitos sobre as imagens geradas, recomendamos a leitura atenta das letras miúdas para garantir a conformidade com o seu caso de uso específico.

Dicas práticas para obter resultados superiores

Compreender a tecnologia subjacente permite criar prompts mais assertivos e eficazes; veja a seguir o que realmente funciona na prática:

Destaque os conceitos fundamentais

O codificador de texto pondera as palavras conforme a sua posição, o que significa que expressões como "Pôr do sol, iluminação dramática, paisagem montanhosa" recebem uma ênfase diferente de "Uma paisagem com montanhas ao pôr do sol"; por isso, priorize sempre os elementos mais importantes logo no início da descrição.

Utilize referências familiares ao modelo

Os modelos baseiam seu aprendizado em dados de treinamento, o que faz com que referências a artistas, estilos ou equipamentos específicos — como o filme "Kodak Portra 400" — ativem padrões visuais com muito mais precisão do que termos genéricos. Dessa forma, utilizar conceitos como "iluminação Rembrandt" torna-se consideravelmente mais eficaz do que recorrer a descrições abstratas, como "iluminação lateral dramática".

Priorize a iteração em vez da perfeição

O processo de geração raramente atinge a perfeição imediata, por isso é fundamental explorar variações e identificar os elementos mais eficazes para o refinamento contínuo do seu prompt. Ao aplicar o recurso img2img em resultados promissores, você pode iterar sobre aspectos específicos da imagem, garantindo precisão técnica enquanto preserva a harmonia da composição original.

Utilize prompts negativos

Os prompts negativos permitem especificar exatamente o que deve ser evitado — como imagens borradas, distorcidas ou com marcas d'água — ao reduzir a influência desses conceitos durante o processo de redução de ruído. Ao consolidar uma biblioteca robusta de termos negativos, é possível prevenir falhas comuns e garantir resultados consistentemente superiores e mais precisos.

O Que Vem a Seguir

Em um setor que evolui em ritmo acelerado, destacam-se alguns avanços fundamentais que merecem ser acompanhados de perto:

- Geração de vídeo: Plataformas como Sora e Runway Gen 3 expandem a tecnologia de difusão para o audiovisual, tornando a criação de vídeos de alta qualidade a partir de comandos de texto uma realidade cada vez mais concreta.

- Geração em 3D: A rápida maturação das ferramentas de conversão de texto e imagem para 3D está abrindo novas fronteiras para o desenvolvimento de games, a visualização de produtos e a realidade virtual.

- Geração em tempo real: Graças a otimizações constantes, o processamento atinge velocidades interativas que já permitem gerar imagens em menos de um segundo.

- Consistência aprimorada: Novas arquiteturas focam na estabilidade de personagens e cenários, um avanço fundamental para viabilizar fluxos de trabalho em animações e histórias em quadrinhos.

Perguntas frequentes

Quanto tempo leva o processo de geração de imagens?

Enquanto os serviços em nuvem costumam levar de 10 a 30 segundos para gerar imagens, a execução local do Stable Diffusion em GPUs modernas (RTX 3060 ou superior) permite criar arquivos de 512×512 em apenas 2 a 5 segundos, observando que resoluções mais altas e um maior número de etapas exigirão tempos proporcionalmente maiores.

Os geradores de IA copiam imagens já existentes?

Na verdade, em vez de armazenarem cópias, esses modelos aprendem padrões estatísticos complexos; no entanto, como imagens icônicas podem ser "memorizadas" até certo ponto, a geração de resultados que emulam estilos de artistas específicos acaba fomentando debates intensos sobre direitos autorais.

Por que a representação de mãos é tão desafiadora?

Devido à extrema variabilidade de ângulos e posições nos dados de treinamento, as mãos recebem menor ênfase estatística por ocuparem uma área reduzida na maioria das imagens de corpo inteiro. Essa inconsistência torna o aprendizado de padrões muito mais complexo do que o de características uniformes, permanecendo como um desafio técnico que, embora esteja em constante evolução, ainda exige superação.

Posso utilizar imagens geradas por IA para fins comerciais?

A viabilidade do uso comercial depende da plataforma escolhida e da jurisdição local, sendo que a maioria dos serviços comerciais já prevê a concessão desses direitos em seus termos de uso. No entanto, como produções geradas integralmente por IA podem não ser passíveis de direitos autorais em certas regiões, como nos Estados Unidos, o Adobe Firefly foi projetado especificamente para fins profissionais ao ser treinado exclusivamente com conteúdos licenciados.

Quais são as principais diferenças entre os modelos de difusão e as redes GAN?

Enquanto as GANs operam por meio da competição entre redes geradoras e discriminadoras, os modelos de difusão baseiam-se na reversão de um processo gradual de adição de ruído. Atualmente, a difusão consolidou-se como a tecnologia líder por oferecer maior estabilidade de treinamento e resultados mais variados, além de interpretar e seguir os prompts com uma precisão e fidelidade superiores.

Conclusão

Longe de serem mágicos, os geradores de imagens por IA baseiam-se em modelos de difusão que convertem textos em processos guiados de redução de ruído. Ao combinar a compreensão de linguagem com padrões visuais e refinamentos iterativos, estes sistemas sofisticados transformam descrições em imagens detalhadas, passo a passo.

Ao inserir um comando, o sistema processa as informações por meio de codificadores de texto treinados em centenas de milhões de associações entre imagens e palavras, orientando um fluxo de redução de ruído em espaço latente até a decodificação final em alta resolução. Compreender o funcionamento desse processo, mesmo que de forma simplificada, é fundamental para que você domine a ferramenta e obtenha resultados com muito mais eficácia.

Mais do que apenas inserir comandos em uma caixa de texto, você fornece sinais de condicionamento a um processo matemático que interpreta sua linguagem e orienta a remoção de ruído por meio de padrões aprendidos, reconstruindo imagens de forma integral.

Mais do que apenas saciar a curiosidade, esse entendimento é fundamental para que você elabore prompts mais precisos, defina expectativas realistas e escolha as ferramentas ideais para cada projeto. Com a rápida evolução tecnológica, essa base sólida permitirá que você se adapte com facilidade e acompanhe as constantes transformações do setor.