¿Cómo funcionan los generadores de imágenes por IA? El proceso de prompt a imagen paso a paso

Última actualización: 2026-01-22 18:08:25

¿Qué sucede tras introducir un prompt? Una explicación clara y precisa sobre el proceso de generación

Es una experiencia que a estas alturas ya nos resulta familiar: basta con introducir una descripción como «un gato con sombrero de mago, estilo óleo» en herramientas como Midjourney o DALL-E para que, en apenas 30 segundos, cobren vida imágenes totalmente inéditas en un proceso que parece rozar lo mágico.

Lejos de ser magia, este proceso se fundamenta en complejos modelos matemáticos cuya comprensión, más allá del interés académico, resulta clave para dominar estas herramientas. Al entender los motivos por los que ciertos prompts son efectivos, dejará de depender del azar para empezar a diseñar sus creaciones con absoluta precisión.

Analicemos el funcionamiento de esta tecnología de manera clara y directa, profundizando lo suficiente para comprender qué ocurre internamente sin necesidad de recurrir a complejos estudios académicos.

Resumen rápido (30 segundos):

Los generadores de imágenes por IA transforman sus prompts en representaciones numéricas (text embeddings) para procesarlos en un «espacio latente» comprimido donde, partiendo de ruido aleatorio, un modelo de difusión lo elimina paso a paso siguiendo sus instrucciones hasta decodificar el resultado final en píxeles. Para garantizar una precisión absoluta, parámetros como el CFG (escala de guía), los pasos y las semillas permiten controlar tanto la fidelidad a la instrucción original como la consistencia de las imágenes generadas.

Los dos problemas fundamentales que resuelven los generadores de imágenes con IA

El funcionamiento de cualquier generador de imágenes por IA se fundamenta en la resolución de dos procesos distintos pero estrechamente vinculados: la interpretación de las instrucciones y la posterior creación visual de la imagen.

El primer desafío: la comprensión de la intención del usuario. Al introducir una descripción como «atardecer sobre las montañas con iluminación dramática», el sistema debe procesar estas palabras para transformarlas en conceptos visuales ejecutables. Es aquí donde interviene el procesamiento de lenguaje natural, permitiendo a la IA interpretar la estética de un término como «dramático» y determinar la interacción exacta entre los colores del ocaso y las sombras del paisaje.

El segundo desafío: la materialización de los píxeles. Mediante la visión computacional, el sistema procesa millones de valores cromáticos para dar vida a objetos coherentes, iluminaciones realistas y perspectivas precisas que sigan estrictamente sus instrucciones.

Los sistemas modernos resuelven ambos desafíos mediante el uso de redes neuronales, estructuras computacionales inspiradas en la forma en que las neuronas biológicas se conectan y comunican entre sí.

Redes neuronales: el pilar fundamental

Antes de analizar en detalle las diversas arquitecturas, es esencial comprender el funcionamiento interno de las redes neuronales y su interacción con los datos visuales.

A diferencia de la percepción humana, los ordenadores interpretan las imágenes como extensas cuadrículas numéricas donde una pieza de 512×512 píxeles se traduce en 786.432 valores individuales distribuidos en tres canales de color. Ante tal magnitud de datos, la función principal de la red neuronal consiste en identificar patrones coherentes y extraer significado de este vasto flujo de información.

Durante su fase de entrenamiento, estas redes procesan millones de imágenes para asimilar patrones visuales complejos; un ejemplo representativo es Stable Diffusion, desarrollado a partir de LAION 5B, un conjunto de datos con cerca de 5.850 millones de pares de imagen y texto recopilados de fuentes públicas en la web. Al vincular cada imagen con su información textual asociada —como etiquetas "alt", subtítulos y contenido circundante—, el modelo logra establecer asociaciones precisas entre el lenguaje y los conceptos visuales.

Mediante este proceso, la red neuronal asimila patrones en diversos niveles de complejidad: mientras que las capas iniciales detectan bordes y formas fundamentales, las intermedias identifican elementos específicos como ojos, ruedas u hojas, permitiendo que las capas más profundas comprendan conceptos y estilos artísticos en su totalidad.

La evolución tecnológica: de las redes GAN a los modelos de difusión

El panorama de la generación de imágenes mediante IA ha experimentado una transformación radical en los últimos años, una evolución que permite comprender por qué las herramientas actuales ofrecen una eficacia muy superior a la que conocíamos hace apenas tres años.

La era de las redes GAN (2014-2021)

Desde su presentación por Ian Goodfellow en 2014, las Redes Generativas Antagónicas (GAN) lideraron el sector durante años gracias a un concepto tan elegante como innovador: el enfrentamiento estratégico entre dos redes neuronales.

A través de una interacción constante, el generador crea imágenes mientras el discriminador se encarga de identificarlas, estableciendo una dinámica competitiva donde la mejora de uno impulsa la evolución del otro. Este proceso de perfeccionamiento mutuo obliga a ambas redes a superar sus límites técnicos hasta alcanzar un nivel de precisión y excelencia excepcional.

Hacia 2019, las redes GAN demostraron un potencial asombroso a través de StyleGAN y su capacidad para crear rostros fotorrealistas de personas inexistentes; sin embargo, este modelo presentaba limitaciones críticas, como un entrenamiento inestable derivado de la desincronización de sus redes y dificultades para procesar escenas complejas o detalles minuciosos como las manos.

La revolución de la difusión (2020 – actualidad)

Descubra cómo los generadores de imágenes IA transforman prompts de texto en píxeles mediante modelos de difusión y procesos matemáticos avanzados.

En 2020, la publicación del estudio «Denoising Diffusion Probabilistic Models» (DDPMs) a cargo de Jonathan Ho, Ajay Jain y Pieter Abbeel en la UC Berkeley supuso un punto de inflexión que transformó por completo el panorama tecnológico.

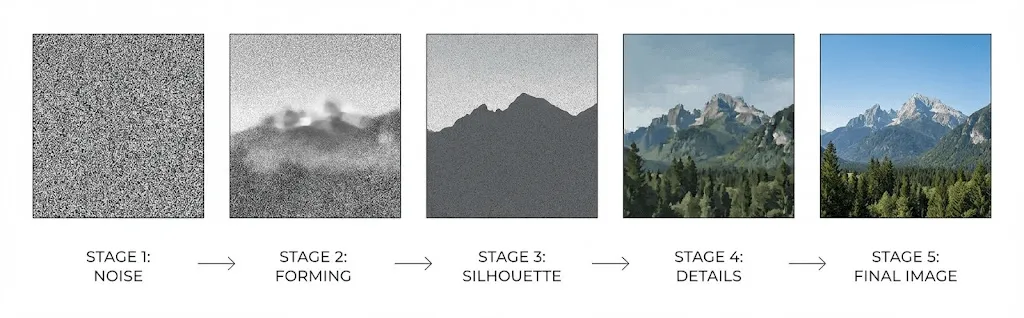

Los modelos de difusión operan mediante el aprendizaje inverso del ruido, transformando gradualmente la estática aleatoria en imágenes nítidas a través de un proceso de depuración visual. Para lograrlo, se entrena a una red neuronal analizando la degradación de una imagen hasta su estado de estática pura, permitiéndole así dominar la técnica necesaria para reconstruir cualquier contenido desde cero.

Proceso de difusión directa: Consiste en añadir ruido gaussiano de forma progresiva a una imagen de entrenamiento a lo largo de múltiples etapas —generalmente unos 1.000 pasos— hasta que la composición original se transforma por completo en una señal estática irreconocible.

Proceso inverso: mediante el entrenamiento de redes neuronales capaces de predecir y eliminar el ruido en cada etapa, el sistema logra reconstruir progresivamente una imagen coherente a partir de la aleatoriedad absoluta.

A diferencia de las GAN, este enfoque progresivo garantiza una mayor estabilidad al eliminar la necesidad de equilibrar dinámicas adversarias, lo que permite generar resultados más diversos y seguir prompts complejos con una precisión superior.

En 2021, la publicación de Dhariwal y Nichol titulada «Diffusion Models Beat GANs on Image Synthesis» marcó un hito definitivo al consolidar oficialmente a los modelos de difusión como la tecnología líder en la síntesis de imágenes.

Funcionamiento de la IA de texto a imagen: guía detallada de su arquitectura y procesos paso a paso

Descubra qué sucede realmente tras bastidores al introducir un prompt en Stable Diffusion, DALL-E o Midjourney:

Paso 1: Codificación de texto mediante CLIP

El proceso se inicia al procesar el texto mediante un codificador, habitualmente el modelo CLIP (Contrastive Language-Image Pre-training) desarrollado por OpenAI.

Entrenado a partir de 400 millones de pares de imágenes y texto para comprender la relación intrínseca entre el lenguaje y los conceptos visuales, CLIP transforma cada instrucción en un vector de alta dimensión —generalmente de 768 o 1024 dimensiones— capaz de capturar con total precisión su significado semántico.

Este vector se sitúa en un "espacio de embedding" compartido donde los conceptos afines se agrupan, permitiendo que términos como "perro" y "cachorro" generen vectores similares, mientras que conceptos tan dispares como "perro" y "rascacielos" dan lugar a resultados claramente diferenciados.

Paso 2: El procesamiento en el espacio latente

Para optimizar el rendimiento y evitar la alta carga computacional que supone procesar imágenes de alta resolución, los sistemas modernos operan de manera inteligente en el «espacio latente», una representación comprimida sumamente eficiente.

En el artículo de 2022 que introdujo Stable Diffusion, Rombach et al. demostraron que la difusión podía ejecutarse en este espacio comprimido sin sacrificar la calidad, logrando un avance fundamental que democratizó el acceso a esta tecnología para el público general.

Stable Diffusion optimiza el procesamiento al comprimir imágenes de 512×512 píxeles en representaciones latentes de solo 64×64; esta reducción de 48 veces es la clave que permite ejecutar el modelo en GPUs de consumo sin necesidad de recurrir a la infraestructura de un centro de datos.

El proceso de generación se inicia a partir del ruido aleatorio en este espacio latente, el cual funciona como un lienzo de estática sumamente comprimido y difuso.

Paso 3: Eliminación iterativa del ruido

En el corazón de este proceso se encuentra la arquitectura U-Net —una red neuronal diseñada originalmente para la segmentación de imágenes médicas—, la cual se encarga de eliminar el ruido mediante un ciclo iterativo que suele constar de entre 20 y 50 pasos.

Durante cada etapa del proceso, la red U-Net recibe la siguiente información:

- La representación latente actual, procesada junto con el ruido remanente

- El embedding de texto de CLIP, que integra la información de su prompt codificado

- Un marcador temporal que define la etapa exacta del ciclo de generación

Mediante el cálculo y la eliminación progresiva del ruido detectado en la imagen, la red define inicialmente la composición y las formas generales para, posteriormente, perfeccionar minuciosamente cada textura y detalle.

Mediante mecanismos de atención cruzada (cross-attention), el embedding de texto orienta todo el proceso, permitiendo que la red se centre en los fragmentos más relevantes de su descripción para determinar con precisión qué elementos añadir o eliminar en cada punto de la imagen.

Paso 4: Decodificación y conversión final a píxeles

Una vez finalizado el proceso de eliminación de ruido, un decodificador (Autoencoder Variacional o VAE) expande la representación latente comprimida hasta alcanzar su resolución completa, reconstruyendo mediante este "upsampling" los detalles precisos que se habían omitido durante la compresión inicial.

CFG (Guidance Scale): El parámetro determinante para ajustar la precisión y fidelidad de sus prompts

Si utiliza Stable Diffusion, es probable que se haya encontrado con los parámetros “CFG” o “escala de guía”, los cuales determinan la fidelidad con la que el modelo interpreta sus instrucciones. Aunque la mayoría de los usuarios suelen mantener el valor predeterminado de 7 siguiendo las recomendaciones generales, comprender su funcionamiento técnico le permitirá optimizar sus creaciones y obtener un control mucho más preciso sobre los resultados finales.

El parámetro CFG, siglas de "classifier free guidance", consiste en ejecutar el modelo por duplicado durante cada paso del proceso de eliminación de ruido:

- Análisis con prompt: el sistema determina la composición visual basándose específicamente en las indicaciones del texto proporcionado.

- Evaluación sin prompt: se define la apariencia que tendría una imagen genérica para establecer un punto de referencia visual.

El resultado final resalta el contraste entre ambas predicciones, permitiendo que valores de CFG más elevados orienten la creación de forma mucho más precisa hacia los conceptos definidos en su prompt.

No obstante, existe una contrapartida:

- CFG Bajo (1-5): Fomenta una mayor libertad creativa, aunque existe el riesgo de que la IA ignore parcialmente las instrucciones del prompt.

- CFG Medio (7-12): Representa el punto de equilibrio ideal para obtener resultados visualmente atractivos y precisos.

- CFG Alto (15+): Prioriza un cumplimiento estricto del prompt, si bien puede provocar una saturación excesiva o la aparición de artefactos en la imagen.

Comparativa de las herramientas líderes: DALL-E frente a Midjourney y Stable Diffusion

Si bien los principales generadores de imágenes actuales se fundamentan en modelos de difusión, su arquitectura e implementación técnica varían de manera significativa.

DALL-E 3 (OpenAI)

Gracias a la integración directa de ChatGPT, el enfoque de OpenAI permite que GPT-4 reescriba y optimice sus instrucciones antes de la creación, logrando que DALL-E genere resultados sorprendentemente sofisticados incluso con comandos sencillos. Si bien esta automatización es ideal para usuarios ocasionales, puede limitar el control de quienes buscan una fidelidad absoluta al texto original; no obstante, el sistema destaca notablemente por su precisión al renderizar texto dentro de las imágenes, superando así uno de los mayores desafíos históricos de la IA generativa.

Midjourney

El modelo de Midjourney está optimizado para priorizar la calidad estética sobre la precisión literal, ofreciendo resultados con un estilo pictórico o cinematográfico que suele resultar visualmente más atractivo que el de otros generadores, incluso cuando no se ciñen estrictamente al prompt original. Por otro lado, su singular interfaz basada en Discord ha logrado consolidar una comunidad robusta, aunque la plataforma es menos transparente que sus competidores en cuanto a sus especificaciones técnicas.

Stable Diffusion

Esta alternativa de código abierto permite la ejecución en local, lo que garantiza total transparencia sobre su funcionamiento y libertad absoluta para realizar modificaciones. Gracias a esta flexibilidad, ha florecido un vasto ecosistema de modelos especializados, extensiones y LoRAs (adaptaciones de bajo rango para integrar conceptos específicos), consolidándose como la opción ideal para quienes buscan el máximo control, privacidad o el entrenamiento de modelos personalizados, a pesar de presentar una curva de aprendizaje más exigente que otras soluciones.

Adobe Firefly

Al estar entrenado exclusivamente con imágenes de Adobe Stock, contenido bajo licencia abierta y obras de dominio público, este modelo resulta idóneo para fines comerciales donde la protección del derecho de autor es primordial. Además de su profunda integración con Photoshop e Illustrator, ofrece por diseño resultados más conservadores que los de la competencia, garantizando así la ausencia de contenido polémico o controvertido.

Más allá de la generación convencional

La generación de texto a imagen es tan solo el punto de partida, ya que los sistemas modernos integran capacidades adicionales de gran valor que merece la pena conocer a fondo.

Imagen a imagen (img2img)

A diferencia de la creación a partir de ruido puro, este método utiliza una imagen base parcialmente procesada donde el parámetro de "fuerza de eliminación de ruido" (denoising strength) regula el nivel de transformación del resultado final. Gracias a este ajuste, es posible obtener desde sutiles variaciones estilísticas con intensidades bajas hasta una reimaginación creativa total en niveles altos, conservando únicamente la estructura compositiva de la imagen original.

Inpainting y outpainting

La técnica de inpainting permite regenerar áreas específicas de una imagen manteniendo el resto intacto, lo que resulta ideal para eliminar o sustituir elementos; por su parte, el outpainting expande la obra más allá de sus límites originales, generando contenido coherente que prolonga la escena de forma natural.

ControlNet

ControlNet integra una guía estructural en el proceso de generación que permite, mediante el uso de mapas de bordes, profundidad, esqueletos de pose o máscaras de segmentación, definir con total precisión la ubicación de cada elemento. Esta funcionalidad resulta esencial para garantizar la consistencia en el diseño de personajes y obtener un control espacial riguroso que las instrucciones de texto por sí solas no pueden ofrecer.

LoRA y DreamBooth

¿Busca generar imágenes de personas, productos o estilos específicos que no figuraban en el entrenamiento inicial? Mediante técnicas como LoRA (Low Rank Adaptation) y DreamBooth, es posible realizar un ajuste fino del modelo con apenas 20 o 30 imágenes personalizadas, obteniendo así una herramienta optimizada capaz de recrear dicho concepto exacto bajo demanda.

Limitaciones actuales (y el porqué de su existencia)

Identificar las limitaciones habituales de los generadores de imágenes por IA resulta fundamental para aprender a sortearlas y optimizar sus resultados con eficacia.

El célebre problema de las manos

Es común que los generadores de IA produzcan manos con un número incorrecto de dedos, extremidades fusionadas o estructuras anatómicamente imposibles, una limitación que, lejos de ser un simple error técnico, constituye un desafío fundamental para la tecnología actual.

Debido a que las manos aparecen en los datos de entrenamiento con una enorme variabilidad de ángulos, posiciones y oclusiones, su aprendizaje resulta complejo para los modelos de IA. Al ocupar un área reducida en comparación con el resto de la imagen, estos elementos suelen recibir una menor prioridad durante el entrenamiento, lo que, sumado a la dificultad de capturar patrones estadísticos menos consistentes que los de un rostro, hace que su representación siga siendo un desafío técnico a pesar de las mejoras en las versiones más recientes.

Representación de texto

Hasta el lanzamiento de DALL-E 3, generar texto legible en imágenes resultaba prácticamente imposible, ya que los modelos logran captar el significado semántico de las palabras pero suelen presentar dificultades con su ejecución tipográfica. Si bien DALL-E 3 ha marcado un progreso significativo en este ámbito, la fiabilidad en composiciones de texto complejas sigue siendo un desafío pendiente en todas las plataformas actuales.

Consistencia visual entre imágenes

Dado que cada proceso de generación parte de un ruido aleatorio distinto, lograr una consistencia total en personajes o escenas resulta complejo; aunque existen soluciones como el bloqueo de semillas, las imágenes de referencia o los modelos LoRA, ninguna logra resolver este desafío por completo, limitando así su aplicación en el desarrollo de cómics o en la identidad visual de marca.

Razonamiento espacial

Aunque los modelos actuales identifican objetos individuales con precisión, suelen presentar dificultades al interpretar relaciones espaciales complejas entre múltiples elementos, lo que a menudo resulta en composiciones incorrectas ante instrucciones detalladas como «la bola roja a la izquierda del cubo azul y detrás de la pirámide verde».

La cuestión de los derechos de autor

Es precisamente en este punto donde convergen los desafíos legales y éticos más complejos.

Datos de entrenamiento

La gran mayoría de los modelos de generación de imágenes por IA se han entrenado utilizando miles de millones de obras extraídas de internet, frecuentemente sin el consentimiento explícito de sus autores originales. Esta práctica ha derivado en múltiples procesos judiciales que cuestionan la posible infracción de los derechos de autor, dentro de un panorama legal que aún se encuentra en una fase de profunda incertidumbre.

Propiedad de los contenidos generados

La Oficina de Derechos de Autor de los Estados Unidos ha dictaminado que las imágenes generadas íntegramente por IA no pueden acogerse a la protección de copyright, ya que esta requiere obligatoriamente una autoría humana. No obstante, aquellas obras que incorporen una "aportación creativa humana suficiente" podrían calificar para su registro, si bien la delimitación exacta de este criterio sigue siendo incierta y se encuentra actualmente bajo litigio.

Asimismo, los términos de servicio de la plataforma juegan un papel fundamental; aunque la mayoría de los servicios comerciales otorgan derechos sobre las imágenes generadas, es recomendable revisar la letra pequeña para asegurar que se ajusten a su caso de uso específico.

Consejos prácticos para optimizar tus resultados

Comprender la tecnología subyacente le permitirá perfeccionar sus instrucciones para maximizar el rendimiento de la IA; a continuación, le presentamos las claves que realmente funcionan:

Priorice los conceptos fundamentales desde el inicio

Debido a que el codificador de texto pondera las palabras en función de su posición, el énfasis varía significativamente entre una descripción como «atardecer, iluminación dramática, paisaje montañoso» y «un paisaje con montañas al atardecer», por lo que resulta esencial situar siempre los elementos más relevantes al inicio de su prompt.

Utilice referencias reconocidas por el modelo

Dado que estos modelos se basan en el aprendizaje de datos de entrenamiento, el uso de referencias a artistas, movimientos estéticos o tipos de película específicos (como "Kodak Portra 400") activa patrones visuales con mayor precisión que las descripciones abstractas, permitiendo que términos técnicos como "iluminación Rembrandt" ofrezcan resultados mucho más fiables que una simple "luz lateral dramática".

Priorice la iteración por encima de la perfección

Dado que la creación de imágenes rara vez se logra en un solo intento, es fundamental generar diversas variaciones para identificar los elementos más efectivos y perfeccionar sus prompts. Asimismo, el uso de la función img2img sobre sus resultados exitosos le permitirá iterar en detalles específicos mientras preserva la esencia de la composición original.

Optimice sus creaciones mediante el uso de prompts negativos

Los prompts negativos permiten definir con precisión los elementos que se desean excluir —como desenfoques, distorsiones o marcas de agua— al minimizar la influencia de estos conceptos durante el proceso de eliminación de ruido. Al consolidar una biblioteca optimizada de este tipo de instrucciones, es posible prevenir los fallos más habituales y elevar significativamente la calidad técnica de las imágenes generadas.

Próximas innovaciones

Dada la rápida evolución de este sector, existen diversos avances tecnológicos clave que merece la pena seguir de cerca:

- Generación de vídeo: soluciones como Sora o Runway Gen 3 están extendiendo la tecnología de difusión al ámbito del vídeo, consolidando la creación de contenido audiovisual de alta calidad a partir de texto como una realidad tangible.

- Generación 3D: el rápido perfeccionamiento de las herramientas de conversión de texto e imagen a modelos tridimensionales está transformando sectores estratégicos como el desarrollo de videojuegos, la visualización de productos y la realidad virtual.

- Generación en tiempo real: gracias a las constantes optimizaciones técnicas, se han alcanzado velocidades de procesamiento interactivas que permiten generar imágenes en menos de un segundo.

- Mayor consistencia: el desarrollo de nuevas arquitecturas está resolviendo los desafíos de coherencia en personajes y escenas, lo que permitirá desbloquear nuevos casos de uso en campos como el cómic y la animación.

Preguntas frecuentes

¿Cuánto tiempo requiere el proceso de generación de imágenes?

Mientras que los servicios en la nube suelen procesar las imágenes en un intervalo de 10 a 30 segundos, el uso local de Stable Diffusion con una GPU moderna (RTX 3060 o superior) agiliza la creación de archivos de 512×512 a solo 2 o 5 segundos, aunque dicho tiempo aumentará proporcionalmente al elevar la resolución o el número de pasos.

¿Copian los generadores de IA imágenes ya existentes?

En realidad, estos sistemas no almacenan copias literales, sino que aprenden patrones estadísticos complejos; no obstante, pueden llegar a «memorizar» imágenes sumamente icónicas, lo que suscita intensos debates sobre la propiedad intelectual al generar resultados que replican fielmente el estilo de artistas específicos.

¿Por qué la representación de las manos suele presentar tantas dificultades?

Debido a que las manos aparecen en los datos de entrenamiento bajo una enorme variedad de ángulos y posiciones, su representación precisa resulta compleja, especialmente al ocupar un espacio reducido en las imágenes de cuerpo completo donde suelen recibir un menor énfasis algorítmico. Esta falta de uniformidad dificulta el aprendizaje de sus patrones estadísticos en comparación con rasgos más consistentes y, aunque la tecnología progresa de forma constante, este aspecto sigue representando uno de los mayores retos técnicos actuales.

¿Puedo utilizar imágenes generadas por IA con fines comerciales?

El uso comercial está sujeto a las políticas de cada plataforma y a la legislación de su jurisdicción, si bien la mayoría de los servicios profesionales garantizan estos derechos en sus términos y condiciones. Es importante considerar que, en regiones como Estados Unidos, las obras generadas íntegramente por IA podrían no ser susceptibles de protección por derechos de autor; por este motivo, herramientas como Adobe Firefly se han diseñado específicamente para fines comerciales, entrenándose exclusivamente con contenidos bajo licencia.

¿Qué distingue a los modelos de difusión de las redes GAN?

A diferencia de las GAN, que operan mediante la confrontación entre redes generativas y discriminativas, los modelos de difusión han pasado a liderar el sector gracias a su capacidad para revertir procesos graduales de ruido. Esta tecnología no solo ofrece una mayor estabilidad durante su entrenamiento, sino que también garantiza resultados más diversos y una fidelidad superior a las instrucciones o prompts originales.

En resumen

Lejos de ser un proceso mágico, los generadores de imágenes IA operan mediante modelos de difusión que transforman el texto en realidad a través de una eliminación de ruido guiada paso a paso. Estos sofisticados sistemas integran la comprensión profunda del lenguaje con patrones visuales aprendidos y un refinamiento iterativo, logrando generar imágenes precisas a partir de cualquier descripción.

Al introducir un prompt, el sistema lo procesa mediante codificadores entrenados con cientos de millones de pares de imagen y texto, guiando así un proceso de eliminación de ruido en un espacio latente comprimido que culmina con la decodificación de la imagen a resolución completa. Comprender el funcionamiento de este flujo de trabajo, incluso de forma general, le permitirá optimizar sus resultados y convertirse en un usuario mucho más eficiente.

Lejos de ser una simple entrada de deseos, sus instrucciones constituyen señales de condicionamiento para un proceso matemático que interpreta el lenguaje y dirige la eliminación de ruido mediante patrones aprendidos, logrando así reconstruir imágenes de forma íntegra desde su origen.

Más allá de satisfacer la curiosidad, comprender estos fundamentos le permitirá perfeccionar sus prompts, definir expectativas realistas y seleccionar las herramientas más adecuadas para cada necesidad, proporcionándole una base sólida para adaptarse con éxito a una tecnología en constante evolución.