Come funzionano i generatori di immagini IA: il processo da prompt a immagine spiegato passo dopo passo

Ultimo aggiornamento: 2026-01-22 18:08:25

Scopri come i generatori di immagini IA trasformano i prompt testuali in pixel attraverso l'impiego di modelli di diffusione e sofisticati algoritmi matematici.

Scopri come i generatori di immagini IA trasformano i prompt testuali in pixel attraverso l'impiego di modelli di diffusione e sofisticati algoritmi matematici.

Cosa accade dopo l'inserimento di un prompt? Una spiegazione semplice e accurata del processo.

È un'esperienza ormai comune a molti: basta inserire una descrizione come "un gatto con un cappello da mago, stile pittura a olio" in strumenti quali Midjourney o DALL-E per veder comparire in pochi secondi un'immagine del tutto inedita, un processo talmente fluido da sembrare quasi magico.

Non si tratta di magia, ma di pura matematica; comprendere i meccanismi alla base di questa tecnologia non è solo un esercizio teorico, ma un vantaggio concreto che permette di padroneggiare al meglio gli strumenti a disposizione. Conoscere le dinamiche che rendono efficace un prompt consente infatti di abbandonare le congetture, trasformando ogni creazione in un processo consapevole e mirato.

Scopriamo insieme il funzionamento di questa tecnologia: senza addentrarci in complessi tecnicismi accademici, esploreremo i processi fondamentali per offrirvi una comprensione chiara di ciò che avviene effettivamente dietro le quinte.

Sintesi rapida (30 secondi):

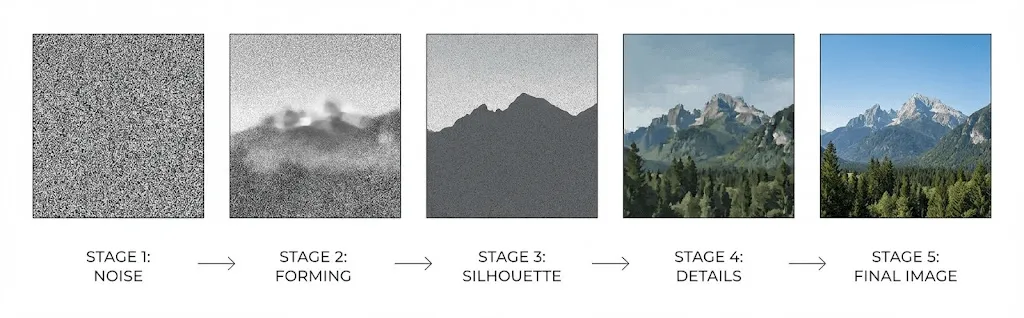

I generatori di immagini IA trasformano i prompt testuali in vettori numerici (text embeddings), avviando un processo che parte dal rumore casuale in uno spazio latente compresso per poi definire l'immagine finale attraverso un modello di diffusione. Questo sistema rimuove progressivamente le imperfezioni sotto la guida costante del testo inserito, decodificando infine i dati in pixel; al contempo, parametri quali il CFG (guida), gli step e i seed permettono di controllare con precisione la fedeltà alle istruzioni e la coerenza dei risultati ottenuti.

Le due sfide fondamentali risolte dai generatori di immagini IA

Ogni generatore di immagini IA opera affrontando due sfide distinte ma strettamente interconnesse: l’interpretazione accurata del prompt e la successiva creazione dell’immagine.

Il primo passo: interpretare il messaggio. Quando si inserisce un prompt come "tramonto sulle montagne con luci drammatiche", il sistema deve tradurre le parole in concetti visivi elaborabili, decodificando il significato estetico di termini come "drammatico" e calcolando l'interazione tra i colori del crepuscolo e le ombre del paesaggio attraverso l'elaborazione del linguaggio naturale.

La seconda sfida risiede nella creazione effettiva dei pixel: il sistema deve infatti elaborare milioni di valori cromatici per generare oggetti coerenti, luci realistiche e prospettive accurate, traducendo fedelmente le tue istruzioni attraverso sofisticati processi di computer vision.

I moderni sistemi risolvono tali criticità attraverso l'impiego di reti neurali, strutture computazionali progettate ispirandosi ai processi biologici di connessione e comunicazione dei neuroni umani.

Le reti neurali: le fondamenta dell'architettura

Prima di approfondire le singole architetture, è fondamentale comprendere i processi attraverso i quali le reti neurali elaborano e interpretano i contenuti visivi.

A differenza della percezione umana, i computer interpretano le immagini come vaste griglie numeriche, dove un file a colori da 512x512 pixel racchiude ben 786.432 valori distinti distribuiti sui tre canali cromatici: in questo contesto, il compito fondamentale della rete neurale consiste nell'individuare ed estrapolare schemi ricorrenti all'interno di tale complessità di dati.

Durante la fase di addestramento, queste reti analizzano milioni di immagini, proprio come avvenuto per Stable Diffusion; questo modello è stato istruito su LAION 5B, un dataset contenente circa 5,85 miliardi di coppie immagine-testo provenienti da fonti pubbliche online. Attraverso lo studio dei testi associati a ogni file — come tag alt, didascalie e contesti descrittivi — l'IA apprende a stabilire correlazioni precise tra il linguaggio naturale e i corrispondenti concetti visivi.

Grazie a questo processo, la rete apprende schemi strutturati su più livelli: dai primi strati, dedicati all'identificazione di bordi e forme semplici, si passa a quelli intermedi, capaci di riconoscere elementi specifici come occhi, ruote o foglie, fino a raggiungere i livelli più profondi, in cui vengono elaborati concetti e stili complessi.

Dalle reti GAN ai modelli di diffusione: l’evoluzione della tecnologia

Negli ultimi anni, il panorama della generazione di immagini tramite IA ha vissuto una trasformazione radicale, un’evoluzione la cui comprensione è fondamentale per spiegare lo straordinario salto qualitativo compiuto dagli strumenti odierni rispetto alle soluzioni disponibili solo tre anni fa.

L'era delle GAN (2014-2021)

Introdotte da Ian Goodfellow nel 2014, le Generative Adversarial Networks (GAN) hanno dominato il settore per anni, basandosi sull'elegante principio di mettere in costante competizione due reti neurali contrapposte.

Il processo si basa sulla costante interazione tra due reti contrapposte: mentre il generatore si impegna a creare immagini artificiali, il discriminatore lavora per identificarle. Questa dinamica innesca una vera e propria sfida tecnologica in cui l'affinamento delle capacità di rilevamento spinge il generatore a evolversi costantemente per risultare credibile, elevando così entrambi i sistemi verso livelli di eccellenza superiore.

Già nel 2019, le reti GAN avevano raggiunto traguardi straordinari, con StyleGAN capace di creare volti fotorealistici di persone inesistenti; tuttavia, tali modelli presentavano limiti strutturali, tra cui un addestramento instabile dovuto al frequente disallineamento tra le reti e una marcata difficoltà nel gestire scene complesse o dettagli minuziosi come le mani.

La rivoluzione dei modelli di diffusione (dal 2020 a oggi)

Esplora come i generatori di immagini IA trasformano i prompt testuali in pixel, sfruttando la potenza dei modelli di diffusione e della matematica avanzata.

Esplora come i generatori di immagini IA trasformano i prompt testuali in pixel, sfruttando la potenza dei modelli di diffusione e della matematica avanzata.

Nel 2020, Jonathan Ho, Ajay Jain e Pieter Abbeel della UC Berkeley hanno pubblicato lo studio "Denoising Diffusion Probabilistic Models" (DDPMs), un'opera fondamentale destinata a rivoluzionare radicalmente l'intero settore.

Il funzionamento dei modelli di diffusione si basa sull'apprendimento dell'inversione del rumore, un processo che permette di trasformare una base di statica casuale in un'immagine definita attraverso una progressiva azione di "denoising". Questo meccanismo viene perfezionato addestrando le reti neurali a invertire il naturale decadimento visivo, partendo da immagini saturate di rumore fino a ricostruire forme e dettagli con assoluta precisione.

Processo di diffusione diretta: partendo da un’immagine di addestramento, viene applicato un incremento progressivo di rumore gaussiano attraverso numerosi passaggi (solitamente 1.000), fino a trasformare il contenuto originale in un segnale statico del tutto irriconoscibile.

Il processo inverso: attraverso l'addestramento di una rete neurale, il sistema impara a prevedere e rimuovere progressivamente il rumore in ogni fase, ricostruendo così un'immagine nitida e coerente a partire da uno stato di totale casualità.

Rispetto alle reti GAN, l'approccio iterativo garantisce una stabilità intrinseca superiore eliminando la necessità di bilanciare dinamiche avversarie; ciò permette di ottenere output più variegati e una risposta estremamente precisa anche ai prompt più complessi.

Con la pubblicazione dello studio "Diffusion Models Beat GANs on Image Synthesis" nel 2021, Dhariwal e Nichol hanno sancito ufficialmente il primato tecnologico dei modelli di diffusione, consacrandoli come il nuovo standard d'eccellenza per la sintesi d'immagine.

Come funziona l’IA per la generazione di immagini: la pipeline completa da testo a immagine

Ecco come avviene la trasformazione dei vostri input in contenuti visivi ogni volta che inserite un prompt in Stable Diffusion, DALL-E o Midjourney:

Fase 1: Codifica del testo tramite CLIP

Il testo viene inizialmente elaborato da un apposito codificatore, solitamente identificato nel modello CLIP (Contrastive Language Image Pre-training) sviluppato da OpenAI.

Grazie all'addestramento su 400 milioni di coppie tra immagini e testi per interpretare le profonde relazioni tra linguaggio e concetti visivi, CLIP trasforma ogni prompt in un vettore ad alta dimensione — solitamente di 768 o 1024 unità — capace di catturarne l'intero significato semantico.

Questo vettore risiede in uno "spazio di embedding" condiviso dove i concetti affini tendono a raggrupparsi: ciò spiega perché termini come "cane" e "cucciolo" generino vettori simili, mentre parole semanticamente distanti come "cane" e "grattacielo" producano risultati profondamente divergenti.

Fase 2: L’elaborazione nello spazio latente

È qui che l'innovazione si fa strada: per ovviare all'ingente carico computazionale richiesto dall'elaborazione diretta di immagini ad alta risoluzione, i sistemi moderni operano all'interno dello "spazio latente", una sofisticata forma di rappresentazione compressa.

Nel paper del 2022 con cui è stato introdotto Stable Diffusion, Rombach et al. hanno dimostrato come il processo di diffusione possa operare all'interno di uno spazio compresso mantenendo standard qualitativi elevati: una svolta decisiva che ha reso questa tecnologia finalmente accessibile al grande pubblico.

Comprimendo un’immagine da 512×512 (786.432 valori) in una rappresentazione latente di soli 64×64 (16.384 valori), Stable Diffusion ottiene una riduzione di 48 volte che ne consente l'utilizzo su GPU consumer, eliminando la necessità di ricorrere a infrastrutture da data center.

Il processo di generazione ha origine all'interno dello spazio latente partendo da un rumore casuale, paragonabile a una tela statica estremamente compressa e sfocata che funge da base creativa.

Fase 3: Processo di denoising iterativo

Il cuore del processo risiede nell’architettura neurale U-Net che, originariamente concepita per la segmentazione di immagini mediche, esegue ora una rimozione progressiva del rumore attraverso un ciclo iterativo solitamente composto da 20-50 passaggi.

In ciascuna fase del processo di generazione, l'architettura U-Net riceve i seguenti input:

- La rappresentazione latente corrente, ancora caratterizzata dal rumore

- L'embedding testuale generato da CLIP, che codifica il prompt inserito

- Un timestamp identificativo della fase specifica del processo

La rete analizza il livello di rumore presente nell'immagine per rimuoverne una quota calcolata, definendo dapprima la composizione e le forme principali e perfezionando, nelle fasi finali, ogni singola texture e dettaglio.

L'embedding testuale orienta l'intero processo avvalendosi di meccanismi di "cross-attention", che consentono alla rete di focalizzarsi sugli aspetti cruciali del prompt per determinare, con estrema precisione, quali elementi integrare o eliminare in ogni punto della composizione.

Fase 4: Decodifica e ricostruzione finale dell'immagine in pixel

Una volta completata la rimozione del rumore, un decodificatore (Variational Autoencoder o VAE) espande la rappresentazione latente alla massima risoluzione, effettuando un upsampling che ricostruisce meticolosamente i dettagli più fini inizialmente sacrificati dalla compressione.

CFG (Guidance Scale): l'impostazione fondamentale per determinare la precisione e l'aderenza dell'immagine al prompt

Chiunque utilizzi Stable Diffusion avrà incontrato i parametri "CFG" o "guidance scale", strumenti essenziali che determinano la fedeltà del modello rispetto al prompt inserito. Sebbene molti utenti mantengano il valore predefinito di 7 seguendo le indicazioni dei tutorial, comprenderne la logica sottostante permette di acquisire un controllo superiore sui risultati finali.

L'acronimo CFG, che sta per "classifier free guidance", identifica una procedura che prevede la doppia esecuzione del modello durante ogni singola fase di rimozione del rumore (denoising):

- Analisi basata sul prompt: il sistema interpreta il testo fornito per determinare l'aspetto specifico che l'immagine dovrà assumere.

- Elaborazione in assenza di prompt: il modello delinea una versione neutra per definire come apparirebbe un'immagine generica in quel contesto.

L'output finale mette in risalto lo scarto tra queste due previsioni, permettendo a valori di CFG più elevati di orientare il risultato in modo più incisivo verso i concetti definiti nel prompt.

Tuttavia, ciò comporta un necessario compromesso:

- CFG basso (1-5): privilegia l'estro creativo e la libertà espressiva, sebbene i risultati possano talvolta discostarsi dalle istruzioni fornite nel prompt.

- CFG medio (7-12): costituisce il punto di equilibrio ideale, garantendo una resa armonica e precisa nella maggior parte delle generazioni.

- CFG alto (15+): assicura una rigorosa aderenza al prompt, con il rischio tuttavia di produrre immagini sovrasature o di generare artefatti visivi.

Confronto tra i principali strumenti: DALL-E, Midjourney e Stable Diffusion

Sebbene i modelli di diffusione costituiscano ormai lo standard per tutti i principali generatori di immagini, le loro modalità di implementazione variano sensibilmente da una tecnologia all'altra.

DALL-E 3 (OpenAI)

L’approccio di OpenAI integra direttamente ChatGPT, permettendo a GPT 4 di rielaborare ed espandere i prompt prima della fase di generazione; grazie a questo processo, DALL-E riesce a interpretare istruzioni semplici in modi sorprendentemente sofisticati. Sebbene tale dinamica favorisca gli utenti meno esperti, i professionisti potrebbero riscontrare un minor controllo sulla fedeltà assoluta al prompt originale; tuttavia, il sistema si distingue per l'eccellente resa dei testi nelle immagini, superando una criticità storica dei generatori IA.

Midjourney

Ottimizzato per prediligere la resa estetica alla fedeltà letterale, il modello di Midjourney genera immagini dallo stile pittorico e cinematografico che, pur non ricalcando sempre pedissequamente il prompt, offrono un impatto visivo spesso superiore a quello dei generatori concorrenti. Sebbene l’interfaccia basata su Discord rappresenti una scelta insolita, tale ecosistema ha permesso di consolidare una solida community, nonostante il brand mantenga una minore trasparenza sui dettagli tecnici rispetto alla propria concorrenza.

Stable Diffusion

Questa soluzione open source, eseguibile localmente per garantire la massima trasparenza e personalizzazione, ha dato vita a un ecosistema vastissimo di modelli ottimizzati, estensioni e LoRA (Low-Rank Adaptations) per l’integrazione di concetti specifici. Pur presentando una curva di apprendimento più impegnativa rispetto ad altre alternative, resta la scelta d'elezione per chi necessita di controllo assoluto, privacy rigorosa o della possibilità di addestrare modelli su misura.

Adobe Firefly

Addestrato esclusivamente su immagini Adobe Stock, contenuti con licenza aperta e opere di pubblico dominio, il sistema garantisce la massima sicurezza per l'uso commerciale eliminando ogni criticità legata al copyright. Oltre a una profonda integrazione con Photoshop e Illustrator, la tecnologia assicura risultati sempre professionali, evitando per scelta la generazione di contenuti controversi o inappropriati tipici di altre soluzioni.

Oltre la semplice generazione di immagini

La generazione da testo a immagine rappresenta solo il punto di partenza, poiché i sistemi più moderni integrano numerose funzionalità evolute che meritano di essere approfondite per sfruttarne appieno il potenziale.

Da immagine a immagine (img2img)

Anziché partire dal rumore puro, il processo ha inizio da un'immagine esistente parzialmente alterata, dove il parametro di "denoising strength" determina il livello di variazione del risultato finale rispetto all'input. Regolando questa intensità, è possibile spaziare da lievi affinamenti stilistici a una completa reinterpretazione creativa dell'immagine, mantenendo della fonte originale soltanto la struttura compositiva di base.

Inpainting e Outpainting

Attraverso l'Inpainting è possibile rigenerare specifiche porzioni mascherate per rimuovere oggetti indesiderati o sostituire elementi preservando l'integrità dell'immagine originale, mentre l'Outpainting ne espande i confini generando contenuti coerenti che danno continuità alla scena esistente.

ControlNet

ControlNet introduce una guida strutturale nel processo di generazione, permettendo di utilizzare mappe di bordi, profondità, pose o maschere di segmentazione per definire con assoluta precisione la disposizione degli elementi. Questa funzionalità risulta fondamentale per garantire la coerenza nel design dei personaggi o quando si necessita di un controllo spaziale rigoroso che i soli prompt testuali non sono in grado di offrire.

LoRA e DreamBooth

Desideri che l'intelligenza artificiale sia in grado di raffigurare persone, prodotti o stili non presenti nel set di dati originale? Grazie a tecniche come LoRA (Low-Rank Adaptation) e DreamBooth, è possibile ottimizzare i modelli partendo da dataset personalizzati di soli 20-30 scatti, ottenendo così una soluzione capace di generare quel preciso concetto su richiesta.

I limiti attuali e le ragioni tecniche sottostanti

I generatori di immagini IA presentano limitazioni note che, se comprese a fondo, permettono di adottare soluzioni mirate per superarle con efficacia.

Il famigerato problema della resa delle mani

È noto come i generatori di immagini IA tendano a rappresentare le mani con un numero errato di dita, giunzioni innaturali o configurazioni anatomicamente impossibili: lungi dall’essere un semplice bug risolvibile, tale limite rappresenta una sfida fondamentale e intrinseca alla tecnologia stessa.

Nei set di dati utilizzati per l'addestramento, le mani compaiono in una vasta gamma di angolazioni, posizioni e gradi di occlusione, finendo per ricevere meno "attenzione" algoritmica a causa delle loro dimensioni ridotte rispetto all'intera immagine. Poiché i pattern statistici necessari per definire una rappresentazione anatomica corretta sono intrinsecamente più complessi da apprendere rispetto a tratti più costanti come i volti, la generazione delle mani rimane una sfida tecnica significativa, nonostante i costanti progressi dei modelli più recenti.

Rendering del testo

Prima dell'avvento di DALL-E 3, generare testo leggibile all'interno delle immagini era una sfida quasi insormontabile, poiché i modelli comprendono il significato semantico delle parole ma faticano a interpretarne la resa grafica. Sebbene DALL-E 3 abbia compiuto progressi straordinari in questo ambito, la creazione di layout testuali complessi rimane tuttora un elemento di incertezza comune a tutte le piattaforme.

Coerenza visiva tra le immagini

Poiché ogni processo di generazione ha origine da un rumore casuale differente, mantenere la coerenza visiva di personaggi o ambientazioni risulta spesso complesso; nonostante l'impiego di tecniche quali il blocco del seed, le immagini di riferimento o i modelli LoRA, queste soluzioni non sono ancora del tutto risolutive, limitando ambiti creativi come la produzione di fumetti o lo sviluppo dell'identità visiva di un brand.

Ragionamento spaziale

Istruzioni come "la palla rossa è a sinistra del cubo blu, posizionato dietro la piramide verde" generano spesso disposizioni errate, evidenziando come i modelli, pur identificando i singoli oggetti, fatichino ancora a elaborare le complesse relazioni spaziali tra più elementi contemporaneamente.

La questione del diritto d'autore

In questo ambito, tuttavia, si delineano le sfide più complesse sotto il profilo legale ed etico.

Dati di addestramento

Gran parte dei modelli di generazione d'immagini IA si basa sull'addestramento tramite miliardi di contenuti prelevati dal web, spesso in assenza di un consenso esplicito da parte degli autori originali; questa pratica ha dato origine a numerose controversie legali volte a determinare eventuali violazioni del copyright, rendendo l'attuale panorama normativo ancora estremamente incerto e in divenire.

Proprietà dei contenuti generati

Negli Stati Uniti, il Copyright Office ha stabilito che le immagini generate esclusivamente dall'intelligenza artificiale non possono beneficiare della tutela del diritto d'autore, la quale richiede necessariamente la paternità umana; tuttavia, restano ammesse alla protezione quelle opere che dimostrino un "sufficiente apporto creativo umano", sebbene la definizione precisa di tale confine rimanga ancora incerta e oggetto di attuali procedimenti legali.

È inoltre fondamentale consultare i termini di servizio della piattaforma: sebbene la maggior parte dei servizi commerciali riconosca all'utente i diritti sulle immagini generate, si consiglia di esaminare attentamente le clausole specifiche per il proprio caso d'uso.

Consigli pratici per ottimizzare i risultati

Comprendere a fondo la tecnologia sottostante permette di perfezionare la stesura dei prompt, ottimizzando i risultati attraverso l'applicazione di queste strategie collaudate:

I concetti fondamentali della generazione IA

L'encoder testuale attribuisce un peso differente ai termini in base alla loro posizione, motivo per cui è fondamentale inserire gli elementi più rilevanti all'inizio del prompt: una sequenza come "Tramonto, luci drammatiche, paesaggio montano" genererà infatti un'enfasi diversa rispetto a "Un paesaggio con montagne al tramonto".

Utilizza riferimenti noti al modello

Grazie all'apprendimento basato sui dati di addestramento, i modelli attivano pattern visivi specifici con estrema affidabilità quando si utilizzano riferimenti concreti ad artisti, stili o parametri tecnici come il tipo di pellicola ("Kodak Portra 400"). Tale precisione supera l'efficacia di descrizioni astratte, poiché indicare una "luce di Rembrandt" garantisce un risultato molto più accurato rispetto a un generico riferimento a un'illuminazione laterale drammatica.

Privilegia l’iterazione costante rispetto alla perfezione immediata

Poiché ottenere il risultato perfetto al primo tentativo è raro, è fondamentale generare diverse varianti per individuare gli elementi più efficaci e affinare il prompt, sfruttando poi la funzione img2img sulle creazioni migliori per evolvere dettagli specifici senza alterare la composizione originale.

Sfrutta i prompt negativi

I prompt negativi permettono di specificare gli elementi da evitare, quali sfocature, distorsioni o filigrane, riducendo l'influenza di tali concetti durante il processo di denoising; disporre di una libreria dedicata di prompt negativi è quindi essenziale per prevenire sistematicamente gli errori più comuni della generazione IA.

Le prossime frontiere dell’innovazione

In un settore in così rapida evoluzione, sono numerosi i progressi che meritano un'attenzione particolare:

- Generazione video: attraverso modelli come Sora e Runway Gen 3, la tecnologia di diffusione si espande al comparto video, trasformando i prompt testuali in filmati ad alta risoluzione con un realismo sempre più tangibile.

- Creazione di contenuti 3D: la rapida evoluzione degli strumenti per la generazione 3D, sia da testo che da immagine, sta aprendo nuove frontiere nel gaming, nella visualizzazione di prodotti e nella realtà virtuale.

- Generazione in tempo reale: grazie a costanti ottimizzazioni, le prestazioni si spingono verso velocità interattive, con sistemi già capaci di elaborare immagini finite in meno di un secondo.

- Coerenza avanzata: le nuove architetture puntano a risolvere il problema della continuità tra personaggi e ambientazioni, sbloccando applicazioni cruciali per settori come il fumetto e l'animazione professionale.

Domande frequenti

Quanto tempo richiede la generazione delle immagini?

Se i servizi in cloud richiedono mediamente dai 10 ai 30 secondi per l'elaborazione, l'esecuzione locale di Stable Diffusion su GPU di ultima generazione (RTX 3060 o superiori) consente di generare immagini 512×512 in soli 2-5 secondi, con tempi che variano proporzionalmente in base alla risoluzione e al numero di passaggi impostati.

I generatori di immagini IA si limitano a copiare opere già esistenti?

In realtà, questi sistemi non archiviano copie fisiche ma apprendono complessi schemi statistici; tuttavia, la parziale "memorizzazione" di opere iconiche e la capacità di replicare fedelmente lo stile di specifici artisti alimentano oggi accesi dibattiti in materia di diritto d'autore.

Perché la rappresentazione delle mani risulta ancora così complessa?

All'interno dei dataset di addestramento, le mani presentano un'estrema variabilità in termini di angolazione, posizionamento e visibilità, risultando spesso marginali nelle immagini a figura intera e ricevendo di conseguenza una minore enfasi algoritmica. Questa complessità rende l'apprendimento dei pattern statistici sensibilmente più difficile rispetto a tratti più uniformi: sebbene la tecnologia sia in costante evoluzione, la loro perfetta resa rimane una sfida tecnica ancora aperta.

È possibile utilizzare le immagini generate dall'IA per scopi commerciali?

Sebbene la possibilità di utilizzo commerciale dipenda dalla piattaforma e dalla giurisdizione di riferimento, la maggior parte dei servizi professionali include tali diritti nelle proprie condizioni d'uso; tuttavia, poiché i risultati generati esclusivamente dall'IA potrebbero non essere soggetti a copyright in alcuni mercati come quello statunitense, Adobe Firefly è stato progettato specificamente per scopi commerciali, garantendo la massima affidabilità attraverso un addestramento basato unicamente su contenuti dotati di licenza.

Quali sono le principali differenze tra i modelli di diffusione e le reti GAN?

A differenza delle reti GAN, basate sulla competizione tra un generatore e un discriminatore, i modelli di diffusione operano apprendendo l'inversione di un processo graduale di aggiunta di rumore. Questa tecnologia si è affermata come standard dominante grazie a un addestramento più stabile e alla capacità di produrre risultati estremamente diversificati, garantendo al contempo una maggiore aderenza ai prompt testuali.

In sintesi

I generatori di immagini IA non agiscono per magia, ma operano attraverso sofisticati modelli di diffusione che trasformano le descrizioni testuali in pixel tramite un processo di denoising guidato e progressivo. Integrando la comprensione del linguaggio con pattern visivi complessi, questi sistemi utilizzano un raffinamento iterativo per dare vita a rappresentazioni visive fedeli alle istruzioni fornite.

Ogni prompt inserito viene elaborato da encoder testuali istruiti su centinaia di milioni di associazioni tra immagini e parole per guidare un processo di rimozione del rumore in uno spazio latente compresso, culminando infine nella decodifica dell'immagine ad alta risoluzione. Comprendere le dinamiche di questo flusso di lavoro, anche nelle sue linee essenziali, è fondamentale per padroneggiare lo strumento con maggiore consapevolezza e agire con estrema efficacia.

Non si tratta semplicemente di inserire desideri in un campo di testo, ma di fornire segnali di condizionamento a un processo matematico che, interpretando il linguaggio naturale, guida la rimozione del rumore attraverso pattern appresi per ricostruire l'immagine sin dalle sue fondamenta.

Questa consapevolezza non risponde solo a una semplice curiosità, ma rappresenta una competenza fondamentale per perfezionare la stesura dei prompt, definire aspettative concrete e selezionare gli strumenti più idonei ai propri obiettivi. In un settore in rapida e costante evoluzione, disporre di basi solide è il presupposto essenziale per adattarsi con agilità a ogni nuova innovazione tecnologica.