Wie KI-Bildgeneratoren funktionieren: Der Weg vom Prompt zum fertigen Bild – Schritt für Schritt erklärt

Zuletzt aktualisiert: 2026-01-22 18:08:25

Erfahren Sie, wie moderne KI-Bildgeneratoren mithilfe von Diffusionsmodellen und komplexer Mathematik Ihre Text-Prompts in präzise Pixel verwandeln.

Erfahren Sie, wie moderne KI-Bildgeneratoren mithilfe von Diffusionsmodellen und komplexer Mathematik Ihre Text-Prompts in präzise Pixel verwandeln.

Was geschieht nach der Prompteingabe? Eine ebenso verständliche wie präzise Erläuterung des Prozesses

Dieses Szenario ist mittlerweile vielen vertraut: Man gibt eine Beschreibung wie „eine Katze mit Zauberhut im Stil eines Ölgemäldes“ bei Midjourney oder DALL-E ein, und bereits nach wenigen Sekunden erscheint ein völlig neues Kunstwerk, dessen Entstehung fast wie Magie wirkt.

Dahinter steckt keine Magie, sondern komplexe Mathematik – und dieses Verständnis ist weit mehr als nur von akademischem Interesse, da es Ihnen hilft, diese Werkzeuge weitaus effektiver zu nutzen. Sobald Sie die Logik hinter erfolgreichen Prompts durchschauen, weicht bloßes Raten einer gezielten und kreativen Gestaltung.

Im Folgenden erläutern wir die zugrunde liegende Funktionsweise auf eine Weise, die zwar auf rein akademische Komplexität verzichtet, Ihnen jedoch gleichzeitig den nötigen Tiefgang bietet, um die technologischen Prozesse hinter der Oberfläche grundlegend zu verstehen.

Kurz zusammengefasst (30 Sekunden):

KI-Bildgeneratoren transformieren Ihre Prompts zunächst in numerische Text-Embeddings und erzeugen basierend darauf ein zufälliges Bildrauschen innerhalb eines komprimierten „latenten Raums“. Während ein Diffusionsmodell dieses Rauschen schrittweise entfernt, dient Ihre Eingabe als präziser Leitfaden, bis das finale Ergebnis schließlich wieder in Pixel dekodiert wird. Über Parameter wie die Guidance Scale (CFG), Iterationsschritte und Seeds behalten Sie dabei die volle Kontrolle über die Prompt-Treue sowie die Konsistenz der generierten Bilder.

Zwei zentrale Herausforderungen, die KI-Bildgeneratoren souverän meistern

Jeder KI-Bildgenerator bewältigt im Kern zwei eng miteinander verknüpfte Aufgaben: die präzise Interpretation Ihres Prompts sowie die anschließende visuelle Erzeugung des Bildes.

Herausforderung eins: Die präzise Erfassung Ihrer Intention. Sobald Sie eine Beschreibung wie „Sonnenuntergang über Bergen mit dramatischer Beleuchtung“ eingeben, übersetzt das System diese Begriffe mittels natürlicher Sprachverarbeitung (NLP) in verarbeitbare Konzepte. Dabei wird analysiert, wie sich visuelle Attribute wie „dramatisch“ definieren und auf welche Weise die Farben des Abendrots mit den Schattenwürfen der Gebirgskette interagieren sollen.

Die zweite Herausforderung: Die eigentliche Pixel-Erzeugung. Hierbei muss das System Millionen von Farbwerten so präzise berechnen, dass unter strikter Einhaltung Ihrer Vorgaben kohärente Objekte, realistische Lichteffekte und korrekte Perspektiven entstehen – das Herzstück der Computer Vision.

Moderne Systeme bewältigen diese Herausforderungen mithilfe neuronaler Netze, also Rechenstrukturen, die in ihrer Funktionsweise der Vernetzung und Kommunikation menschlicher Neuronen nachempfunden sind.

Neuronale Netze: Das technologische Fundament

Bevor wir uns den spezifischen Architekturen widmen, ist es hilfreich, zunächst die grundlegende Funktionsweise und die Verarbeitung von Bilddaten durch neuronale Netze zu verstehen.

Im Gegensatz zum menschlichen Auge erfassen Computer Bilder als gewaltige Zahlenraster: So besteht bereits ein Farbbild im Format 512×512 aus 786.432 Einzelwerten, in denen das neuronale Netz durch die Analyse von Pixeln und Farbkanälen komplexe Muster identifiziert.

Während des Trainings verarbeiten diese Netzwerke Millionen von Bildern, wobei Stable Diffusion beispielsweise auf dem LAION 5B-Datensatz basiert, der rund 5,85 Milliarden öffentlich zugängliche Bild-Text-Paare umfasst. Durch die Analyse der Bilder sowie ihrer zugehörigen Beschreibungen und Alt-Tags erlernt das Modell dabei die tiefgreifenden Assoziationen zwischen Sprache und visuellen Konzepten.

In diesem Prozess erlernt das Netzwerk Muster auf verschiedenen Abstraktionsebenen: Während die ersten Schichten zunächst Kanten und Grundformen erfassen, identifizieren mittlere Ebenen bereits komplexe Bestandteile wie Augen, Räder oder Blätter, bis die tieferen Schichten schließlich ein umfassendes Verständnis für ganze Konzepte und Stile entwickeln.

Von GANs zu Diffusionsmodellen: Die technologische Evolution der Bildgenerierung

Die KI-Bildgenerierung hat sich in den letzten Jahren so rasant weiterentwickelt, dass erst ein Blick auf diese Evolution erklärt, weshalb heutige Tools im Vergleich zu Lösungen von vor nur drei Jahren eine weitaus höhere Qualität bieten.

Die Ära der GANs (2014–2021)

Über Jahre hinweg dominierten die 2014 von Ian Goodfellow eingeführten Generative Adversarial Networks (GANs) das Feld, wobei ihr ebenso elegantes wie effizientes Grundprinzip auf dem direkten technologischen Wettstreit zweier neuronaler Netze basiert.

Während das Generator-Netzwerk darauf abzielt, täuschend echte Bilder zu erzeugen, übernimmt der Diskriminator die Aufgabe, diese als Fälschungen zu entlarven. Dieses technologische Wettrüsten führt dazu, dass sich beide Netzwerke kontinuierlich gegenseitig zu Höchstleistungen anspornen und so die Qualität der generierten Ergebnisse stetig perfektionieren.

Obwohl GANs bereits 2019 beeindruckende Ergebnisse lieferten und StyleGAN etwa fotorealistische Porträts nicht existierender Personen erschuf, wiesen diese Modelle noch deutliche Schwächen auf. Neben instabilen Trainingsprozessen, bei denen die beteiligten Netzwerke häufig die Synchronität verloren, stießen sie insbesondere bei der Darstellung komplexer Szenen mit mehreren Objekten oder filigranen Details wie Händen an ihre Grenzen.

Die Revolution der Diffusionsmodelle (seit 2020)

Die im Jahr 2020 von Jonathan Ho, Ajay Jain und Pieter Abbeel an der UC Berkeley veröffentlichte Forschungsarbeit „Denoising Diffusion Probabilistic Models“ (DDPMs) markierte einen entscheidenden Wendepunkt, der die technologische Entwicklung nachhaltig revolutionierte.

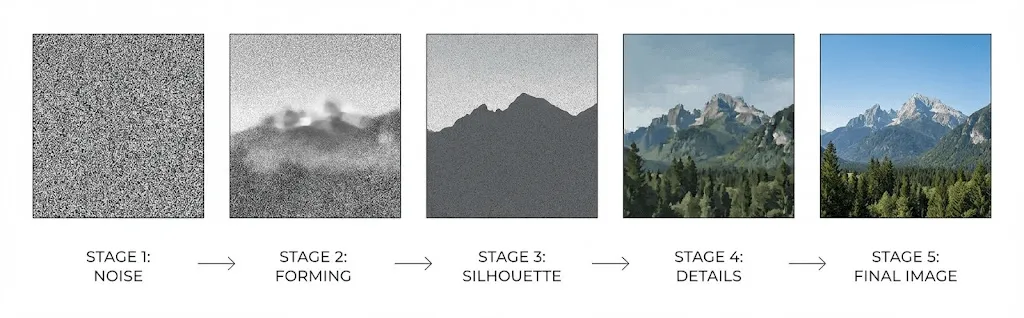

Diffusionsmodelle basieren auf dem Prinzip der Rauschumkehr, bei dem ein neuronales Netz darauf trainiert wird, zufälliges statisches Rauschen schrittweise zu „entrauschen“ und so in ein detailliertes Bild zu transformieren. Dabei lernt das Modell, den Prozess der Bilddegradierung umzukehren: Ein klares Ausgangsbild wird zunächst bis zur völligen Unkenntlichkeit verrauscht, um anschließend die präzise Wiederherstellung der ursprünglichen Strukturen zu perfektionieren.

Der Forward-Prozess: Hierbei wird ein Trainingsbild über meist 1.000 Einzelschritte hinweg sukzessive mit Gaußschem Rauschen versetzt, bis das ursprüngliche Motiv schließlich vollständig in einer unkenntlichen statischen Fläche aufgeht.

Der Umkehrprozess: Durch das gezielte Training eines Netzwerks zur Vorhersage und schrittweisen Eliminierung von Bildrauschen wird aus reinem Zufall sukzessive ein kohärentes Bild rekonstruiert.

Im Vergleich zu herkömmlichen GANs bietet dieser schrittweise Ansatz eine deutlich höhere Stabilität, da auf das Ausbalancieren komplexer antagonistischer Dynamiken verzichtet werden kann. Dies führt nicht nur zu einer größeren Vielfalt in der Bildausgabe, sondern ermöglicht zudem eine präzisere und zuverlässigere Umsetzung selbst hochkomplexer Prompts.

Seit Dhariwal und Nichol im Jahr 2021 ihre wegweisende Studie „Diffusion Models Beat GANs on Image Synthesis“ veröffentlichten, steht fest: In der Bildsynthese haben Diffusionsmodelle die Nachfolge von GANs endgültig angetreten.

Funktionsweise der Text-zu-Bild-KI: Der Generierungsprozess im Detail

Erfahren Sie, was im Detail geschieht, sobald Sie einen Prompt in Stable Diffusion, DALL-E oder Midjourney eingeben:

Schritt 1: Textkodierung mit CLIP

Zu Beginn des Prozesses durchläuft Ihre Texteingabe einen Text-Encoder – in der Regel das von OpenAI entwickelte CLIP-Modell (Contrastive Language-Image Pre-training).

Durch das Training mit 400 Millionen Bild-Text-Paaren versteht CLIP die komplexen Zusammenhänge zwischen Sprache und visuellen Konzepten und transformiert Ihren Prompt in einen hochdimensionalen Vektor – üblicherweise mit 768 oder 1024 Dimensionen –, der die semantische Bedeutung präzise erfasst.

Dieser Vektor wird in einem gemeinsamen „Embedding-Raum“ verortet, in dem semantisch verwandte Konzepte wie „Hund“ und „Welpe“ nah beieinander liegen, während völlig unterschiedliche Begriffe wie „Hund“ und „Wolkenkratzer“ entsprechend gegensätzliche Vektoren erzeugen.

Schritt 2: Die Verarbeitung im latenten Raum

An dieser Stelle zeigt sich die technologische Raffinesse: Da die direkte Bearbeitung hochauflösender Bilder enorme Rechenressourcen beanspruchen würde, operieren moderne Systeme stattdessen im sogenannten „latenten Raum“, einer effizient komprimierten Darstellung.

In ihrer Publikation zur Einführung von Stable Diffusion im Jahr 2022 belegten Rombach et al., dass Diffusionsprozesse bei gleichbleibender Qualität in einem komprimierten Raum stattfinden können – ein Meilenstein, der diese Technologie erst massentauglich und für Endanwender zugänglich machte.

Stable Diffusion komprimiert Bilder von 512×512 Pixeln (786.432 Werte) auf eine latente Repräsentation von lediglich 64×64 Pixeln (16.384 Werte), was einer 48-fachen Reduktion entspricht. Dank dieser hohen Effizienz lässt sich das Modell problemlos auf herkömmlichen Grafikkarten ausführen, ohne dass die Ressourcen eines Rechenzentrums erforderlich sind.

Der Generierungsprozess nimmt seinen Anfang mit einem zufälligen Bildrauschen innerhalb dieses latenten Raums, vergleichbar mit einer stark komprimierten, unscharfen Leinwand voller statischer Signale.

Schritt 3: Iterative Rauschminderung

Im Mittelpunkt des Prozesses steht das U-Net: Diese ursprünglich für die medizinische Bildsegmentierung entwickelte, u-förmige Netzwerkarchitektur entfernt das Bildrauschen in einem mehrstufigen Verfahren, das üblicherweise 20 bis 50 Iterationen umfasst.

In jedem Iterationsschritt erhält das U-Net folgende Informationen:

- Die latente Repräsentation im aktuellen, verrauschten Stadium

- Das via CLIP erzeugte Text-Embedding auf Basis Ihres kodierten Prompts

- Ein Zeitstempel zur präzisen Bestimmung des jeweiligen Prozessschritts

Das Netzwerk analysiert das bestehende Bildrauschen und reduziert dieses schrittweise, wodurch in der Anfangsphase zunächst die Komposition sowie grundlegende Formen definiert werden, während spätere Prozessschritte für die Verfeinerung von Texturen und Details sorgen.

Dabei steuert das Text-Embedding den Prozess über sogenannte „Cross-Attention“-Mechanismen, dank derer das Netzwerk gezielt die relevanten Abschnitte Ihres Prompts berücksichtigt, um an jeder Stelle präzise über das Hinzufügen oder Entfernen von Bilddetails zu entscheiden.

Schritt 4: Die Rückumwandlung in das Pixelformat

Sobald der Entrauschungsprozess abgeschlossen ist, skaliert ein Decoder (Variational Autoencoder oder VAE) die komprimierte latente Darstellung zurück auf die volle Auflösung, wobei dieses Upsampling jene feinen Details präzise wiederherstellt, die im ursprünglichen Prozessschritt komprimiert wurden.

CFG (Guidance Scale): Die zentrale Stellschraube für maximale Prompt-Präzision

Wer bereits mit Stable Diffusion gearbeitet hat, ist sicher schon auf die Begriffe „CFG“ oder „Guidance Scale“ gestoßen, die maßgeblich bestimmen, wie präzise das Modell Ihre Prompts umsetzt. Während viele Anwender lediglich den standardmäßig empfohlenen Wert von 7 nutzen, ermöglicht erst das tiefere Verständnis dieser Funktion eine gezielte Feinabstimmung Ihrer generierten Ergebnisse.

CFG steht für „Classifier Free Guidance“ – ein Verfahren, bei dem das Modell während jedes Entrauschungsschritts zwei separate Durchläufe vollzieht:

- Eine Analyse auf Basis Ihres Prompts bestimmt zunächst, wie das Bild unter Berücksichtigung Ihrer spezifischen Textvorgaben gestaltet werden soll.

- Demgegenüber wird ermittelt, wie eine generische Darstellung an dieser Stelle ohne jegliche Prompt-Vorgabe aussehen würde.

Das Endergebnis betont die Differenz zwischen diesen beiden Vorhersagen, wobei höhere CFG-Werte für eine noch präzisere Ausrichtung des Bildes an den im Prompt definierten Konzepten sorgen.

Dies geht jedoch mit einem entscheidenden Kompromiss einher:

- Niedriger CFG (1–5): Erhöht die kreative Freiheit der KI, birgt jedoch die Gefahr, dass Ihre Anweisungen weniger präzise umgesetzt werden.

- Mittlerer CFG (7–12): Gilt als idealer Standardwert für eine optimale Balance zwischen Kreativität und Prompt-Treue.

- Hoher CFG (15+): Setzt Ihre Vorgaben strikt um, kann jedoch zu übermäßiger Sättigung und störenden Bildartefakten führen.

Die führenden Tools im direkten Vergleich: DALL-E vs. Midjourney vs. Stable Diffusion

Obwohl mittlerweile alle marktführenden KI-Bildgeneratoren auf Diffusionsmodellen basieren, weisen sie in ihrer konkreten technischen Umsetzung signifikante Unterschiede auf.

DALL-E 3 (OpenAI)

Der Ansatz von OpenAI basiert auf einer direkten Integration von ChatGPT, bei der GPT-4 die eingegebenen Prompts vor der Generierung eigenständig verfeinert und erweitert, sodass DALL-E selbst einfache Anweisungen überraschend komplex interpretiert. Während dies ideal für Gelegenheitsnutzer ist, bietet es erfahrenen Anwendern weniger Kontrolle über die exakte Prompt-Treue – glänzt dafür jedoch mit einer präzisen Darstellung von Textelementen, die für KI-Generatoren lange Zeit eine technologische Hürde darstellte.

Midjourney

Das Modell von Midjourney ist primär auf ästhetische Qualität statt auf strikte Detailtreue optimiert, wodurch Bilder mit einer malerischen oder cineastischen Note entstehen, die oft als visuell ansprechender als bei anderen Generatoren empfunden werden. Trotz der ungewöhnlichen, Discord-basierten Benutzeroberfläche hat sich eine loyale Community gebildet, wenngleich das Unternehmen im Vergleich zu Wettbewerbern weniger transparent mit technischen Spezifikationen umgeht.

Stable Diffusion

Als leistungsstarke Open-Source-Lösung lässt sich diese Option lokal betreiben und bietet volle Transparenz sowie uneingeschränkte Modifikationsmöglichkeiten. Auf dieser Basis ist ein umfassendes Ökosystem aus feinjustierten Modellen, LoRAs zur Einbindung spezifischer Konzepte und vielseitigen Erweiterungen entstanden. Damit ist sie die ideale Wahl für Anwender, die Wert auf maximale Kontrolle, Datenschutz und das Training eigener Modelle legen – auch wenn sie im Vergleich eine etwas steilere Lernkurve aufweist.

Adobe Firefly

Dank des exklusiven Trainings mit Adobe Stock-Bildern, offen lizenzierten Inhalten und gemeinfreien Werken bietet das Tool maximale Rechtssicherheit für die kommerzielle Nutzung. Neben der nahtlosen Integration in Photoshop und Illustrator zeichnet es sich durch eine bewusste Inhaltskontrolle aus, die im Gegensatz zu anderen Modellen die Erstellung kontroverser oder unangemessener Ergebnisse systematisch ausschließt.

Über die reine Bildgenerierung hinaus

Die Umwandlung von Text zu Bild markiert dabei lediglich den Ausgangspunkt, da moderne Systeme über zahlreiche weiterführende Funktionen verfügen, die für ein umfassendes Verständnis der Technologie entscheidend sind.

Bild-zu-Bild (img2img)

Anders als bei der Erzeugung aus purem Rauschen bildet hier ein bereits existierendes, teilverrauschtes Bild die Grundlage, wobei der Parameter „Denoising Strength“ maßgeblich den Grad der Abweichung vom Original bestimmt. Während niedrige Werte lediglich für subtile stilistische Anpassungen sorgen, ermöglichen hohe Werte eine vollständige Neugestaltung, die sich lediglich an der grundlegenden Bildkomposition orientiert.

Inpainting und Outpainting

Durch Inpainting lassen sich maskierte Bildbereiche gezielt regenerieren, während der restliche Inhalt unberührt bleibt – eine ideale Lösung, um störende Objekte zu entfernen oder Elemente präzise zu ersetzen. Ergänzend dazu ermöglicht Outpainting die Erweiterung von Bildern über deren ursprüngliche Grenzen hinaus, wobei neue, stimmige Inhalte generiert werden, die das bestehende Motiv nahtlos fortführen.

ControlNet

Mit ControlNet erhält der Generierungsprozess eine präzise strukturelle Führung, die durch Edge-Maps, Tiefenkarten, Pose-Skelette oder Segmentierungsmasken eine exakte Positionierung aller Bildelemente ermöglicht. Dies ist entscheidend für ein konsistentes Charakterdesign sowie für Projekte, die eine räumliche Präzision erfordern, welche über rein textbasierte Prompts allein nicht zu erreichen wäre.

LoRA und DreamBooth

Um spezifische Personen, Produkte oder Stilrichtungen abzubilden, die nicht Teil der ursprünglichen Trainingsdaten sind, ermöglichen Technologien wie LoRA (Low Rank Adaptation) und DreamBooth das gezielte Fine-Tuning auf Basis kleinster Datensätze von oft nur 20 bis 30 Bildern, woraus ein spezialisiertes Modell entsteht, das individuelle Konzepte jederzeit präzise auf Abruf generiert.

Aktuelle Limitationen und ihre technologischen Hintergründe

KI-Bildgeneratoren weisen systemtypische Limitierungen auf, deren Verständnis es Ihnen ermöglicht, diese gezielt zu umgehen und Ihre Ergebnisse zu optimieren.

Die berüchtigte Problematik bei der Darstellung von Händen

KI-Bildgeneratoren sind bekannt dafür, Hände mit fehlerhafter Fingeranzahl, verschmolzenen Gliedern oder anatomisch unmöglichen Strukturen zu erzeugen – ein Phänomen, das keineswegs einen einfachen Softwarefehler darstellt, sondern eine fundamentale technologische Herausforderung ist.

In den Trainingsdaten werden Hände in unterschiedlichsten Winkeln, Positionen und Überschneidungen dargestellt, wobei sie aufgrund ihrer geringen Größe im Verhältnis zum Gesamtbild oft weniger Beachtung finden. Da die statistischen Muster für anatomisch korrekte Hände zudem deutlich komplexer zu erfassen sind als bei beständigeren Merkmalen wie Gesichtern, bleibt die fehlerfreie Darstellung trotz technologischer Fortschritte aktueller Modelle eine Herausforderung.

Präzise Textdarstellung

Bis zur Einführung von DALL-E 3 war die Erzeugung lesbarer Texte in Bildern nahezu unmöglich, da KI-Modelle Wörter zwar semantisch verstehen, jedoch oft an der präzisen typografischen Darstellung scheitern. Obwohl DALL-E 3 hier bedeutende Fortschritte erzielt hat, bleiben komplexe Textlayouts plattformübergreifend weiterhin eine technische Herausforderung.

Bildübergreifende Konsistenz

Da jede Bildgenerierung auf unterschiedlichem Zufallsrauschen basiert, bleibt die konsistente Darstellung identischer Charaktere oder Szenen eine Herausforderung. Bestehende Ansätze wie Seed-Locking, Referenzbilder oder Charakter-LoRAs bieten zwar Hilfestellung, stellen jedoch keine umfassende Lösung dar, was komplexe Anwendungsbereiche wie die Comic-Erstellung oder die Entwicklung konsistenter Markencharaktere erschwert.

Räumliches Verständnis

Während KI-Modelle einzelne Objekte zwar problemlos identifizieren, führen komplexe räumliche Beschreibungen – etwa ein roter Ball links von einem blauen Würfel hinter einer grünen Pyramide – oft zu fehlerhaften Darstellungen, da die präzise Anordnung mehrerer Elemente zueinander eine technologische Herausforderung bleibt.

Die Frage des Urheberrechts

An dieser Stelle rücken jedoch komplexe rechtliche sowie ethische Fragestellungen in den Vordergrund.

Trainingsdaten

Die meisten KI-Bildmodelle basieren auf Milliarden im Internet gesammelter Bilder, deren Erfassung oft ohne die explizite Zustimmung der Urheber erfolgte. Da derzeit zahlreiche Klagen prüfen, inwiefern dieses Vorgehen eine Urheberrechtsverletzung darstellt, gilt die allgemeine Rechtslage weiterhin als ungeklärt.

Eigentumsrechte an den Inhalten

In den USA hat das Copyright Office festgelegt, dass rein KI-generierte Bilder keinen Urheberrechtsschutz genießen können, da hierfür grundsätzlich eine menschliche Urheberschaft erforderlich ist. Ein Schutzanspruch kann lediglich bei Werken mit „ausreichendem menschlichem kreativem Eigenanteil“ bestehen – wo genau diese Grenze verläuft, ist jedoch unklar und wird derzeit aktiv gerichtlich geklärt.

Zudem spielen die plattformspezifischen Nutzungsbedingungen eine wesentliche Rolle, denn obwohl kommerzielle Anbieter ihren Nutzern meist Rechte an den generierten Bildern gewähren, sollte das Kleingedruckte für den individuellen Einsatzbereich stets sorgfältig geprüft werden.

Praxistipps für optimale Ergebnisse

Ein fundiertes Verständnis der zugrunde liegenden Technologie ist der Schlüssel zu präziserem Prompting – erfahren Sie hier, welche Strategien in der Praxis tatsächlich zum Erfolg führen:

Die wichtigsten Konzepte im Überblick

Da der Text-Encoder Begriffe basierend auf ihrer Position gewichtet, erzielen prägnante Aufzählungen wie „Sonnenuntergang, dramatische Beleuchtung, Berglandschaft“ eine deutlich andere Wirkung als rein beschreibende Sätze; platzieren Sie die wichtigsten Elemente daher stets an den Anfang Ihres Prompts.

Nutzen Sie Referenzen, die dem Modell bereits vertraut sind

Da KI-Modelle auf Basis ihrer Trainingsdaten lernen, lassen sich visuelle Muster durch den gezielten Bezug auf namhafte Künstler, Kunststile oder spezifisches Filmequipment – wie etwa „auf Kodak Portra 400“ – weitaus zuverlässiger abrufen als durch rein abstrakte Beschreibungen. So erzielen präzise Fachbegriffe wie „Rembrandt-Beleuchtung“ deutlich konsistentere Ergebnisse als vage Formulierungen wie „dramatisches Seitenlicht“.

Iteration statt sofortiger Perfektion

Da die perfekte Generierung selten im ersten Anlauf gelingt, empfiehlt es sich, verschiedene Varianten zu erstellen, die Ergebnisse zu analysieren und den Prompt sukzessive zu verfeinern. Nutzen Sie anschließend die Bild-zu-Bild-Funktion (img2img), um gezielt einzelne Aspekte Ihrer besten Entwürfe zu optimieren, während die ursprüngliche Bildkomposition gewahrt bleibt.

Negative Prompts gezielt einsetzen

Negative Prompts dienen dazu, unerwünschte Merkmale wie Unschärfe, Verzerrungen oder Wasserzeichen gezielt auszuschließen, indem sie deren Einfluss während des Denoising-Prozesses minimieren. Durch den systematischen Aufbau einer entsprechenden Prompt-Bibliothek lassen sich gängige Darstellungsfehler effektiv vermeiden und die Bildqualität nachhaltig steigern.

Ein Blick in die Zukunft

Angesichts der rasanten Fortschritte in diesem Bereich verdienen insbesondere die folgenden Entwicklungen Ihre Aufmerksamkeit:

- Videogenerierung: Tools wie Sora und Runway Gen 3 dehnen Diffusionsmodelle auf den Videobereich aus und lassen qualitativ hochwertige Text-zu-Video-Ergebnisse zur Realität werden.

- 3D-Generierung: Die rasant reifenden Text-zu-3D- und Bild-zu-3D-Werkzeuge eröffnen wegweisende Möglichkeiten für das Gaming, die Produktvisualisierung sowie für VR-Umgebungen.

- Echtzeit-Generierung: Dank fortschrittlicher Optimierungen nähert sich die Technologie interaktiven Geschwindigkeiten, sodass Bilder in ersten Anwendungen bereits in unter einer Sekunde entstehen.

- Höhere Konsistenz: Innovative Architekturen lösen das Problem der Charakter- und Szenenkonsistenz, was den Weg für komplexe Formate wie Comics und professionelle Animationen ebnet.

Häufig gestellte Fragen

Wie lange dauert die Bildgenerierung?

Während Cloud-Dienste Bilder üblicherweise innerhalb von 10 bis 30 Sekunden generieren, ermöglicht die lokale Ausführung von Stable Diffusion auf einer modernen GPU (ab RTX 3060) die Erstellung von 512×512-Grafiken in nur 2 bis 5 Sekunden, wobei die Rechenzeit bei höheren Auflösungen oder einer größeren Anzahl an Schritten proportional ansteigt.

Kopieren KI-Bildgeneratoren bereits existierende Bilder?

Tatsächlich speichern diese Modelle keine direkten Kopien, sondern erlernen vielmehr komplexe statistische Muster. Da ikonische Werke jedoch bis zu einem gewissen Grad „verinnerlicht“ werden können, führt die gezielte Abfrage spezifischer Künstlerstile zu Ergebnissen, die den Originalen stark ähneln und somit die hitzige Urheberrechtsdebatte maßgeblich befeuert.

Warum gestaltet sich die Darstellung von Händen so schwierig?

In Trainingsdaten erscheinen Hände in einer enormen Vielfalt an Winkeln, Positionen und Sichtbarkeiten; da sie zudem in Ganzkörperaufnahmen oft nur einen kleinen Teil des Bildes ausmachen, erhalten sie während des Trainingsprozesses weniger Gewichtung. Da statistische Muster hier weitaus schwerer zu erlernen sind als bei konsistenteren Merkmalen, bleibt die präzise Darstellung trotz kontinuierlicher Fortschritte eine anspruchsvolle Herausforderung.

Darf ich KI-generierte Bilder kommerziell nutzen?

Die rechtliche Einordnung hängt maßgeblich von der gewählten Plattform sowie der jeweiligen Rechtsprechung ab. Während die meisten kommerziellen Dienste in ihren Nutzungsbedingungen zwar gewerbliche Rechte einräumen, genießen rein KI-generierte Werke – etwa in den USA – oft keinen urheberrechtlichen Schutz. Eine Ausnahme bildet Adobe Firefly, das speziell für den professionellen Einsatz konzipiert wurde und durch das Training mit ausschließlich lizenzierten Inhalten maximale Sicherheit für die kommerzielle Verwendung bietet.

Was unterscheidet Diffusionsmodelle von GANs?

Während GANs auf dem Wettbewerb zwischen zwei Netzwerken – Generator und Diskriminator – basieren, lernen Diffusionsmodelle, einen schrittweisen Verrauschungsprozess präzise umzukehren. Da sie stabiler im Training sind, vielfältigere Ergebnisse liefern und Text-Prompts zuverlässiger umsetzen, haben sich Diffusionsmodelle mittlerweile als führender Standard etabliert.

Das Fazit im Überblick

KI-Bildgeneratoren basieren nicht auf Magie, sondern auf hochentwickelten Diffusionsmodellen, die Texteingaben mittels gezielter, schrittweiser Rauschentfernung in visuelle Inhalte übersetzen. Als komplexe Systeme führen sie Textverständnis und erlernte Bildmuster zusammen, um durch iterative Verfeinerung präzise Bilder direkt aus Ihren Beschreibungen zu generieren.

Sobald Sie einen Prompt eingeben, wird dieser durch auf hunderten Millionen Bild-Text-Paaren trainierte Text-Encoder verarbeitet, um einen Entrauschungsprozess im komprimierten latenten Raum zu steuern und schließlich in voller Auflösung dekodiert zu werden. Wer diese Pipeline im Kern versteht, kann die automatische Bildgenerierung deutlich effizienter und ergebnisorientierter nutzen.

Anstatt lediglich Wünsche in ein Textfeld einzugeben, liefern Sie präzise Konditionierungssignale für einen komplexen mathematischen Prozess, der Ihre Sprache interpretiert, die gezielte Rauschentfernung durch gelernte Muster steuert und so Bilder von Grund auf neu erschafft.

Dieses fundierte Verständnis dient weit mehr als nur der Information: Es befähigt Sie dazu, präzisere Prompts zu formulieren, realistische Erwartungen zu definieren und gezielt die passenden Werkzeuge für Ihre individuellen Anforderungen auszuwählen. Angesichts der rasanten technologischen Entwicklung bildet dieses Wissen das entscheidende Fundament, um auch künftig flexibel und erfolgreich agieren zu können.