AI画像生成の仕組みとは?プロンプトから画像が生まれるまでのプロセスを徹底解説

最終更新日: 2026-01-22 18:08:25

テキストプロンプトが拡散モデルと数学的プロセスを経て、いかにして鮮やかなピクセルへと変換されるのか。AI画像生成の仕組みとその技術的な裏側に迫ります。

プロンプト入力から画像が生成されるまで:AI内部の仕組みを正確かつ簡潔に解説

MidjourneyやDALL-Eに「魔法使いの帽子をかぶった猫、油絵風」といったプロンプトを入力し、実行ボタンを押すだけで、わずか30秒後には世界に二つとない画像が生成される――。今や多くの人が体験しているこの一連のプロセスは、まるで魔法のように感じられるはずです。

一見魔法のように見えるAI画像生成ですが、その背景には緻密な数学的ロジックが組み込まれています。こうした技術の仕組みを深く理解することは、単なる知的好奇心を満たすだけでなく、ツールを自在に操るための大きな力となります。特定のプロンプトが有効である理由を掴むことで、もはや偶然に頼ることなく、明確な意図を持って理想の作品を創り上げることが可能になります。

それでは、AI画像生成の仕組みについて、専門的な論文のような難解さを避けつつ、その内部プロセスを本質的に理解できるレベルまで詳しく紐解いていきましょう。

30秒でわかる概要

AI画像生成は、入力されたプロンプトを「テキストエンベディング」と呼ばれる数値データへ変換し、圧縮された「潜在空間」上のランダムなノイズから描画を開始します。プロンプトの指示に従って拡散モデルが段階的にノイズを除去していくことで、最終的に鮮明なピクセルデータへと復元。さらにCFG(ガイダンススケール)やステップ数、シード値といった設定を調整することで、プロンプトへの忠実度や生成結果の一貫性を自在にコントロールすることが可能です。

AI画像生成が解決する2つの主要な課題

あらゆるAI画像生成ツールは、「プロンプトの意図を正確に理解する」ことと「それをもとに画像を構築する」という、互いに深く関連し合う2つのプロセスを解決することで成り立っています。

課題1:ユーザーの意図を正確に理解する 「ドラマチックな光に照らされた山の夕景」といったプロンプトが入力された際、システムはまずその内容を解析し、処理可能な概念へと落とし込む必要があります。視覚的な「ドラマチックさ」の定義や、夕焼けの色と山の陰影が織りなす相互作用など、言葉の裏にある細かなニュアンスを自然言語処理(NLP)によって紐解くことで、的確なイメージの構築が可能になるのです。

第2の課題は、ピクセルを生成するプロセスそのものです。これはコンピュータビジョンが担う領域であり、ユーザーの指示に基づき、物体の整合性やリアルな光の表現、正確な遠近感を持つ数百万ものカラー値を算出し、一貫性のある画像として描き出します。

現代のAIシステムは、人間の脳内におけるニューロンの伝達や接続の仕組みから着想を得た「ニューラルネットワーク」という計算構造を採用しており、これにより双方の課題を解決しています。

AI画像生成の基盤:ニューラルネットワークの仕組み

個別のアーキテクチャを詳しく掘り下げる前に、まずはニューラルネットワークが画像に対して具体的にどのような処理を行っているのか、その根本的な仕組みを理解しておきましょう。

コンピュータは画像を人間のように「見る」のではなく、膨大な数値が並ぶグリッドとして処理します。例えば、512×512ピクセルのカラー画像は786,432個(512×512ピクセル×3つのカラーチャネル)の数値データで構成されており、ニューラルネットワークは、この膨大な数値の海から特定のパターンを抽出する役割を担っています。

AIモデルの学習過程では膨大な画像データが処理されますが、例えばStable Diffusionにおいては、ウェブ上の公開ソースから収集された約58億5,000万件もの画像・テキストペアを含む「LAION 5B」データセットが活用されています。各画像には代替テキストやキャプションといった関連情報が付随しており、これらを通じてモデルは言語と視覚的概念の相関関係を学習していきます。

この学習プロセスを通じて、ネットワークは段階的にパターンを習得していきます。初期レイヤーが輪郭や基本的な形状を捉え、中間レイヤーが目や車輪、葉といった特定のパーツを認識することで、より深い階層では全体の概念やスタイルまでを包括的に理解できるようになります。

GANから拡散モデルへ:飛躍的な進化を遂げた画像生成技術の歩み

近年、AI画像生成を取り巻く環境は劇的な変貌を遂げており、その進化の軌跡を辿ることで、今日のツールがわずか3年前と比較してこれほどまでに飛躍的な向上を遂げた理由をより深く理解することができます。

GANの時代(2014年〜2021年)

2014年にイアン・グッドフェロウ(Ian Goodfellow)氏によって提唱された「敵対的生成ネットワーク(GAN)」は、2つのニューラルネットワークを互いに競い合わせるという極めて洗練された手法により、長年にわたり画像生成技術の主流としてその地位を確立してきました。

「生成器(ジェネレーター)」が偽の画像を生成しようとする一方で、「識別器(ディスクリミネーター)」はその真偽を鋭く判定します。識別器の精度が向上するほど生成器もそれを欺くためにさらなる進化を求められるという、互いに高め合う競争プロセスを通じて、両ネットワークは極めて高い完成度へと到達します。

2019年当時、GAN(敵対的生成ネットワーク)は飛躍的な進化を遂げ、StyleGANの登場によって実在しない人物の極めて写実的な顔を生成できるようになりました。しかし、その一方で2つのネットワークの同期が崩れるといった学習の不安定さに加え、複数のオブジェクトが混在する複雑なシーンや、手などの緻密なディテールの再現には依然として課題が残されていました。

拡散モデルがもたらした革新(2020年〜現在)

AI画像生成が、拡散モデルと数学的アルゴリズムを駆使してテキストプロンプトをいかに精細なピクセルへと変換するのか、その仕組みとプロセスの裏側を詳しく紐解きます。

2020年、カリフォルニア大学バークレー校のジョナサン・ホー、アジャイ・ジェイン、ピーター・アビールらによって発表された論文「Denoising Diffusion Probabilistic Models(DDPMs)」は、画像生成AIの世界に革命をもたらし、その後の技術のあり方を根本から変える大きな転換点となりました。

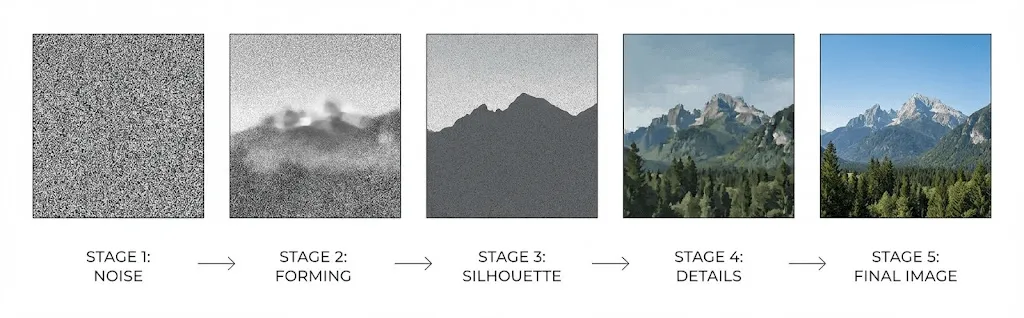

拡散モデルは、ランダムなノイズを段階的に取り除く「ノイズ除去」のプロセスを学習することで画像を生成します。まず、元の画像にノイズを加えて完全な砂嵐状にする工程をニューラルネットワークに学習させ、そのプロセスを逆転させる手法を習得することで、静止画の状態から鮮明な画像を構築することを可能にしています。

順拡散過程:学習用画像に対してガウスノイズを段階的(通常1,000ステップ程度)に加えていくことで、元の画像が何であったか判別できない完全なノイズ状態へと変化させます。

逆拡散プロセス:各ステップでノイズを予測・除去するようネットワークを学習させることで、完全なランダム状態から鮮明な画像を段階的に描き出し、再構築します。

GANを凌駕する高い性能の鍵は、敵対的な構造の調整を必要としない、段階的なアプローチによる本質的な安定性にあります。これにより、生成される画像の多様性が向上するだけでなく、複雑なプロンプトの内容をより正確かつ忠実に反映することが可能になりました。

2021年にDhariwal氏とNichol氏が発表した論文「Diffusion Models Beat GANs on Image Synthesis」は、画像生成において拡散モデルがGANを凌駕したことを決定づけ、その優位性を世に知らしめる転換点となりました。

AI画像生成の仕組み:プロンプトから画像が完成するまでのプロセス解説

Stable Diffusionや DALL-E、Midjourneyにプロンプトを入力した際、その背後で実際にどのような処理が行われているのか、その仕組みを詳しく解説します。

ステップ1:CLIPによるテキストのエンコーディング

入力されたテキストは、まずOpenAIが開発した「CLIP(Contrastive Language Image Pre-training)」などのテキストエンコーダーによって解析・処理されます。

CLIPは4億組に及ぶ画像とテキストのペアを用いた学習により、言語と視覚的コンセプトの相関関係を深く理解しています。入力されたプロンプトは、その意味的な文脈を正確に保持したまま、通常768次元や1024次元といった高次元のベクトルへと変換されます。

このベクトルは、類似した概念が近くに集まる「埋め込み空間」という共通の領域に配置されます。例えば、「犬」と「子犬」は互いに近いベクトルを生成しますが、「犬」と「超高層ビル」のような無関係な言葉同士では、大きく異なるベクトルが生成されるようになっています。

ステップ 2:潜在空間における画像生成プロセス

高解像度画像を直接処理する際の膨大な計算負荷を回避するため、最新のシステムでは「潜在空間」と呼ばれる効率的に圧縮されたデータ領域で演算を行う画期的な手法を採用しています。

2022年にStable Diffusionを発表したRombach氏らの論文は、画質を維持したまま圧縮空間上で拡散プロセスを実行できることを証明しました。この画期的な成果により、高度な画像生成技術は、一般のユーザーにとっても身近で利用しやすいものへと進化したのです。

Stable Diffusionは、512×512ピクセルの画像データ(786,432個の数値)を、わずか16,384個の数値で構成される64×64の潜在表現へと48倍にまで圧縮します。この高度なデータ効率化により、巨大なデータセンターを介さずとも、一般的なコンシューマー向けGPUで十分に実行できる環境を実現しています。

画像生成のプロセスは、潜在空間におけるランダムなノイズから開始されます。これは、ノイズに覆われた高度に圧縮されたキャンバスのような状態をイメージすると分かりやすいでしょう。

ステップ 3:反復的なノイズ除去

いよいよプロセスの核心部へと進みます。ここでは、医療画像セグメンテーションを起源とするU字型のニューラルネットワーク構造「U-Net」が、通常20〜50回の反復処理を通じて段階的にノイズを除去していきます。

各ステップにおいて、U-Netには以下の情報が入力されます:

- ノイズが混在する現在の潜在的なデータ表現

- CLIPによってベクトル化(エンコード)された、入力プロンプトのテキスト埋め込み

- 生成工程の現在地を特定するための、ステップごとのタイムスタンプ

ネットワークが画像内のノイズ量を予測して段階的に除去することで、初期工程で全体の構図や主要な形状を確立し、続く工程でテクスチャや細部を精緻に仕上げていきます。

テキスト埋め込みは「クロスアテンション」メカニズムを介して生成プロセスを導き、ネットワークがプロンプトの各要素に的確に反応することで、画像内のあらゆる箇所における要素の追加や削除を精緻に制御しています。

ステップ4:ピクセルへのデコードと画像の生成

ノイズ除去の完了後、デコーダー(VAE:変分オートエンコーダー)が圧縮された潜在表現を元のフル解像度へと復元します。この「アップサンプリング」の工程を経て、圧縮時に失われていた微細なディテールまでが精緻に再構築されます。

CFG(ガイダンススケール):プロンプトへの忠実度を左右する、唯一の設定

Stable Diffusionを利用する際、「CFG(ガイダンススケール)」という設定を目にしたことがあるかもしれません。これはAIがプロンプトの指示をどの程度忠実に反映するかを直接制御する数値ですが、多くの場合はチュートリアルに従って「7」に設定されたまま運用されています。このパラメーターの役割を正しく理解することで、生成されるイメージをより意図通りにコントロールすることが可能になります。

「Classifier Free Guidance」の略称であるCFGは、ノイズ除去の各プロセスにおいて、実際にはモデルを2回実行することで機能しています。

- 入力されたプロンプトに基づき、指定されたテキストの内容をどのように画像として表現すべきかを導き出します。

- プロンプトを一切使用しない条件下で、基準となる「一般的」な画像がどのような姿になるかをシミュレートします。

最終的な出力はこれら2つの予測の差異を強調する形で生成され、CFG値を高めるほど、入力したプロンプトのコンセプトがより鮮明に反映されるようになります。

しかし、その一方で無視できないトレードオフも存在します。

- 低いCFG(1〜5):AIの独創性が強調される一方、プロンプトの指示が反映されにくくなる場合があります。

- 中程度のCFG(7〜12):表現の自由度と忠実度のバランスが良く、最も汎用性の高い推奨設定です。

- 高いCFG(15以上):プロンプトの内容を厳密に再現しますが、過度な彩度や画像の乱れが生じやすくなります。

主要3大ツールの徹底比較:DALL-E、Midjourney、Stable Diffusion

現在、主要な画像生成AIの多くで「拡散モデル」が採用されていますが、その具体的な実装手法やアプローチは、プロダクトごとに大きく異なります。

DALL-E 3 (OpenAI)

OpenAIのアプローチは、ChatGPTを直接システムに統合している点が特徴です。入力されたプロンプトを生成前にGPT-4が自動で最適化・拡張するため、シンプルな指示からでもDALL-Eは驚くほど洗練された画像を創り出します。この仕組みは初心者にとって非常に便利である一方、プロンプトへの厳密な忠実さを求めるパワーユーザーにとっては、コントロールの余地が少なく感じられる場合もあります。また、従来の画像生成AIの課題であった「画像内への正確なテキスト描写」において、極めて高い性能を誇る点も大きな強みです。

Midjourney

Midjourneyのモデルは、プロンプトへの忠実さよりも視覚的な美しさを重視して最適化されているのが特徴です。たとえ指示を完璧に再現していなくても、他のツールを凌駕する絵画的でシネマティックな質感を生み出すため、多くのユーザーを魅了しています。また、Discordを基盤とした独自のインターフェースは強固なコミュニティを形成している一方、競合他社に比べると技術的な詳細については非公開な部分が多いのも事実です。

Stable Diffusion

ローカル環境で動作し、内部構造の把握から細かなカスタマイズまで自在に行えるオープンソースの選択肢です。特化型の微調整済みモデルや特定の概念を学習させるLoRA、多彩な拡張機能といった膨大なエコシステムが構築されており、高いプライバシー性能や独自モデルの構築、そして究極のコントロールを求める方に最適です。なお、その自由度の高さゆえに、他のツールと比較して習得には一定の時間を要します。

Adobe Firefly

Adobe Stockの画像、オープンライセンスおよびパブリックドメインの作品のみを学習ソースとしているため、著作権への配慮が求められるビジネスシーンでの利用に最適です。PhotoshopやIllustratorとの緊密な連携はもちろん、設計段階から安全性を重視しているため、不適切な表現や物議を醸すようなコンテンツを生成する心配もなく、安心してご活用いただけます。

単なる生成の枠を超えた、高度な表現力

テキストからの画像生成は、あくまで活用の入り口にすぎません。最新のシステムには、表現の幅をさらに広げるために把握しておくべき、多彩な機能が搭載されています。

img2img(イメージ・トゥ・イメージ)

完全なノイズから生成を開始するのではなく、既存の画像に意図的にノイズを加えた状態からプロセスを始め、「ノイズ除去強度(denoising strength)」を調整することで、元の画像からの変化の度合いを自在にコントロールできます。設定を低く抑えれば繊細なスタイルの微調整、高く設定すれば元の構図を活かした大胆な再構成といったように、ニーズに合わせた柔軟な画像生成が可能です。

インペインティングとアウトペインティングによる画像の編集・拡張

インペインティングは、画像内の特定箇所をマスクして周辺のデザインを維持したまま再生成する機能で、不要なオブジェクトの削除や要素の差し替えに最適です。一方、アウトペインティングは元の画像の境界を超えてキャンバスを拡張し、既存のシーンと完璧に調和する背景を自然に描き足すことができます。

ControlNet

ControlNetは、生成プロセスに構造的なガイドを追加することで、要素の配置を精密に制御する技術です。エッジマップや深度マップ、ポーズの骨格、セグメンテーションマスクなどを活用すれば、プロンプトのみでは調整が難しい細かな空間配置も自在に操れるようになり、一貫性のあるキャラクター制作などにおいて極めて重要な役割を果たします。

LoRAとDreamBooth

学習データに含まれていない特定の人物や製品、あるいは独自のスタイルをAIで再現したい場合は、LoRA(Low-Rank Adaptation)やDreamBoothを活用しましょう。わずか20〜30枚程度の画像を用いた微調整(ファインチューニング)を行うだけで、特定のコンセプトを自由自在に生成できる専用モデルを構築することが可能です。

現在の限界とその背景にある要因

AI画像生成には特有の不得意なパターンや課題が存在しますが、その特性をあらかじめ把握しておくことで、生成結果を適切にコントロールし、理想の出力を得ることが可能になります。

AI画像生成が直面する「手の描写」という難題

AI画像生成では、指の本数の不一致や癒着、解剖学的に不自然な構造などが描画されることが少なくありませんが、これは単なる修正可能なバグではなく、技術における本質的な難題といえます。

学習データにおける手は、角度や位置、他との重なり具合が非常に多岐にわたる一方、画像全体に占める割合は小さいため、学習時に十分なリソースが割かれにくい傾向にあります。そのため、顔のように一定の規則性を持つパーツと比較して、「正確な手の形状」という統計的パターンを習得するのは極めて難易度が高いのが現状です。最新モデルでは改善が進んでいるものの、依然としてAI画像生成における大きな課題の一つとなっています。

テキストの描画

DALL-E 3が登場するまで、画像内に判読可能な文字を生成することは極めて困難でした。AIモデルは言葉の意味を理解する一方で、文字の形状を再現するタイポグラフィの制御を苦手としてきましたが、DALL-E 3はこの分野で飛躍的な進歩を遂げました。しかし、複雑なテキストレイアウトについては、依然としてあらゆるプラットフォームで課題が残されています。

画像全体での一貫性を維持

画像生成はプロセスごとに異なるランダムノイズを起点とするため、同一のキャラクターやシーンを一貫して再現することが難しく、シード値の固定や参照画像、LoRAといった既存の手法でも完全な解決には至っていません。こうした一貫性の欠如は、漫画制作やブランドキャラクターの開発など、継続的な描写が不可欠なプロジェクトにおける大きな課題となっています。

空間的推論

「青い立方体の左に赤いボールがあり、その後ろに緑のピラミッドがある」といった複雑な指示では、要素が正しく配置されないことが多々あります。これはAIモデルが個々のオブジェクト自体は認識できても、複数の要素が織り成す緻密な空間的関係の再現を苦手としているためです。

著作権をめぐる課題

しかしながら、法的・倫理的な観点においては、現在非常に複雑な議論が交わされている領域でもあります。

学習データ

多くのAI画像生成モデルは、インターネット上から収集された膨大な画像データによって構築されていますが、その多くは制作者の明示的な同意を得ていないのが実情です。現在、こうした学習手法が著作権侵害に該当するかを巡り複数の訴訟が提起されており、法的な解釈については依然として議論の最中にあります。

生成物の所有権

米国著作権局の裁定では、著作権の保護には人間の創作性が不可欠であるとして、AIのみで生成された画像は対象外とされています。一方で、人間による十分な創造的寄与が認められる場合には権利が認められる可能性もありますが、その具体的な判断基準については現在も法廷で争われており、明確な境界線は示されていません。

プラットフォームの利用規約についても確認が必要です。多くの商用サービスでは生成された画像に関する権利をユーザーに付与していますが、個別の利用目的に合わせ、詳細な規定を事前に確認しておくことが大切です。

より良い結果を得るための実践的なヒント

AI画像生成の技術的な仕組みを理解することは、より効果的なプロンプトを作成するための鍵となります。ここでは、理想の画像を出力するために真に有効なアプローチを詳しく解説します。

はじめに知っておきたい、AI画像生成の核となる重要概念

テキストエンコーダーは単語の配置順によって重み付けを行うため、「夕焼け、ドラマチックな照明、山の風景」といった記述と「夕焼けの山がある風景」という文章形式では、強調されるニュアンスが異なります。そのため、最も重視したい要素をプロンプトの冒頭に配置することで、より理想に近い生成結果を得ることが可能です。

AIが学習済みの概念をリファレンスとして活用する

AIモデルは膨大な学習データからパターンを抽出しているため、抽象的な言葉よりも、特定のアーティストや芸術様式、さらには「Kodak Portra 400」といったフィルム名やカメラの種類を指定するほうが、関連する視覚的特徴をより確実に引き出すことができます。例えば、「ドラマチックな横からの光」とするよりも「レンブラントライティング」と表現するほうが、求めるイメージをより高い精度で具現化することが可能です。

完璧を目指すのではなく、試行錯誤を繰り返す

画像生成において一度で理想通りの結果を得ることは稀ですが、複数のバリエーションから効果的な要素を見極めてプロンプトを洗練させることで、より高い完成度を目指せます。さらに、納得のいく画像が生成されたら、img2imgを活用して全体の構図を維持しながら細部を調整し、理想のイメージへと近づけていくことが可能です。

ネガティブプロンプトの活用

ネガティブプロンプトは、「ぼやけ、歪み、余分な指、透かし、低品質」といった生成画像から排除したい要素を指定するために活用されます。デノイジングの過程でこれら特定の概念が及ぼす影響を抑制する仕組みとなっており、効果的なネガティブプロンプトのパターンを蓄積することで、画像生成における一般的な失敗を未然に防ぐことが可能です。

今後の展望

急速な進化を遂げるこの分野において、今後特に注目すべきいくつかの動向をご紹介します。

- 動画生成:SoraやRunway Gen-3に代表される最新技術は、拡散モデルを動画へと応用することで、テキストからの高品質な映像生成を現実のものとしています。

- 3D生成:テキストや画像からの3Dモデル生成ツールも急速に進化しており、ゲーム制作や製品の可視化、VRといった分野に大きな変革をもたらしています。

- リアルタイム生成:最適化技術の向上により、1秒足らずでの画像生成が可能になるなど、インタラクティブな速度での処理が実現しつつあります。

- 一貫性の向上:新しいアーキテクチャはキャラクターやシーンの整合性という課題を克服し、漫画やアニメーションといった高い継続性が求められるユースケースを切り拓いています。

よくあるご質問

画像生成にはどのくらいの時間がかかりますか?

クラウドサービスでの画像生成には通常10〜30秒ほど要しますが、RTX 3060以上の最新GPUを用いたローカル環境のStable Diffusionであれば、512×512サイズの画像をわずか2〜5秒で作成可能です。なお、解像度やステップ数を増やす場合には、その設定に応じて処理時間も比例して長くなります。

AI画像生成は、既存の画像をコピーしているのでしょうか?

AIは既存の画像を複製・保存しているのではなく、学習を通じて統計的なパターンを抽出していますが、著名な作品についてはある種の「記憶」として定着する場合があります。特に特定のアーティストの作風を再現した画像生成が可能である点は、昨今の著作権に関する議論において極めて重要な争点となっています。

なぜAIは「手」の描写が苦手なのでしょうか?

学習データに含まれる「手」は、角度や位置、その見え方が極めて多様であり、特に全身画像ではサイズが小さいため、学習の優先度が低くなる傾向にあります。形状に一貫性のある他の部位に比べて統計的なパターンの習得が難しく、技術の進歩により精度は向上しているものの、依然として生成における大きな挑戦の一つとなっています。

AI生成画像の商用利用は可能ですか?

権利の扱いはご利用のプラットフォームや各国の法域によって異なりますが、多くの商用サービスでは利用規約を通じて商用利用権を付与しています。一方で、米国などではAIのみによる生成物に著作権が認められない可能性がある点に留意が必要です。例えばAdobe Fireflyは、許諾済みのコンテンツのみを学習に使用しており、当初から商用利用を前提として設計されています。

拡散モデルとGAN(敵対的生成ネットワーク)の主な違いとは?

GAN(敵対的生成ネットワーク)が生成器と識別器という2つのネットワークを競わせる手法であるのに対し、拡散モデルは画像に加えられたノイズを段階的に取り除くプロセスを学習します。学習の安定性に加え、生成される画像の多様性やプロンプトへの忠実な再現力に優れる拡散モデルは、現在の画像生成技術における主流となっています。

まとめ

AI画像生成は決して魔法ではなく、拡散モデルによる高度なシステムによって実現されています。テキストへの深い理解と学習済みの視覚パターンを融合させ、言葉による指示から段階的なデノイジング(ノイズ除去)と反復的な洗練プロセスを経ることで、指示通りの画像を緻密に描き出します。

入力されたプロンプトは、数億規模の学習データを備えたテキストエンコーダーを介して、圧縮された潜在空間内でのノイズ除去プロセスを導き、最終的に高解像度な画像へと復元されます。こうした生成の仕組みを俯瞰的に理解することは、AIをより自在に、かつ効果的に使いこなすための大きな鍵となります。

AI画像生成は単なるテキスト入力の枠を超え、あなたの言葉を数学的プロセスにおける「条件付け信号」へと変換します。AIが言語を精緻に解釈し、学習済みのパターンに従ってノイズを除去しながら、画像をゼロから一気に再構成していくのです。

こうした仕組みへの理解は、単に好奇心を満たすだけでなく、精度の高いプロンプトの作成や最適なツールの選定、さらには現実的な成果の予測を可能にします。技術革新が加速する現代において、この基礎知識は、進化し続けるAI技術に柔軟に対応し、その真価を引き出すための確かな土台となるでしょう。