Comment fonctionnent les générateurs d’images IA ? Découvrez le processus de création, étape par étape, du prompt à l’image.

Dernière mise à jour: 2026-01-22 18:08:25

Découvrez comment les générateurs d'images IA transforment vos prompts textuels en pixels, en s'appuyant sur la puissance des modèles de diffusion et des mathématiques.

Découvrez comment les générateurs d'images IA transforment vos prompts textuels en pixels, en s'appuyant sur la puissance des modèles de diffusion et des mathématiques.

Que se passe-t-il une fois votre prompt saisi ? Une explication claire et précise du processus de création.

C'est une expérience désormais familière : en saisissant une simple commande comme « un chat portant un chapeau de magicien, style peinture à l'huile » dans Midjourney ou DALL-E, on voit apparaître en quelques secondes une œuvre totalement inédite, selon un procédé qui semble presque relever de la magie.

Loin de relever de la magie, cette technologie repose sur une architecture mathématique complexe dont la compréhension s’avère essentielle pour maîtriser pleinement ces outils. En saisissant les mécanismes qui font la réussite d'un prompt, vous ne vous contentez plus de deviner, mais apprenez à façonner vos visuels avec une intention créative précise.

Décryptons ensemble ce processus : sans sombrer dans l'abstraction académique, nous allons explorer les mécanismes internes de cette technologie pour vous permettre d'en saisir concrètement le fonctionnement.

L'essentiel en 30 secondes :

Les générateurs d'images IA convertissent vos descriptions en données numériques (embeddings) afin d'initier un processus de création au cœur d'un « espace latent » compressé. En partant d'un bruit aléatoire, un modèle de diffusion affine progressivement l'image sous la direction de votre prompt jusqu'au décodage final en pixels, tandis que des paramètres tels que le CFG (échelle de guidage), le nombre d'étapes et la graine (seed) permettent de contrôler précisément la fidélité au texte et la cohérence du résultat.

Les deux problématiques majeures résolues par les générateurs d'images IA

Tout générateur d'images IA repose sur la résolution de deux défis techniques indissociables : l'interprétation précise de votre prompt et la génération fluide de l'image finale.

Le premier défi : l'interprétation sémantique. Lorsqu’une requête telle que « coucher de soleil sur les montagnes avec un éclairage spectaculaire » est soumise, le système doit traduire ces termes en concepts visuels exploitables. C’est ici qu’intervient le traitement du langage naturel pour analyser la portée esthétique de l'adjectif « spectaculaire » et comprendre comment les nuances du crépuscule interagissent avec les ombres des reliefs.

Deuxième enjeu : la matérialisation des pixels. Afin de respecter scrupuleusement vos instructions, le système génère des millions de valeurs chromatiques pour composer des objets cohérents, des éclairages réalistes et des perspectives précises, illustrant ainsi toute la complexité de la vision par ordinateur.

Afin de répondre à ces enjeux, les systèmes modernes exploitent des réseaux de neurones, des structures de calcul sophistiquées s'inspirant librement des mécanismes de connexion et de communication de notre propre cerveau.

Les réseaux neuronaux : le socle technologique

Avant d'explorer les différentes architectures, il est essentiel de comprendre comment les réseaux de neurones traitent et interprètent concrètement les images.

Contrairement à l’œil humain, l’ordinateur interprète une image comme une vaste matrice de données numériques : pour un format de 512x512 pixels, le réseau de neurones doit ainsi traiter 786 432 valeurs individuelles afin d’y déceler des structures et des motifs cohérents au sein de cette masse d'informations.

Lors de leur phase d'apprentissage, ces réseaux traitent des millions d'images, à l'instar de Stable Diffusion qui s'est appuyé sur LAION 5B, un ensemble de données regroupant environ 5,85 milliards de paires image-texte issues de sources publiques en ligne. Grâce à l'étude des textes associés à chaque visuel — qu'il s'agisse de balises alt, de légendes ou de contenus environnants — le modèle parvient à assimiler les corrélations profondes unissant le langage aux concepts visuels.

Grâce à cet apprentissage structuré en plusieurs niveaux, le réseau identifie d'abord les contours et les formes élémentaires, avant de reconnaître des composants plus complexes tels que des yeux ou du feuillage, pour finalement appréhender des concepts et des styles artistiques dans leur globalité.

De l'architecture GAN aux modèles de diffusion : l'évolution d'une technologie

Le paysage de la création d'images par IA a connu une mutation profonde ces dernières années, une évolution majeure qui permet de comprendre l'écart technologique saisissant entre les outils actuels et les solutions disponibles il y a seulement trois ans.

L'ère des GAN (2014-2021)

Longtemps restés la référence depuis leur introduction par Ian Goodfellow en 2014, les réseaux adverses génératifs reposent sur un concept aussi élégant que puissant : la mise en compétition de deux réseaux neuronaux distincts.

Le système repose sur l'interaction entre un générateur créant des images et un discriminateur chargé d'en détecter l'inauthenticité. Cette véritable course à la performance pousse le générateur à se perfectionner pour tromper un discriminateur toujours plus perspicace, une dynamique constante qui propulse les deux réseaux vers un niveau d'excellence et de réalisme supérieur.

Dès 2019, les réseaux antagonistes génératifs (GAN) réalisaient des prouesses remarquables avec StyleGAN, capable de créer des visages photoréalistes de personnes fictives, malgré des limites structurelles notables. Cette technologie se heurtait en effet à une certaine instabilité lors de l'entraînement et peinait à restituer fidèlement des scènes complexes ou des détails anatomiques précis tels que les mains.

La révolution de la diffusion (de 2020 à nos jours)

La publication en 2020 de l’article « Denoising Diffusion Probabilistic Models » (DDPMs) par Jonathan Ho, Ajay Jain et Pieter Abbeel de l'UC Berkeley a marqué un tournant historique, révolutionnant durablement le secteur.

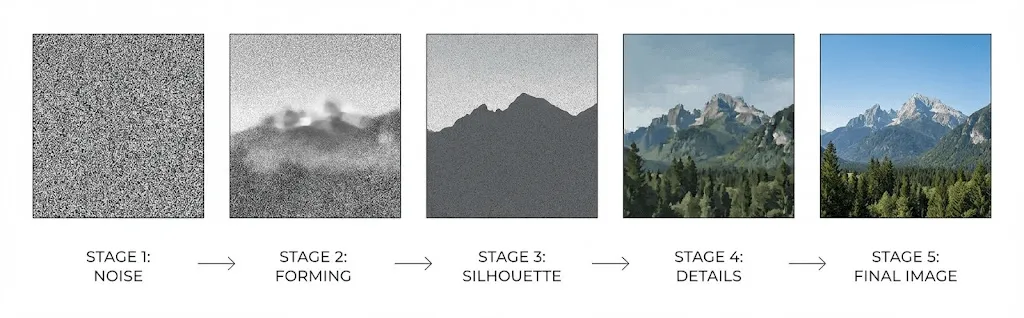

Le fonctionnement des modèles de diffusion repose sur l'inversion du bruit : en partant d'un état de statique aléatoire, l'IA effectue un « débruitage » progressif pour révéler une image finale. Ce processus s'appuie sur un réseau neuronal préalablement entraîné à renverser la dégradation volontaire d'une image, lui permettant ainsi de transformer le chaos visuel en une création structurée.

Le processus de diffusion : À partir d’une image d’entraînement, du bruit gaussien est ajouté progressivement sur une multitude d’étapes — généralement un millier — jusqu'à transformer l’original en un bruit statique totalement méconnaissable.

Le processus d'inversion : En apprenant à prédire et à éliminer le bruit à chaque étape, le réseau parvient à reconstruire progressivement une image structurée à partir d'un état de chaos total.

Supérieure aux modèles GAN, cette approche par étapes garantit une stabilité accrue en s’affranchissant des dynamiques adverses complexes, permettant ainsi de générer des contenus plus diversifiés tout en respectant avec précision les instructions les plus élaborées.

En 2021, la publication de l’étude de Dhariwal et Nichol, intitulée « Diffusion Models Beat GANs on Image Synthesis », a marqué un tournant décisif en officialisant la suprématie des modèles de diffusion.

Fonctionnement de l'IA génératrice d'images : les étapes clés du processus

Découvrez les coulisses technologiques qui s'activent lorsque vous soumettez un prompt à Stable Diffusion, DALL-E ou Midjourney :

Étape 1 : L'encodage textuel avec CLIP

Votre texte est d'abord traité par un encodeur, généralement le modèle CLIP (Contrastive Language Image Pre-training) développé par OpenAI.

Grâce à un entraînement sur 400 millions de paires d'images et de textes, CLIP parvient à décrypter les relations entre le langage et les concepts visuels pour convertir vos prompts en vecteurs de haute dimension (généralement 768 ou 1024) capables d'en saisir toute la profondeur sémantique.

Ce vecteur évolue au sein d’un « espace d’incorporation » partagé où les concepts sémantiquement proches se regroupent, permettant ainsi à des termes comme « chien » et « chiot » de générer des vecteurs similaires, contrairement à des notions totalement distinctes telles que « chien » et « gratte-ciel ».

Étape 2 : Le traitement au cœur de l'espace latent

C’est ici que réside toute l’ingéniosité du processus : pour pallier la complexité technique du traitement d’images haute résolution, les systèmes modernes opèrent au sein d’un « espace latent », une forme de représentation compressée bien plus efficace.

Dans leur article de 2022 introduisant Stable Diffusion, Rombach et al. ont démontré que le processus de diffusion pouvait s'opérer au sein de cet espace compressé sans altérer la qualité, une avancée majeure ayant permis de mettre cette technologie à la portée du grand public.

En réduisant le volume de données par 48, Stable Diffusion parvient à compresser une image de 512×512 (786 432 valeurs) en une représentation latente de seulement 64×64 (16 384 valeurs), permettant ainsi une exécution fluide sur un GPU grand public sans avoir recours à la puissance de calcul d'un centre de données.

Le processus de création s'amorce au sein de cet espace latent par l'apparition d'un bruit aléatoire, semblable à une toile de parasites flous et hautement compressés.

Étape 3 : Le processus de débruitage itératif

Au cœur de cette étape cruciale, l’architecture U-Net — un réseau neuronal en forme de « U » conçu à l'origine pour l'imagerie médicale — procède au débruitage progressif de l'image via une série de 20 à 50 itérations successives.

À chaque étape du processus, le réseau U-Net reçoit les éléments suivants :

- La représentation latente bruitée en cours de traitement

- L'encodage textuel (embedding) issu de CLIP traduisant votre prompt

- Le marqueur temporel précisant la phase actuelle du processus

Le réseau évalue précisément le niveau de bruit de l'image afin d'en soustraire une portion calculée, permettant ainsi d'esquisser la composition et les formes globales dès les premières étapes avant de parfaire les textures et les détails lors de la phase finale.

Grâce aux mécanismes d'« attention croisée », l'intégration textuelle pilote l'ensemble du processus : le réseau analyse ainsi les segments pertinents de votre prompt pour déterminer avec précision les éléments à ajouter ou à supprimer en chaque point de l'image.

Étape 4 : Décodage final et restitution de l'image en pixels

Une fois le processus de débruitage terminé, un décodeur de type Auto-encodeur Variationnel (VAE) convertit la représentation latente pour lui redonner sa pleine résolution, reconstituant ainsi par suréchantillonnage la finesse des détails qui avaient été initialement compressés.

CFG (Guidance Scale) : le réglage clé pour garantir la fidélité de vos prompts

Si vous utilisez Stable Diffusion, vous avez certainement déjà rencontré les paramètres de « CFG » ou d'« échelle de guidage », qui déterminent la fidélité du modèle vis-à-vis de vos instructions. Bien que la valeur par défaut de 7 soit généralement adoptée par mimétisme des tutoriels, la maîtrise de ce réglage est pourtant essentielle pour affiner vos créations et obtenir un contrôle total sur vos résultats.

Le paramètre CFG, ou « Classifier Free Guidance », repose sur une double exécution systématique du modèle lors de chaque étape de débruitage :

- Une analyse basée sur votre prompt pour déterminer l'apparence précise de l'image selon vos instructions textuelles.

- Une évaluation sans aucune consigne afin de définir ce que serait une version générique de ce visuel.

Le rendu final met en exergue la distinction entre ces deux prédictions, une valeur de CFG plus élevée permettant d'aligner plus étroitement l'image sur les concepts énoncés dans votre prompt.

Toutefois, un compromis s'impose :

- CFG faible (1 – 5) : privilégie la liberté créative, au risque toutefois de s'écarter de vos instructions.

- CFG moyen (7 – 12) : représente l'équilibre optimal pour obtenir des résultats harmonieux.

- CFG élevé (15+) : assure une fidélité stricte au prompt, bien que cela puisse entraîner une saturation excessive ou l'apparition d'artefacts.

Comparatif des solutions de référence : DALL-E, Midjourney et Stable Diffusion

Si les modèles de diffusion constituent aujourd'hui le socle de tous les grands générateurs d'images, leurs modes d'implémentation divergent toutefois de manière significative.

DALL-E 3 (OpenAI)

L'approche d'OpenAI repose sur une intégration directe de ChatGPT : dès la saisie d'un prompt, GPT-4 le reformule et l'enrichit afin que DALL-E puisse interpréter des instructions simples avec une sophistication inattendue. Si cette fluidité profite aux utilisateurs occasionnels, elle offre cependant moins de contrôle aux experts exigeant une stricte fidélité textuelle. Enfin, l'outil excelle dans le rendu de textes au sein des images, palliant ainsi une faiblesse historique des générateurs d'intelligence artificielle.

Midjourney

Privilégiant l’esthétique à la précision littérale, le modèle de Midjourney génère des œuvres au rendu pictural ou cinématographique souvent jugé plus attrayant que celui de ses concurrents, et ce, même en s'écartant parfois du prompt initial. Si son interface atypique via Discord a su fédérer une communauté solide, l'entreprise cultive toutefois une certaine opacité quant aux spécificités techniques de sa technologie.

Stable Diffusion

Privilégiant la transparence et la flexibilité, cette option open source permet une exécution locale tout en offrant une liberté totale de modification. Elle s’appuie sur un vaste écosystème composé de modèles optimisés, d'extensions et de LoRA (adaptations de rang faible) permettant d'intégrer des concepts spécifiques. Malgré une courbe d'apprentissage plus exigeante, c'est le choix par excellence pour garantir un contrôle maximal, une confidentialité absolue ou pour entraîner vos propres modèles personnalisés.

Adobe Firefly

Entraîné exclusivement à partir d'images Adobe Stock, de contenus sous licence libre et d'œuvres du domaine public, ce modèle garantit une utilisation commerciale sereine en s'affranchissant des risques liés aux droits d'auteur. Parfaitement intégré à Photoshop et Illustrator, il privilégie par ailleurs des résultats plus modérés que ses concurrents afin d'exclure, par conception, tout contenu sensible ou controversé.

Au-delà de la simple génération

La simple génération d’images à partir de texte n’est qu’un début, les systèmes actuels offrant une multitude de fonctionnalités avancées qu'il convient d’explorer pour en maîtriser tout le potentiel.

Génération d’image à image (img2img)

Plutôt que de partir d’un bruit aléatoire, la création repose ici sur une image existante à laquelle du bruit a été partiellement ajouté. Le réglage de la « force de débruitage » permet alors de moduler cet apport afin de définir l’écart entre l'image source et le résultat final : une intensité faible se limite à des ajustements stylistiques subtils, tandis qu'une valeur élevée autorise une réinterprétation complète de la scène tout en s'appuyant sur la structure originale.

Retouche et extension d’image

L'Inpainting permet de retoucher précisément vos créations en régénérant uniquement les zones masquées pour supprimer ou remplacer des éléments, tandis que l'Outpainting étend vos images au-delà de leur cadre initial en générant un contenu parfaitement cohérent avec la scène existante.

ControlNet

ControlNet enrichit le processus de génération d'un guidage structurel avancé en vous permettant d'utiliser des cartes de contours, de profondeur, des squelettes de pose ou des masques de segmentation. Ce contrôle spatial de haute précision, qu'un prompt seul ne pourrait atteindre, s'avère indispensable pour maîtriser la disposition des éléments ou garantir la parfaite cohérence de vos personnages.

La personnalisation via LoRA et DreamBooth

Pour générer des images d’une personne, d’un produit ou d’un style spécifique non inclus dans les données d’entraînement d’origine, les technologies LoRA (Low Rank Adaptation) et DreamBooth permettent d’affiner vos modèles à partir de jeux de données restreints, ne comptant parfois que 20 à 30 images. Vous obtenez ainsi un modèle capable de reproduire fidèlement n'importe quel concept personnalisé sur simple demande.

Les limites actuelles et leurs origines technologiques

Comprendre les limites techniques inhérentes aux générateurs d’images IA vous permettra de mieux les appréhender afin de contourner efficacement ces obstacles récurrents.

Le défi notoire de la représentation des mains

Les générateurs d'images IA sont réputés pour leurs difficultés à modéliser les mains, produisant souvent un nombre de doigts erroné ou des structures anatomiquement impossibles ; loin d'être un simple bogue technique, cette anomalie constitue un défi technologique fondamental.

Dans les bases de données d’entraînement, les mains apparaissent sous une multitude d'angles, de positions et de degrés d'occlusion, occupant une surface réduite qui limite l’attention algorithmique qui leur est portée. De ce fait, l’apprentissage de leurs motifs statistiques s’avère bien plus complexe que celui de traits plus constants, tels que les visages ; un défi technique qui persiste malgré les avancées significatives des modèles récents.

Rendu du texte

Avant l'arrivée de DALL-E 3, la génération de texte lisible représentait un défi quasi insurmontable pour les modèles d'IA, qui peinent souvent à traduire la sémantique des mots en formes typographiques précises. Bien que DALL-E 3 ait réalisé des progrès notables, la création de mises en page textuelles complexes demeure incertaine sur l'ensemble des plateformes actuelles.

Cohérence et continuité visuelle

Puisque chaque processus de génération repose sur un bruit aléatoire initial, maintenir la cohérence d'un personnage ou d'une scène s'avère complexe. Bien que des techniques comme le verrouillage de la graine (seed), les images de référence ou les LoRAs offrent des solutions partielles, aucune ne résout totalement le défi de l'uniformité, limitant ainsi certains usages professionnels tels que la création de bandes dessinées ou le développement d'identités visuelles de marque.

Raisonnement spatial

Bien que les modèles identifient parfaitement les objets isolés, ils peinent souvent à restituer des relations spatiales complexes, de sorte qu'une instruction telle que « la balle rouge est à gauche du cube bleu, derrière la pyramide verte » aboutit fréquemment à des compositions imprécises.

La question du droit d'auteur

C’est précisément ici que se cristallisent des enjeux juridiques et éthiques majeurs.

Données d'entraînement

La plupart des modèles d’IA génératrice d'images s'appuient sur des milliards de visuels collectés sur Internet, souvent sans le consentement explicite des créateurs originaux, une pratique aujourd'hui contestée par de nombreux recours en justice pour violation du droit d'auteur dans un paysage juridique encore incertain.

Propriété des contenus générés

Aux États-Unis, l'Office du droit d'auteur a statué que les images générées exclusivement par l'IA ne peuvent prétendre à une protection juridique, le droit d'auteur reposant impérativement sur une création humaine. Si les œuvres témoignant d'une « contribution créative humaine suffisante » peuvent toutefois être éligibles, la frontière exacte de ce critère demeure floue et fait actuellement l'objet de nombreux litiges devant les tribunaux.

Il est également primordial de tenir compte des conditions d'utilisation des plateformes : si la majorité des services commerciaux octroient aux utilisateurs les droits sur les images générées, il convient néanmoins d'étudier attentivement les clauses spécifiques selon l'usage que vous projetez.

Conseils pratiques pour des résultats optimaux

Comprendre les mécanismes technologiques sous-jacents vous permettra de maîtriser l'art du prompt afin d'obtenir des résultats réellement performants :

Comprendre les principes fondamentaux de la génération d'images

L’encodeur de texte attribuant une importance variable aux mots selon leur position, l’accentuation d’un prompt comme « Coucher de soleil, lumière spectaculaire, paysage de montagne » différera d’une formulation narrative, rendant ainsi essentiel le placement de vos éléments prioritaires dès le début de la description.

Utilisez des références maîtrisées par le modèle

Grâce à leur apprentissage sur de vastes ensembles de données, les modèles d’IA réagissent avec une précision accrue aux références concrètes plutôt qu'aux descriptions abstraites. En invoquant des artistes célèbres, des courants artistiques ou des supports spécifiques comme le « Kodak Portra 400 », vous activez des motifs visuels établis qui garantissent une plus grande fidélité ; ainsi, une commande précisant un « éclairage Rembrandt » s'avérera bien plus efficace qu'une simple mention d'un « éclairage latéral dramatique ».

Privilégiez l'itération à la recherche de perfection

La création d'images étant rarement un processus immédiat, multipliez les variantes afin d'identifier les résultats les plus probants et d'affiner vos prompts. En vous appuyant sur la fonction img2img pour vos générations réussies, vous pourrez ainsi itérer sur des détails spécifiques tout en préservant l'harmonie de la composition globale.

Affinez vos créations grâce aux prompts négatifs

Les prompts négatifs permettent de préciser les éléments à exclure, tels que le flou, les distorsions ou les filigranes, en minimisant l'influence de ces concepts lors du processus de débruitage. La constitution d'une bibliothèque de termes d'exclusion robuste devient ainsi un atout majeur pour prévenir les défauts de rendu classiques et garantir une qualité d'image optimale.

Perspectives et évolutions à venir

Dans ce secteur en constante évolution, plusieurs innovations majeures méritent d'être suivies avec une attention particulière :

- Génération vidéo : Sous l'impulsion de modèles tels que Sora ou Runway Gen 3, la technologie de diffusion s'étend désormais à la vidéo, transformant la création de contenus haute fidélité à partir de simples commandes textuelles en une réalité tangible.

- Modélisation 3D : La maturation rapide des outils convertissant le texte ou l'image en 3D révolutionne les processus de création, avec des retombées directes pour le jeu vidéo, la visualisation de produits et la réalité virtuelle.

- Génération en temps réel : Des optimisations algorithmiques majeures tendent vers des vitesses de traitement interactives, permettant à certaines solutions de générer des visuels en moins d'une seconde.

- Cohérence visuelle renforcée : De nouvelles architectures résolvent les problèmes de continuité des personnages et des décors, ouvrant ainsi la voie à des applications professionnelles dans les secteurs de la bande dessinée et de l'animation.

Questions fréquentes

Combien de temps faut-il pour générer une image ?

Si les services cloud requièrent habituellement entre 10 et 30 secondes pour générer une image, une configuration locale sous Stable Diffusion dotée d'un GPU moderne (RTX 3060 ou supérieur) permet d'obtenir un rendu en 512×512 en seulement 2 à 5 secondes, bien que ce délai s'allonge proportionnellement à la résolution et au nombre d'étapes de calcul souhaités.

Les générateurs d’IA se contentent-ils de copier des images existantes ?

Loin de stocker des copies, ces modèles assimilent des schémas statistiques, même si certaines œuvres célèbres peuvent être « mémorisées ». Cette faculté à reproduire le style d'artistes précis génère ainsi des résultats dont la similarité avec les originaux alimente aujourd'hui de vifs débats sur le droit d'auteur.

Pourquoi le rendu des mains est-il si complexe pour l'IA ?

Dans les données d’entraînement, la représentation des mains varie considérablement selon l’angle, la position ou la visibilité, et leur petite taille sur les plans larges limite l’attention qui leur est accordée durant l’apprentissage. Il est donc plus ardu pour l’IA d’en extraire des modèles statistiques stables, contrairement à d’autres traits plus uniformes ; toutefois, malgré ce défi persistant, la précision de rendu ne cesse de progresser.

Puis-je utiliser les images générées par IA à des fins commerciales ?

Selon la plateforme et votre juridiction, l'usage commercial est généralement autorisé par les conditions de service, bien que le statut du droit d'auteur pour les contenus purement générés par IA reste incertain, notamment aux États-Unis. Pour pallier cela, Adobe Firefly a été spécifiquement conçu pour un usage professionnel grâce à un entraînement exclusif sur des contenus sous licence.

Modèles de diffusion et GAN : quelles sont les différences ?

Tandis que les architectures GAN reposent sur la confrontation entre un générateur et un discriminateur, les modèles de diffusion privilégient l'inversion d'un processus graduel d'ajout de bruit. Cette technologie s'impose désormais comme la référence du secteur grâce à une stabilité d'apprentissage accrue, permettant de générer des contenus plus diversifiés tout en respectant scrupuleusement les nuances de chaque prompt.

L'essentiel

Loin de toute magie, les générateurs d'images par IA reposent sur des modèles de diffusion sophistiqués qui transforment vos descriptions en visuels grâce à un processus de débruitage guidé étape par étape. En alliant la compréhension textuelle à l’apprentissage de motifs visuels, ces systèmes affinent l’image de manière itérative pour traduire fidèlement vos idées en pixels.

Dès la saisie de votre prompt, celui-ci est traité par des encodeurs textuels entraînés sur des centaines de millions de paires images-textes afin de piloter un processus de débruitage au sein d'un espace latent compressé, avant d'être décodé en haute résolution. La compréhension de ce flux de travail, même superficielle, constitue un atout majeur pour optimiser vos créations et gagner en efficacité.

Bien plus qu'une simple formulation de souhaits, votre saisie génère des signaux de conditionnement qui pilotent un processus mathématique complexe. En interprétant votre langage, ce système guide la réduction du bruit via des schémas d'apprentissage approfondis afin de reconstruire intégralement vos images.

Bien plus qu'une simple curiosité, cette expertise vous permet de perfectionner vos prompts et de choisir les outils adaptés à vos besoins tout en définissant des attentes réalistes. Ces fondamentaux constituent un socle essentiel pour vous adapter sereinement aux évolutions constantes d'une technologie en pleine mutation.