Как работают ИИ-генераторы изображений: пошаговый путь от текстового промпта к готовому результату

Последнее обновление: 2026-01-22 18:08:25

Что происходит после ввода промпта: простое и точное объяснение процесса ИИ-генерации

Многим из нас уже знаком этот сценарий: вы вводите в Midjourney или DALL-E запрос вроде «кот в шляпе волшебника, стиль масляной живописи», и буквально через 30 секунд перед вашими глазами предстает совершенно уникальное изображение, создание которого кажется настоящим волшебством.

За внешней магией процесса скрываются сложные математические алгоритмы, понимание которых дает не просто теоретические знания, но и ощутимое преимущество при работе с ИИ. Разобравшись, почему одни промпты эффективны, а другие — нет, вы перестанете действовать наугад и начнете осознанно управлять процессом генерации, превращая каждый запрос в точный инструмент творчества.

Предлагаем детально разобрать принципы работы технологии: не углубляясь в академические тонкости, мы изучим процесс достаточно подробно, чтобы вы получили полное представление о внутренних механизмах системы.

Коротко о главном (30 секунд):

ИИ-генераторы создают изображения, преобразуя текстовые промпты в математические эмбеддинги. В основе процесса лежит работа диффузионной модели в сжатом «латентном пространстве»: она пошагово устраняет случайный шум, формируя картинку под руководством вашего запроса до тех пор, пока финальный результат не будет преобразован в готовые пиксели. Гибкость генерации обеспечивается настройками CFG (шкала соответствия), количеством шагов и значениями сидов, которые определяют точность следования промпту и визуальную стабильность итогового контента.

Две ключевые задачи, решаемые ИИ-генераторами изображений

В основе работы любого ИИ-генератора изображений лежит решение двух взаимосвязанных задач: интерпретации текстового запроса и последующего создания визуального контента.

Задача первая: интерпретация смысла. Когда вы вводите запрос — например, «закат в горах с драматичным освещением», — системе необходимо преобразовать эти слова в понятные ей визуальные концепции. Благодаря алгоритмам обработки естественного языка ИИ анализирует семантику фразы, определяя эстетику «драматизма» и принципы взаимодействия закатных оттенков с глубокими тенями горного ландшафта.

Вторая задача: формирование пикселей. С помощью технологий компьютерного зрения система преобразует ваши инструкции в миллионы цветовых значений, создавая целостные объекты с реалистичным освещением и правильной перспективой.

Для решения обеих задач в современных системах используются нейронные сети — вычислительные структуры, архитектура которых вдохновлена принципами взаимодействия нейронов в человеческом мозге.

Нейросети: технологический фундамент

Прежде чем переходить к детальному разбору архитектур, важно разобраться в самих принципах работы нейронных сетей с визуальным контентом и понять, как именно они интерпретируют изображения.

В отличие от человеческого зрения, компьютер воспринимает любое изображение как масштабную сетку числовых значений. Так, стандартная цветная картинка форматом 512×512 пикселей содержит 786 432 отдельных параметра, а основная задача нейросети заключается в поиске скрытых закономерностей в этом колоссальном массиве данных.

В процессе обучения подобные нейросети обрабатывают миллионы изображений; так, модель Stable Diffusion прошла подготовку на базе LAION 5B, содержащей около 5,85 миллиарда пар «изображение–текст» из открытых веб-источников. Сопровождение каждого изображения метаданными — от подписей до тегов «alt» и контекстного описания — позволяет алгоритму выстраивать устойчивые ассоциации между лингвистическими и визуальными концепциями.

В ходе этого процесса нейросеть поэтапно анализирует образы на нескольких уровнях: если начальные слои фиксируют края и простые формы, то промежуточные — распознают отдельные элементы (например, глаза, колеса или листья), а наиболее глубокие позволяют системе осваивать целостные концепции и художественные стили.

Эволюция технологий: путь от архитектуры GAN к диффузионным моделям

За последние несколько лет сфера генерации изображений с помощью ИИ претерпела стремительную трансформацию, и понимание пройденного пути наглядно объясняет, почему современные инструменты стали несоизмеримо эффективнее решений трехлетней давности.

Эпоха GAN (2014–2021 гг.)

Генеративно-состязательные сети (GAN), представленные Яном Гудфеллоу в 2014 году, на протяжении многих лет оставались ведущей технологией в отрасли благодаря своей изящной архитектуре, построенной на соперничестве двух нейронных сетей.

В основе процесса лежит взаимодействие двух нейросетей: генератора, создающего изображения, и дискриминатора, задача которого — распознать подделку. Такое соперничество превращается в своего рода «гонку вооружений»: по мере того как дискриминатор учится точнее выявлять фальсификации, генератор вынужден постоянно совершенствоваться, чтобы обойти проверку, что в конечном итоге позволяет обеим системам достичь исключительного качества результата.

К 2019 году технология GAN достигла впечатляющих результатов: алгоритм StyleGAN уже создавал фотореалистичные портреты несуществующих людей, однако архитектура имела свои ограничения. Процесс обучения оставался нестабильным из-за риска рассинхронизации нейросетей, а генерация сложных многофигурных композиций или таких мелких деталей, как кисти рук, по-прежнему вызывала серьезные трудности.

Революция диффузионных моделей: с 2020 года по настоящее время

Узнайте, как работают ИИ-генераторы изображений: как на основе математических алгоритмов и диффузионных моделей текстовые промпты превращаются в готовые пиксели.

Опубликованная в 2020 году научная работа Джонатана Хо, Аджая Джейна и Питера Аббиля из Калифорнийского университета в Беркли под названием «Denoising Diffusion Probabilistic Models» (DDPMs) стала настоящим прорывом, который кардинально изменил сложившуюся парадигму.

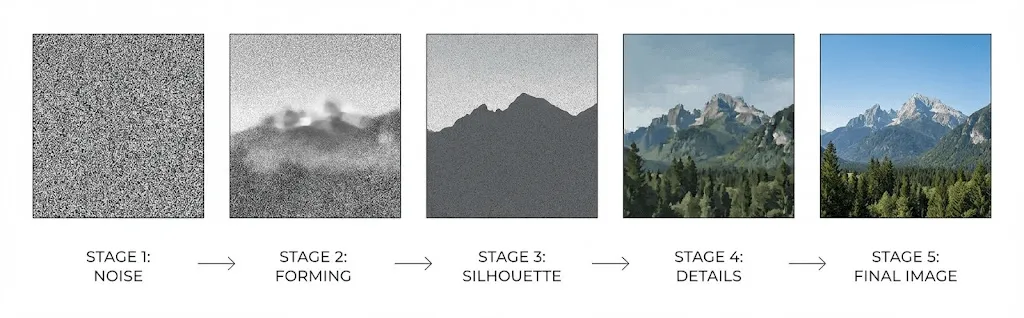

Принцип работы диффузионных моделей основан на обучении нейросети процессу обратного преобразования шума: она постепенно «очищает» хаотичные помехи, превращая их в детализированное изображение. В ходе обучения алгоритм анализирует, как исходные кадры последовательно искажаются до состояния полного статического шума, что позволяет ему эффективно восстанавливать структуру и генерировать визуальные образы буквально из ничего.

Прямой процесс: На обучающее изображение последовательно накладывается гауссов шум, который за множество итераций (как правило, до 1 000 шагов) превращает исходный контент в абсолютно неразличимый статический фон.

Обратный процесс: нейросеть обучается прогнозировать и последовательно устранять шум на каждом этапе, что позволяет постепенно воссоздавать четкое и осмысленное изображение из абсолютно хаотичного набора данных.

Превосходство данной технологии над архитектурой GAN обусловлено пошаговым алгоритмом, который обеспечивает исключительную стабильность процесса без необходимости балансировать состязательную динамику. В результате модели генерируют более разнообразный контент и значительно точнее интерпретируют сложные текстовые запросы.

Опубликованная в 2021 году работа Даривала и Никола «Diffusion Models Beat GANs on Image Synthesis» официально закрепила триумф диффузионных моделей, подтвердив их технологическое лидерство в сфере синтеза изображений.

Принципы работы ИИ-генераторов: пошаговый разбор процесса создания изображений по тексту

Когда вы вводите текстовый запрос в Stable Diffusion, DALL-E или Midjourney, запускается сложный процесс визуализации — и вот что на самом деле происходит в этот момент:

Шаг 1: Кодирование текстового запроса с использованием CLIP

На первом этапе ваш запрос обрабатывается текстовым энкодером — чаще всего это модель CLIP (Contrastive Language Image Pre-training), разработанная специалистами OpenAI.

Модель CLIP, обученная на 400 миллионах пар изображений и текстов для глубокого понимания связи между языковыми и визуальными концепциями, преобразует ваш промпт в высокоразмерный вектор (обычно 768 или 1024 измерения), который в точности передает семантическое значение запроса.

Данный вектор помещается в единое пространство эмбеддингов, где близкие по смыслу понятия группируются вместе: так, слова «собака» и «щенок» формируют схожие векторы, в то время как для образов «собака» и «небоскреб» они будут кардинально различаться.

Этап 2: Работа в латентном пространстве

Для оптимизации ресурсов и обхода сложностей, связанных с прямой обработкой графики высокого разрешения, современные системы используют «латентное пространство» — эффективную форму сжатого представления данных.

В своей знаковой работе 2022 года, посвященной запуску Stable Diffusion, Ромбах и соавторы доказали, что процесс диффузии может эффективно протекать в сжатом пространстве без ущерба для качества. Этот технологический прорыв стал ключевым фактором, сделавшим передовые инструменты генерации доступными для широкого круга пользователей.

Stable Diffusion оптимизирует процесс генерации, сжимая изображение размером 512×512 (786 432 значения) до компактного латентного представления 64×64 (всего 16 384 значения). Такое 48-кратное сокращение объема данных позволяет запускать модель на стандартных пользовательских видеокартах, избавляя от необходимости использовать ресурсы крупных дата-центров.

Процесс генерации начинается со случайного шума в латентном пространстве — своего рода сжатого и размытого холста, заполненного статическими помехами.

Этап 3: Итеративное шумоподавление

На основном этапе в работу вступает архитектура U-Net — нейронная сеть, изначально созданная для сегментации медицинских изображений, которая выполняет итеративное шумоподавление, обычно занимающее от 20 до 50 циклов обработки.

На каждом этапе обработки нейросеть U-Net получает следующие данные:

- Текущее зашумленное латентное представление

- Текстовый эмбеддинг CLIP (ваш промпт в закодированном виде)

- Временная метка, определяющая текущий шаг процесса

Нейросеть оценивает уровень шума в текущем кадре и последовательно удаляет его расчетную часть: если на первых этапах закладываются композиция и основные формы, то на заключительных — прорабатываются мельчайшие текстуры и детали.

Текстовые эмбеддинги направляют процесс генерации через механизмы перекрестного внимания, благодаря которым нейросеть фокусируется на релевантных частях вашего запроса и точно определяет, какие детали необходимо добавить или исключить на каждом участке изображения.

Шаг 4: Декодирование и финальное восстановление пикселей

По завершении процесса денойзинга декодер — вариационный автоэнкодер (VAE) — развертывает сжатое латентное представление до полного разрешения, восстанавливая в процессе апсэмплинга все мелкие детали, утраченные при первоначальном сжатии.

CFG (Guidance Scale): ключевой параметр, определяющий точность интерпретации вашего промпта

При использовании Stable Diffusion вы наверняка сталкивались с параметром CFG (Guidance Scale), который определяет степень соответствия результата вашему текстовому запросу. И хотя большинство пользователей оставляют стандартное значение 7 согласно рекомендациям в руководствах, понимание механики этого инструмента позволит вам гораздо эффективнее управлять процессом генерации и добиваться желаемого результата.

Параметр CFG (Classifier Free Guidance) отвечает за точность следования текстовому запросу, при этом на каждом этапе удаления шума модель фактически выполняет двойной цикл вычислений:

- На основе вашего промпта: система анализирует текст, чтобы определить, какими именно характеристиками должно обладать изображение согласно вашему описанию.

- Без использования промпта: выполняется оценка того, какой вид приняло бы стандартное «усредненное» изображение в данных условиях.

Итоговый результат строится на усилении различий между этими предсказаниями, а повышение значений CFG позволяет точнее направлять процесс генерации в соответствии с концепциями вашего промпта.

Однако здесь существует определенный компромисс:

- Низкий CFG (1–5): обеспечивает максимальную творческую свободу, однако результат может не в полной мере соответствовать деталям вашего запроса.

- Средний CFG (7–12): оптимальный диапазон, позволяющий достичь наилучшего баланса между креативностью и точностью исполнения.

- Высокий CFG (15+): гарантирует строгое следование промпту, но повышает риск избыточной насыщенности и появления визуальных артефактов.

Сравнение ведущих инструментов: DALL-E, Midjourney и Stable Diffusion

Хотя сегодня все ведущие ИИ-генераторы изображений базируются на диффузионных моделях, подходы к их архитектуре и технической реализации существенно различаются.

DALL-E 3 (OpenAI)

Благодаря прямой интеграции с ChatGPT, нейросеть GPT 4 автоматически расширяет и детализирует вводимые промпты перед началом генерации, что позволяет DALL-E создавать впечатляющие визуализации даже на основе самых лаконичных запросов. Подобный подход делает инструмент максимально удобным для рядовых пользователей, хотя профессионалам может недоставать гибкости в управлении точностью исполнения команд. Отдельного внимания заслуживает высокое качество рендеринга текста на изображениях — область, которая исторически считалась слабым местом большинства ИИ-генераторов.

Midjourney

Модель Midjourney ориентирована на эстетическое совершенство, а не на буквальную точность, что позволяет создавать изображения с особой художественной и кинематографической ценностью, зачастую превосходящие аналоги по визуальной привлекательности. Несмотря на необычный интерфейс на базе Discord, сервис сформировал вокруг себя сильное сообщество, хотя в вопросах технических характеристик проект остается менее прозрачным, чем решения конкурентов.

Stable Diffusion

Это решение с открытым исходным кодом, которое можно развернуть локально для полной прозрачности работы и внесения любых необходимых изменений. Гибкость системы способствовала созданию масштабной экосистемы дообученных моделей, расширений и LoRA (адаптаций низкого ранга для внедрения узких концепций). Данный вариант станет лучшим выбором при необходимости максимального контроля, соблюдения приватности или обучения собственных моделей, несмотря на более высокий порог входа по сравнению с аналогами.

Adobe Firefly

Благодаря обучению на базе Adobe Stock, материалах с открытой лицензией и объектах общественного достояния, решение гарантирует юридическую чистоту и идеально подходит для коммерческих проектов. Глубокая интеграция с Photoshop и Illustrator дополняется осознанно сдержанным подходом к генерации, что исключает появление спорного или провокационного контента и обеспечивает профессиональный результат.

Больше, чем просто генерация

Генерация изображений по тексту — это лишь начало, ведь современные системы обладают целым рядом дополнительных возможностей, заслуживающих детального изучения.

Преобразование изображения в изображение (img2img)

Процесс начинается не с чистого шума, а с обработки существующего изображения, при этом параметр «интенсивность денойзинга» (denoising strength) определяет степень его трансформации. Выбирая низкие значения, вы добьетесь мягкой стилизации, а высокие показатели позволят полностью переосмыслить визуальный ряд, сохранив лишь общую структуру исходного кадра.

Инпейнтинг и аутпейнтинг

Функция Inpainting позволяет пересоздавать фрагменты в выделенных областях, не затрагивая остальную часть кадра, что идеально подходит для удаления лишних объектов или замены элементов, в то время как Outpainting расширяет границы изображения, достраивая сцену и создавая визуально целостное продолжение сюжета.

ControlNet

ControlNet привносит в процесс генерации возможность структурного управления, позволяя задавать точное расположение объектов с помощью карт границ, глубины, скелетов поз или масок сегментации. Это решение незаменимо для создания визуально согласованных персонажей и обеспечения прецизионного пространственного контроля, которого невозможно добиться одними лишь текстовыми описаниями.

Технологии LoRA и DreamBooth

Если вам необходимо научить ИИ создавать изображения конкретных людей, продуктов или стилей, отсутствующих в исходной базе, воспользуйтесь технологиями LoRA (Low Rank Adaptation) и DreamBooth. Эти инструменты позволяют дообучать модели на небольших пользовательских сетах — зачастую достаточно всего 20–30 примеров, чтобы получить нейросеть, способную мгновенно воспроизводить нужный визуальный образ по вашему запросу.

Актуальные ограничения и причины их возникновения

Понимание характерных ограничений в работе ИИ-генераторов изображений позволяет эффективно их обходить, добиваясь стабильно высокого качества.

Печально известная проблема прорисовки рук

Широко известная проблема некорректной визуализации рук с лишними или сросшимися пальцами и нарушенной анатомией представляет собой не просто программный баг, а глубокий фундаментальный вызов для современных ИИ-генераторов.

Поскольку в обучающих данных руки представлены в самых разнообразных ракурсах и часто бывают перекрыты другими объектами, а их размер в масштабе кадра невелик, нейросеть уделяет им меньше «внимания» при обучении. Статистические закономерности формирования анатомически верного изображения кистей рук усваиваются гораздо сложнее, чем работа с более стабильными чертами вроде лиц, и хотя современные модели демонстрируют заметный прогресс, эта проблема все еще остается актуальной.

Отрисовка текста

До появления DALL-E 3 создание читаемого текста на изображениях было практически невыполнимой задачей, поскольку нейросети, понимая семантический смысл слов, зачастую не справлялись с их визуальным воплощением и типографикой. Несмотря на значительный прогресс DALL-E 3 в этой области, безупречная проработка сложных текстовых макетов по-прежнему остается серьезным вызовом для всех современных платформ.

Стилистическое единство и согласованность изображений

Поскольку каждая генерация начинается с уникального случайного шума, добиться стабильного воспроизведения персонажей или сцен крайне сложно. Даже такие инструменты, как фиксация сида (seed locking), использование референсов или персональных LoRA-моделей, не обеспечивают стопроцентного результата, что ограничивает возможности применения ИИ в таких сферах, как создание комиксов или разработка фирменных персонажей.

Пространственное мышление

Запросы со сложной композицией, такие как «красный шар слева от синего куба, находящегося за зеленой пирамидой», зачастую приводят к некорректной визуализации: хотя нейросети успешно распознают отдельные объекты, выстраивание точных пространственных связей между множеством элементов всё еще остается для них серьезным вызовом.

Вопросы авторского права

Именно на этом этапе возникают наиболее сложные вопросы правового и этического характера.

Обучающие данные

Большинство современных моделей ИИ обучаются на миллиардах интернет-изображений, собранных зачастую без согласия авторов, что привело к многочисленным судебным искам о нарушении авторских прав. В условиях текущих разбирательств правовой статус подобных практик остается неопределенным, а само законодательное поле в этой сфере еще только формируется.

Права собственности на созданный контент

Согласно позиции Бюро по авторским правам США, изображения, созданные исключительно нейросетями, не подлежат защите, так как авторство предполагает участие человека, однако наличие «значительного творческого вклада» со стороны пользователя может стать основанием для признания прав. На данный момент четкие критерии такого участия еще не определены и остаются предметом активных судебных разбирательств.

Не менее важно учитывать и условия использования сервиса: несмотря на то что большинство коммерческих платформ передают права на созданный контент пользователям, мы рекомендуем внимательно изучать все юридические тонкости применительно к вашим конкретным задачам.

Практические рекомендации для достижения лучших результатов

Понимание технических основ генерации помогает эффективнее формулировать запросы и достигать желаемого результата — разберем подробнее принципы, которые действительно работают:

Ключевые принципы и понятия

Текстовый энкодер распределяет приоритеты в зависимости от порядка слов, поэтому такие формулировки, как «Закат, драматичное освещение, горный пейзаж» и «Пейзаж с горами на закате», дают разный результат. Чтобы добиться нужного эффекта, старайтесь указывать наиболее значимые элементы в самом начале промпта.

Используйте понятные нейросети образы и концепции

Поскольку модели обучаются на массивах данных, использование в промптах имен художников, стилей или характеристик фототехники (например, «снято на Kodak Portra 400») активирует визуальные паттерны гораздо эффективнее, чем абстрактные описания. Так, профессиональный термин «освещение в стиле Рембрандта» позволяет добиться более точного и предсказуемого результата, чем простое упоминание «драматичного бокового света».

Совершенствуйте результат через итерации, а не стремитесь к идеалу сразу

Создание идеального изображения редко ограничивается одной попыткой: генерируйте различные варианты, выявляйте лучшие решения и планомерно совершенствуйте свои промпты. Чтобы детально проработать отдельные аспекты при сохранении общей композиции, используйте функцию img2img на базе наиболее удачных генераций.

Использование негативных промптов

Отрицательные промпты позволяют исключить нежелательные элементы — такие как размытость, искажения, лишние пальцы или водяные знаки — за счет снижения их влияния в процессе денойзинга. Формирование качественной библиотеки таких исключений помогает эффективно предотвращать типичные ошибки генерации и значительно повышает детализацию итогового изображения.

Будущее технологий

Индустрия развивается стремительно, и сегодня можно выделить несколько ключевых направлений, за которыми стоит следить особенно внимательно:

- Генерация видео: такие решения, как Sora и Runway Gen 3, успешно адаптируют диффузионные модели для видеопроизводства, благодаря чему высококачественное создание видео по текстовому описанию становится реальностью.

- 3D-моделирование: инструменты для преобразования текста и изображений в 3D-объекты стремительно совершенствуются, открывая новые возможности для разработки игр, промышленной визуализации и VR-индустрии.

- Генерация в реальном времени: оптимизация алгоритмов позволяет достичь интерактивной скорости работы, при которой в ряде систем создание полноценного изображения занимает менее секунды.

- Улучшенная консистентность: новые архитектуры эффективно решают проблему сохранения единства персонажей и сцен, что позволяет полноценно использовать ИИ в производстве анимации и комиксов.

Часто задаваемые вопросы

Сколько времени занимает генерация изображений?

Если облачные сервисы обычно генерируют изображения в течение 10–30 секунд, то локальный запуск Stable Diffusion на современных видеокартах уровня RTX 3060 и выше позволяет сократить это время до 2–5 секунд для формата 512×512, хотя работа с высоким разрешением или увеличенным числом шагов потребует пропорционально больше ресурсов.

Копируют ли ИИ-генераторы готовые изображения?

Нейросети не копируют исходные изображения, а анализируют статистические закономерности, хотя в некоторых случаях они способны частично «запоминать» наиболее известные работы. Именно возможность воспроизведения уникального стиля конкретных авторов по текстовому запросу приводит к созданию визуально схожих работ, что и вызывает активные споры о соблюдении авторских прав.

Почему нейросетям так сложно дается визуализация рук?

В обучающих данных руки представлены под множеством ракурсов и в различных положениях, а их малый масштаб на изображениях в полный рост часто приводит к недостаточной детализации при обучении. Из-за высокой вариативности нейросети сложнее выявить четкие статистические закономерности, поэтому, несмотря на технологический прогресс, точная визуализация рук остается одной из наиболее сложных задач для ИИ.

Можно ли использовать созданные ИИ изображения в коммерческих целях?

Условия использования зависят от выбранной платформы и вашей юрисдикции: хотя большинство коммерческих сервисов предоставляют соответствующие права в рамках своих правил, в ряде стран, включая США, созданный исключительно ИИ контент может не подлежать защите авторским правом. В то же время Adobe Firefly был специально спроектирован для коммерческих целей и обучен исключительно на лицензионных материалах, что обеспечивает юридическую чистоту результатов.

В чем заключаются основные отличия диффузионных моделей от сетей GAN?

В то время как архитектура GAN основана на противостоянии генератора и дискриминатора, диффузионные модели работают по принципу обращения процесса постепенного зашумления данных. Сегодня именно диффузия занимает доминирующее положение в индустрии благодаря стабильности при обучении, высокому разнообразию генерируемого контента и более точному следованию заданным промптам.

Подведем итоги

ИИ-генераторы изображений представляют собой не магию, а сложные диффузионные модели, которые шаг за шагом преобразуют текст в визуальный ряд посредством управляемого шумоподавления. Эти продвинутые системы объединяют в себе глубокое понимание естественного языка, анализ визуальных паттернов и итеративное уточнение, что позволяет создавать качественные изображения на основе любых текстовых описаний.

Ваш запрос обрабатывается текстовыми энкодерами, обученными на сотнях миллионов пар изображений и описаний, что запускает процесс устранения шума в сжатом латентном пространстве с последующим декодированием в полное разрешение. Понимание принципов работы этого алгоритма даже на базовом уровне позволит вам значительно эффективнее взаимодействовать с инструментами ИИ и добиваться лучших результатов.

Ввод текстового запроса — это не просто описание желаемого результата, а передача управляющих сигналов сложному математическому алгоритму. Интерпретируя ваш язык, нейросеть пошагово устраняет визуальный шум на основе изученных паттернов, воссоздавая детализированное изображение буквально с нуля.

Понимание принципов работы ИИ не просто удовлетворяет любопытство, но и помогает эффективнее составлять промпты, формировать реалистичные ожидания и подбирать подходящие инструменты для конкретных задач. В условиях стремительной эволюции технологий эти базовые знания станут надежным фундаментом, который позволит вам быстро адаптироваться к любым изменениям в индустрии.