Полная история ИИ-арта: от AARON до Midjourney (1973–2025)

Последнее обновление: 2026-01-22 18:07:34

Как искусственный интеллект прошёл путь от академической диковинки к художественной революции — и почему это важно

Этот гид проводит вас по истории ИИ-арта — от ранних правил‑ориентированных систем до современных диффузионных моделей, показывая, как каждый технологический прорыв менял возможности художников.

Когда робот продал картину почти за полмиллиона долларов

В октябре 2018 года на нью-йоркском аукционе Christie's произошло событие без прецедента. Портрет — слегка размытый, с отсылками к европейской живописи XVIII века — ушёл с молотка за $432 500. Покупатель? Анонимный коллекционер. Продавец? Французский арт-коллектив Obvious. Художник? Алгоритм.

«Портрет Эдмона де Белами» был создан не руками художника. Его сгенерировала генеративно-состязательная сеть (GAN), обученная на 15 000 исторических портретов. А подпись в углу — не имя автора, а математическая формула: «min max Ex[log(D(x))] + Ez[log(1 D(G(z)))]».

Мир искусства раскололся. Одни назвали это переломным моментом. Другие — трюком или даже скандалом, особенно когда выяснилось, что коллектив использовал open source‑код без должного указания авторства оригинального разработчика, Робби Баррата. Но вне зависимости от споров стало ясно одно: искусство, созданное ИИ, заявило о себе — и загнать этого джинна обратно в бутылку уже было невозможно.

Но вот что понимают не все: аукцион 2018 года вовсе не стал началом истории ИИ-арта. Даже близко. На самом деле всё началось на 45 лет раньше — в университетской компьютерной лаборатории — с британского художника, которому в какой-то момент стало тесно в рамках обычной кисти.

Краткая хронология:

1960‑е: первые эксперименты с компьютерным и алгоритмическим искусством закладывают основу будущего ИИ‑арта

1973: Гарольд Коэн начинает работу над AARON

2015: DeepDream и первые алгоритмы переноса стиля становятся вирусными

2014–2018: GANs выводят реализм изображений на новый уровень; ИИ-арт выходит в галереи и на аукционы

2021: CLIP открывает понимание связи текста и изображений

2022: диффузионные модели и Midjourney / DALL·E / Stable Diffusion выводят ИИ-арт в мейнстрим

2023–2025: Обострение дискуссий об авторском праве, согласии на использование датасетов, инструментах подтверждения происхождения и регулировании ИИ-арта

Случайный первопроходец: как художник создал первого ИИ‑художника

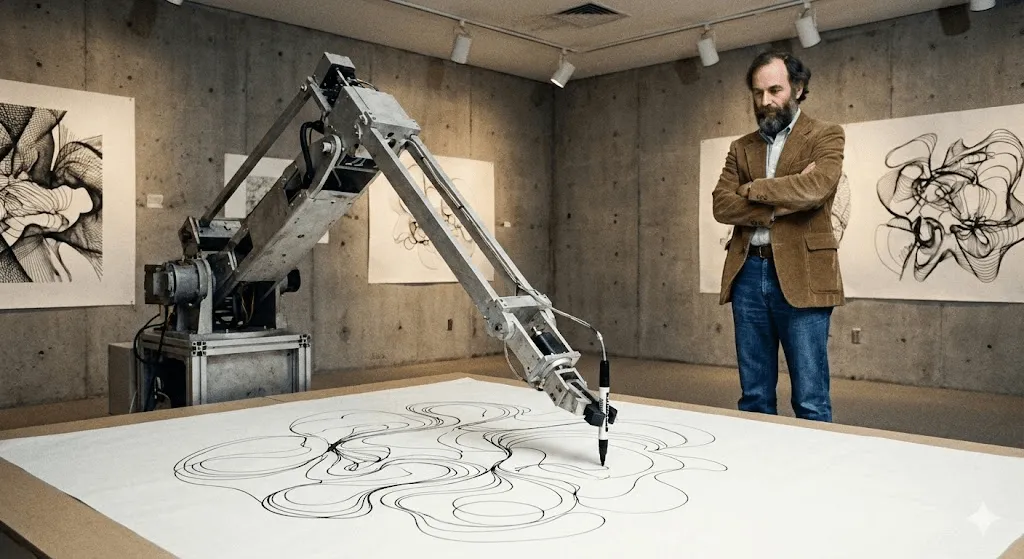

Гарольд Коэн и AARON (1973–2016)

В 1968 году Гарольд Коэн был на пике карьеры. Он представлял Великобританию на Венецианской биеннале, его абстрактные работы выставлялись в авторитетных галереях. Но его не покидало чувство внутреннего беспокойства. Как он позже вспоминал: «Возможно, за пределами моей мастерской происходит нечто более интересное, чем внутри неё».

Коэн преподавал в Калифорнийском университете в Сан-Диего, когда впервые столкнулся с компьютерами. Не как с инструментом для оцифровки уже готовых работ, а как с чем-то принципиально новым: может ли компьютер сам создавать искусство? Не воспроизводить, не копировать, а по‑настоящему творить?

Так появился AARON — название отсылает в том числе к Аарону, брату Моисея из книги Исход. Когда Коэн впервые продемонстрировал систему в UC Berkeley в 1974 году, AARON умел создавать лишь абстрактные узоры. Но именно здесь и заключалась революция: он не просто исполнял заранее заданные инструкции. Коэн заложил в него правила композиции, замкнутости и формы — художественные принципы, которыми сам руководствовался как живописец, — и в рамках этих правил AARON принимал собственные решения.

Представьте это так: Коэн научил AARON грамматике визуального языка, а дальше AARON сам «писал» свои предложения.

К 1980‑м AARON уже создавал узнаваемые образы: человеческие фигуры, растения, интерьерные сцены. Коэн «выпускал» систему в физический мир с помощью роботизированной руки для рисования (созданной вместе с коллегами в университетских исследовательских лабораториях, где он изучал, как код может буквально «рисовать»), и та выводила сложные, детализированные рисунки. Каждый — уникальный. Каждый — сразу узнаваемый как стиль AARON, но при этом неповторимый.

Самое поразительное в том, что Коэн никогда не мог до конца предсказать, что создаст AARON. Он обнаружил, что некоторые программные инструкции порождают формы, о существовании которых он даже не подозревал. Машина открывала ему возможности внутри его собственной художественной системы — те, которых он сам не замечал.

AARON развивался более 40 лет. Версия 2001 года уже создавала насыщенные цветом сцены с фигурами и растениями. Версия 2007 года («Gijon») генерировала пейзажи, напоминающие джунгли. Когда Коэн умер в 2016 году, он оставил после себя не только тысячи работ, но и фундаментальный вопрос: если AARON удивлял собственного создателя неожиданными композициями, можно ли считать его творческим?

Крупнейшие институции, включая музей Уитни, выставляли работы и документацию, связанные с AARON, подчёркивая их значение для истории цифрового искусства. Работы AARON можно увидеть и сегодня — система продолжает генерировать изображения, хотя всё, что было создано после смерти Коэна, остаётся предметом споров и часто считается неаутентичным.

До AARON: генеративное искусство и первые компьютерные эксперименты (1960‑е)

Задолго до современных моделей художники уже использовали алгоритмы для создания визуальных форм. Компьютерные плоттерные рисунки и основанное на правилах «генеративное искусство» 1960-х заложили ключевую идею, которая до сих пор определяет ИИ-арт: художник проектирует систему, а система сама порождает вариации, выходящие за пределы ручного повторения.

Тихие десятилетия: ИИ‑арт до хайпа (1980‑е–2000‑е)

Пока Коэн работал над AARON, другие художники тоже экспериментировали с вычислительным творчеством — правда, за пределами академической среды это почти не привлекало внимания.

Karl Sims — пожалуй, самое узнаваемое имя этого периода, по крайней мере в кругах цифрового искусства. В 1980‑х он работал в MIT Media Lab, а позже — в Thinking Machines (компании, занимавшейся суперкомпьютерами). Sims создавал 3D‑анимации с помощью «искусственной эволюции»: генерировал случайные трёхмерные формы, позволял им «мутировать», отбирал самые интересные и повторял процесс снова и снова. По сути, это естественный отбор для цифровых существ.

Его работы «Panspermia» (1991) и «Liquid Selves» (1992) получили главные награды на Ars Electronica — одном из самых престижных фестивалей цифрового искусства. Если вы когда‑нибудь видели завораживающие органические 3D‑анимации, которые не похожи ни на что в природе, но при этом кажутся живыми, — именно эту эстетику впервые сформировал Симс.

Scott Draves пошёл другим путём, создав «Electric Sheep» (1999). Формально это скринсейвер — да, те самые, — но скринсейвер, который обучается. Он работает распределённо на тысячах компьютеров и генерирует эволюционирующие фрактальные анимации, называемые «овцами». Зрители голосуют за понравившиеся образы, и система «размножает» именно эти паттерны. Проект, кстати, жив до сих пор: зайдите на electricsheep.org и посмотрите сами.

В этот период широко закрепился термин «генеративное искусство». Художники писали код, задавали правила и параметры, а затем позволяли алгоритмам создавать работы в этих рамках. В 2001 году появился Processing — язык программирования, созданный специально для художников, — и он сделал такой подход гораздо более доступным.

Но вот в чём дело: для большинства людей всё это тогда не ощущалось как «ИИ». Да, это были впечатляющие цифровые арт‑проекты, но в них не видели интеллекта. Они не понимали, что создают. Они просто следовали заданным правилам — пусть даже очень сложным.

Но всё вот-вот должно было измениться.

Глубинное обучение меняет всё (2012–2015)

В начале 2010‑х произошло фундаментальное изменение. Сошлись сразу три фактора:

Сначала GPU (графические процессоры) стали достаточно мощными, чтобы обучать огромные нейронные сети. Ирония в том, что прорывы в ИИ стали возможны благодаря чипам, изначально созданным для видеоигр.

Во‑вторых, стали доступны большие датасеты. ImageNet, запущенный в 2009 году, включал миллионы размеченных изображений. Нейросети наконец получили достаточно примеров, чтобы по‑настоящему учиться и находить закономерности.

В‑третьих, алгоритмы глубокого обучения сделали огромный рывок. В 2012 году модели deep learning резко улучшили показатели распознавания изображений (во многом благодаря ImageNet), показав, что нейронные сети способны масштабно изучать визуальные паттерны и уверенно превосходить классические подходы компьютерного зрения. Стало очевидно: если сделать нейросети достаточно глубокими (с множеством слоёв), дать им много данных и вычислительных ресурсов, они начинают демонстрировать поведение, которое выглядит по‑настоящему разумным.

Для искусства это имело по‑настоящему глубокие последствия.

Феномен Deep Dream (2015)

В июне 2015 года инженер Google Александр Мордвинцев опубликовал нечто странное. Он исследовал, как нейронные сети распознают объекты на изображениях. И задался вопросом: если сеть обучена находить собак, что будет, если запустить процесс в обратную сторону — и попросить её усиливать все «собачьи» паттерны, которые она видит на картинке?

Результаты выглядели трипово. Психоделично. Почти галлюциногенно. Стоило «скормить» системе фото облаков — и нейросеть начинала повсюду видеть морды собак, глаза и архитектурные формы, усиливая их до сюрреалистических пейзажей. Художественное сообщество было в восторге.

Google назвала эту технологию DeepDream (официально — «Inceptionism»). Уже через несколько недель художники начали собирать целые галереи работ в стиле DeepDream. У него быстро сформировалась собственная эстетика: изображения, покрытые глазами и закрученными органическими узорами. Даже сегодня картинку DeepDream узнаёшь с первого взгляда.

Культурная значимость была не только в визуальной стороне. Главное — в осознании: вот как нейросеть видит мир. Она видит не то, что видим мы. Она улавливает паттерны, корреляции, статистические зависимости. И когда эти паттерны становятся видимыми, они выглядят как лихорадочные сны.

Это было безумно странно. И людям это понравилось.

Перенос стиля: нейросети как художники (2015–2016)

Примерно в то же время исследователи научились использовать нейросети для «переноса стиля» — когда художественный стиль одного изображения применяется к другому. Хотите увидеть свою фотографию в эстетике «Звёздной ночи» Ван Гога? Пара секунд — и готово.

Научная статья была сложной для восприятия (Gatys et al., 2015), но приложения на её основе начали появляться одно за другим. В 2016 году Prisma стала вирусным хитом. И внезапно любой владелец смартфона смог создавать «искусство», визуально напоминающее работы великих художников.

Критики отмечали, что это не создание нового искусства, а алгоритмическая имитация. Но эксперимент показал главное: нейросети уже способны достаточно хорошо понимать художественный стиль, чтобы воспроизводить его. И вот это было по-настоящему новым.

GANs: технология, совершившая прорыв (2014–2020)

Для художников GAN оказались важны тем, что сделали «стиль» обучаемым на данных: стало возможно исследовать целые визуальные миры, не прописывая вручную каждое правило.

Как работают GAN (без математики)

В 2014 году Иэн Гудфеллоу, тогда аспирант Монреальского университета, представил Generative Adversarial Networks в научной статье, которая впоследствии стала одной из самых цитируемых в машинном обучении. Ян Лекун, один из основателей deep learning, назвал GAN «самой интересной идеей в машинном обучении за последние 10 лет».

Суть идеи проста: представьте, что две нейросети играют друг против друга.

Сеть 1 (генератор): Пытается создавать фейковые изображения, которые выглядят как настоящие.

Сеть 2 (дискриминатор): пытается отличить сгенерированные изображения от настоящих.

Сначала Генератор работает ужасно — на выходе просто случайный шум. Дискриминатор без труда распознаёт подделки. Но в этом и заключается хитрость: Генератор учится на своих ошибках. Он подстраивается, чтобы обмануть Дискриминатор. Дискриминатор, в свою очередь, становится точнее. Генератор снова адаптируется. И так — снова и снова, тысячи итераций подряд.

Со временем Генератор становится настолько сильным, что даже Дискриминатор уже не может уверенно отличить подделку от оригинала. В этот момент нейросеть оказывается способной создавать убедительные изображения с нуля.

Ключевой прорыв: GAN не требуют размеченных человеком данных для каждого возможного результата. Они учатся улавливать базовое статистическое распределение данных, на которых обучаются — будь то лица, пейзажи или что угодно — и затем способны создавать бесконечное количество вариаций.

От странных лиц к убедительному искусству (2015–2018)

Первые результаты GAN выглядели… скажем так, «экспериментально». Если вы помните те жуткие ИИ‑лица примерно 2015 года — искажённые, пугающие образы из самой глубины зловещей долины, — то это и были ранние GAN. Исследователи публиковали их как proof of concept, а интернет мгновенно превратил их в мемы.

Но технологии развивались стремительно. Уже к 2017 году Progressive GAN от NVIDIA научился генерировать лица в разрешении 1024×1024, практически неотличимые от фотографий. А в 2018-м StyleGAN поднял планку ещё выше — увеличил качество и дал контроль над отдельными параметрами изображения.

Художники начали экспериментировать. Немецкий художник Mario Klingemann создал инсталляцию «Memories of Passersby I» (2018) — два экрана с бесконечным потоком сгенерированных портретов. Они проплывают, как воспоминания, и ни один не повторяется. Работа была продана на аукционе Sotheby’s за £40,000.

Helena Sarin пошла другим путём: она обучала GAN не на фотографиях, а на собственных рисунках. Это позволило сохранить авторский контроль, одновременно используя генеративную силу ИИ. Серия «AI Candy Store» отличается узнаваемой, явно ИИ-эстетикой, в которую органично вплетён её личный стиль.

Robbie Barrat, тогда ещё старшеклассник, обучал GAN на классическом искусстве и открыто выкладывал код на GitHub. (Именно этот код позже использовала группа Obvious для продажи на аукционе Christie’s, что вызвало споры об авторстве и художественном вкладе.)

Следующий Рембрандт (2016)

До громкого аукциона Obvious был проект «The Next Rembrandt» (2016) — маркетинговая инициатива банка ING и нескольких нидерландских институций. Они оцифровали 346 картин Рембрандта, обучили алгоритм распознавать особенности его стиля и сгенерировали «новый» портрет в духе мастера.

Формально это был не GAN, но идея была схожей: способен ли ИИ создавать работы в стиле конкретного художника? Проект получил широкое освещение в СМИ. Критики признавали техническое достижение, но спорили, можно ли считать это искусством или лишь изощрённым пастишем.

Он поставил вопросы, с которыми мы до сих пор не можем окончательно разобраться: является ли обучение на работах конкретного художника уважительным оммажем или вычислительным присвоением? И где проходит граница между вдохновением и воровством?

Взрыв популярности: как ИИ-арт вышел в мейнстрим (2022–настоящее время)

CLIP: обучение ИИ пониманию текста и изображений (2021)

Следующий прорыв произошёл в январе 2021 года благодаря OpenAI — это был CLIP (Contrastive Language Image Pre-training). Технические детали довольно сложны, но эффект оказался предельно понятным: CLIP научился понимать связь между текстом и изображениями.

Ранним системам требовались размеченные данные: «это кот», «это собака». CLIP обучался на 400 миллионах пар «изображение–текст», собранных из интернета. Модель усвоила, что определённые слова регулярно связаны с конкретными визуальными признаками. В результате появилось общее «пространство», в котором текст и изображения можно сопоставлять.

Почему это стало переломным моментом: объединив CLIP с генеративной моделью, мы впервые получили возможность создавать изображения по текстовому описанию. Достаточно написать «астронавт верхом на лошади» — и система понимает, как это должно выглядеть.

Художники быстро приспособили CLIP под свои рабочие процессы. Комбинируя его с GANs или другими генераторами, они могли направлять создание изображений с помощью языка. Это было топорно, но работало.

Революция 2022 года: DALL·E 2, Midjourney и Stable Diffusion

А потом наступил 2022‑й — и всё изменилось в одночасье.

DALL·E 2 (OpenAI, апрель 2022) объединил CLIP и диффузионные модели (о них — чуть ниже), чтобы создавать качественные, цельные изображения по текстовому описанию. Ранний доступ получили избранные художники и исследователи. Лист ожидания быстро превысил миллион человек. Изображения, которыми делилась OpenAI, поражали креативностью, связностью и часто — настоящей красотой.

Midjourney (Midjourney Inc., июль 2022) пошёл другим путём: ставка на сообщество, работа через Discord и фокус на визуальной эстетике. У сервиса быстро сформировался узнаваемый стиль — живописный, драматичный, часто фантазийный. Художники потянулись к нему, а Discord-сервер превратился в одно из самых активных творческих сообществ в сети.

Stable Diffusion (Stability AI, август 2022) стал переломным моментом с точки зрения доступности. В отличие от DALL·E 2 (только веб-версия и ограниченный доступ) или Midjourney (по подписке), Stable Diffusion был с открытым исходным кодом. Любой мог скачать его, запустить локально и доработать под свои задачи.

За считанные месяцы выросла целая экосистема: веб‑интерфейсы, мобильные приложения, плагины для Photoshop, сотни кастомных моделей под конкретные стили. Масштаб был беспрецедентным.

К концу 2022 года соцсети были буквально наводнены ИИ-артом. «Промпт-инжиниринг» превратился в отдельный навык: люди обменивались советами, как получать более впечатляющие результаты. Параллельно не утихали споры — одни видели в этом демократизацию искусства, другие говорили о его разрушении.

Диффузионные модели: технология, стоящая за магией

Так что же такое диффузионная модель? По своей сути она вдохновлена физикой — тем, как частицы постепенно распространяются в среде.

Процесс обучения:

- Возьмите реальное изображение

- Постепенно добавляйте к нему шум, пока оно не превратится в полностью случайную «статику» (прямой диффузионный процесс)

- Обучите нейросеть обращать этот процесс вспять — удалять шум и восстанавливать изображение (обратная диффузия)

Процесс генерации: всё начинается с чистого шума. Затем запускается обратный процесс диффузии, который шаг за шагом превращает хаос в цельное изображение. Текстовое условие (через CLIP) направляет модель, определяя, какой именно образ должен появиться.

Почему для этой задачи победили диффузионные модели: они стабильнее, проще в обучении и гораздо точнее следуют текстовым подсказкам. GAN по‑прежнему используются в отдельных сценариях, но именно диффузионные модели стали главной движущей силой взрывного роста ИИ-арта в 2022 году.

Небольшое техническое отступление: ключевой работой стала статья «Denoising Diffusion Probabilistic Models» (Ho et al., 2020), хотя фундамент для неё был заложен ещё в исследованиях Sohl-Dickstein и соавторов в 2015 году. Если хочется действительно разобраться в теме, начинать стоит именно с этих публикаций — но сразу предупреждаем: математики там будет немало.

В цифрах

- К началу 2023 года эти инструменты уже использовали миллионы людей, а изображения, созданные ИИ, буквально заполонили социальные сети.

- DALL·E: более 3 миллионов пользователей (лист ожидания снят)

- Stable Diffusion: точное число невозможно подсчитать (open source, децентрализованное распространение), но статистика GitHub указывает на миллионы

Люди сгенерировали сотни миллионов изображений с помощью ИИ. Появились целые компании, построившие бизнес на ИИ-арте. Фотостоки в спешке пересматривали правила и лицензии. А традиционные художники с тревогой наблюдали, как «AI artist» превратился в полноценную профессию.

Другая сторона ИИ-арта: академические применения

Пока все обсуждали генераторы изображений по тексту, исследователи незаметно использовали ИИ, чтобы кардинально изменить подходы к изучению истории искусства. Эта часть истории ИИ-арта остается в тени, хотя с академической точки зрения она, возможно, даже важнее.

Компьютерное зрение для атрибуции и анализа

Искусствоведы всегда сталкивались с проблемой атрибуции — кто именно создал то или иное произведение. Теперь на помощь приходят нейросети.

Rutgers Art & AI Lab (под руководством Ahmed Elgammal) разработала системы, которые анализируют мазки кисти, композицию и стилевые маркеры, чтобы атрибутировать работы конкретным художникам или выявлять подделки. В 2017 году в контролируемых тестах эти системы с точностью более 90% определяли авторов неатрибутированных произведений.

Реконструкция утраченных произведений: нейросети, обученные на сохранившихся работах художника, способны создавать правдоподобные версии утраченных или повреждённых фрагментов. Самый известный пример — проект с ИИ, который экстраполировал картину Рембрандта «Ночной дозор», повреждённую в 1715 году, и показал, как могли выглядеть утраченные части. (Хотя искусствоведы спорят о точности, это скорее обоснованная гипотеза, а не восстановление в строгом смысле.)

Свитки из Геркуланума: В 2023 году учёные применили машинное обучение, чтобы прочитать тексты древних свитков, обугленных при извержении Везувия в 79 году н. э. Эти свитки невозможно развернуть из‑за хрупкости, но КТ‑сканирование в сочетании с обученными нейросетями позволило выявить следы чернил. Так ИИ впервые за почти 2000 лет дал возможность прочитать утраченные античные тексты. (Источник: Nature, 2023)

Музеи и ИИ

Крупные институции экспериментировали с ИИ самыми разными и впечатляющими способами:

Метрополитен-музей экспериментировал с визуализацией коллекции с помощью ИИ, переводя огромные музейные архивы в «латентное пространство», чтобы находить неожиданные связи между объектами.: Проект был реализован в сотрудничестве Метрополитен-музея, MIT и художника Рефика Анадола. Нейросети обучили на всей коллекции музея (более 375 000 произведений), после чего визуализировали «латентное пространство» — концептуальную область между разными типами объектов. Это позволило выявить неожиданные переклички: например, древний персидский кувшин и ваза XIX века могли оказаться концептуально ближе друг к другу, чем когда-либо предполагали кураторы.

ИИ-эксперименты MoMA: проект Refik Anadol «Unsupervised» (2022–2023) использовал машинное обучение, обученное на коллекции MoMA, чтобы создавать текучие, почти сновидческие проекции в вестибюле музея. Реакция арт-сообщества оказалась неоднозначной: одни сочли это эффектным трюком, другие — новым способом переживания и осмысления музейных архивов.

Проект Transparent AI Мюнхенского университета LMU: Под руководством профессора Хубертуса Коле команда разрабатывает ИИ-инструменты для истории искусства, которые умеют объяснять ход своих рассуждений. Обычные нейросети — это «чёрные ящики»: вы получаете ответ, но не понимаете, почему именно такой. Этот проект делает решения ИИ прозрачными, что критически важно для их признания в академической среде. Модели обучают находить визуальные сходства между произведениями искусства и пояснять, какие именно признаки повлияли на их выводы.

Эти инструменты не создают новые произведения, но меняют сам подход к изучению истории искусства. И, возможно, их влияние окажется куда более долговечным, чем у любой сгенерированной картинки.

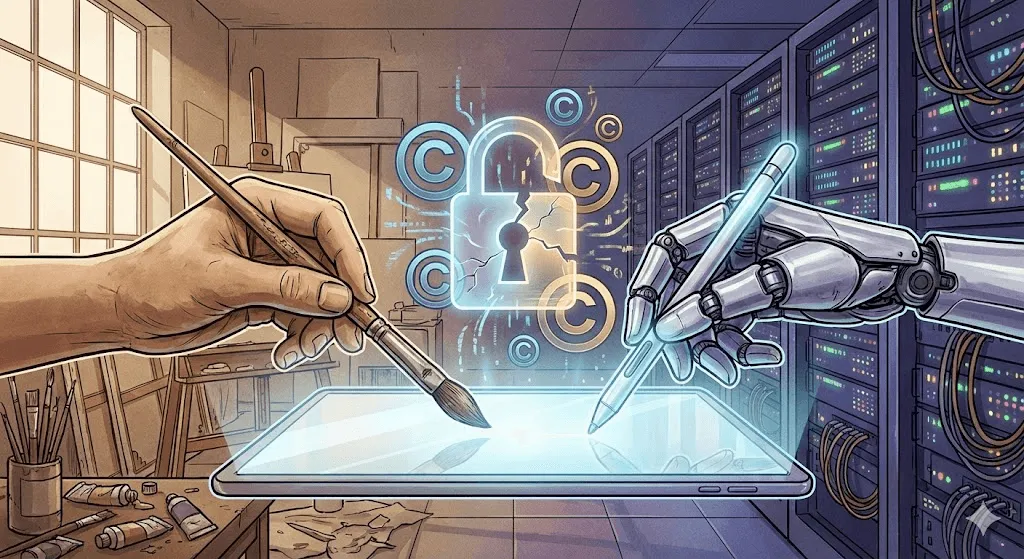

Споры и дискуссии: авторское право, этика и будущее творчества

Вот здесь начинается самое горячее. Технологические прорывы впечатляют, но этическая сторона вопроса — мягко говоря, непростая.

Битва за авторские права

Ключевая проблема: модели ИИ для создания искусства обучаются на миллиардах изображений, собранных в интернете. Многие из них защищены авторским правом. У художников не спрашивали разрешения. Им не платили вознаграждение. И теперь системы, обученные на их работах, способны за считаные секунды создавать изображения «в их стиле».

Поданы крупные судебные иски:

Getty Images vs. Stability AI (январь 2023 года): Getty утверждает, что Stability использовала миллионы их изображений для обучения Stable Diffusion. В качестве доказательства приводится то, что на некоторых сгенерированных изображениях видны фрагменты водяных знаков Getty, наглядно указывающие на источник.

Коллективный иск художников против Midjourney, Stable Diffusion и DeviantArt (январь 2023): инициирован художницами Сарой Андерсен, Келли Маккернан и Карлой Ортис. В иске утверждается масштабное нарушение авторских прав. По состоянию на конец 2024 года дело всё ещё рассматривается, а юридическое сообщество не пришло к единому мнению о возможном исходе.

Юридический вопрос сводится к следующему: является ли обучение на изображениях, защищённых авторским правом, добросовестным использованием (как обучение студента на примерах существующего искусства) или же это нарушение — использование чужих работ без разрешения в коммерческих целях?

Суды ещё не вынесли решения. От этого зависит будущее всей индустрии.

Ответ художников: дать отпор

Художники не ждут судов — они разрабатывают технические контрмеры.

Glaze (University of Chicago, 2023): программное обеспечение, которое незаметно для человека изменяет цифровые изображения, но при этом «отравляет» обучение ИИ. Если модель обучается на изображениях, обработанных Glaze, её результаты искажаются. Это своего рода активный водяной знак — не для идентификации, а для разрушения обучения.

Nightshade (также U of Chicago, 2023): Более агрессивен, чем Glaze. Он не просто защищает изображение с Nightshade — он активно ухудшает общую работу модели. Загрузите достаточно изображений с Nightshade, помеченных как «dog», но на которых на самом деле кошки, — и со временем модель начинает путаться в том, как выглядят собаки.

Эти инструменты вызывают споры. Исследователи ИИ называют их вредным саботажем. Художники — самообороной. И у тех и у других есть свои аргументы.

Инициатива «Do Not Train»: Художники и профильные организации предложили использовать метаданные, помечающие работы как закрытые для обучения ИИ. Некоторые платформы (DeviantArt, Shutterstock) внедрили системы отказа (opt-out). Но реального контроля почти нет. Компании, разрабатывающие ИИ, могут просто игнорировать такие теги — и многие так и делают.

Дискуссия о творчестве

Глубже споров об авторском праве лежит философский вопрос: можно ли считать искусством то, что создаёт ИИ?

Аргументы «против»:

- Лишено человеческого намерения и эмоциональной глубины

- Создаётся путём переработки уже существующих работ, а не рождения по-настоящему нового

- Не требует мастерства — достаточно просто ввести промпт

- Подрывает то, что делает искусство ценным: человеческое творчество и личное усилие

Аргументы «за»:

- Инструменты не обесценивают искусство (камеры не «убили» живопись)

- Промпт-инжиниринг и кураторство — это навыки

- Человек направляет ИИ и принимает творческие решения

- Открывает новые формы самовыражения, ранее невозможные

Моё мнение: это спор не о том. Примерно как обсуждать, является ли фотография искусством в 1850 году. Конечно, ИИ может создавать искусство — мы это уже видим. Гораздо важнее другие вопросы: какие отношения мы хотим выстроить между человеческим и машинным творчеством? Кто от этого выигрывает? Что мы теряем? И что приобретаем?

Реальность вытеснения рабочих мест

Это не абстракция. Реальные люди теряют работу.

Опрос, проведённый Concept Art Association в 2023 году, показал:

- 73% концепт‑художников сообщили о сокращении возможностей трудоустройства

- 62% потеряли фриланс‑проекты из‑за ИИ

- Позиции начального уровня исчезают быстрее всего

Компании все чаще используют ИИ для предварительной проработки идей, сторибордов и фоновых концептов — той самой работы, которая раньше доставалась художникам на старте карьеры. Защитники технологии говорят, что это не отличается от того, как цифровые инструменты в свое время вытеснили традиционные техники. Но скорость изменений беспрецедентна, и неудивительно, что затронутые художники испытывают сильное недовольство.

С другой стороны, появляются новые роли: арт-директора по ИИ, prompt-инженеры, специалисты по гибридным рабочим процессам «человек + ИИ». Заменят ли они утраченные профессии в соотношении один к одному — пока открытый вопрос.

Проблема предвзятости

Модели ИИ‑арта наследуют предвзятости своих обучающих данных. Попросите «CEO» — и получите белых мужчин. «Медсестра» — почти наверняка женщина. «Красивый человек» — с сильным перекосом в сторону молодых, белых и соответствующих общепринятым стандартам привлекательности лиц.

В 2024 году Google попыталась решить эту проблему в Gemini, повысив разнообразие в исторических изображениях, но перегнула палку. Модель начала искажать исторические реалии, что вызвало резонансную дискуссию о том, как ИИ должен балансировать между исторической точностью, репрезентацией и требованиями безопасности. Ситуация наглядно показала, насколько сложно ответственно настраивать такие системы — вплоть до абсурдных примеров с «расово разнообразной» европейской знатью XVIII века. Google принесла извинения и временно отключила функцию. Инцидент стал еще одним напоминанием о хрупком балансе между точностью истории и стремлением к инклюзивности.

Предвзятость — это не только про демографию. ИИ-арт тяготеет к определённой эстетике: вылизанной, коммерческой, «красивой» по общепринятым меркам. Экспериментальное, авангардное, намеренно неказистое искусство в результатах встречается реже — потому что в обучающих данных его меньше и оно хуже «вознаграждается». В этом смысле ИИ может быть художественно консервативным, даже оставаясь технически радикальным.

Где мы сейчас (2024–2025)

Современный ландшафт

К концу 2024 — началу 2025 года сфера ИИ-арта заметно повзрослела, но по‑прежнему остаётся динамичной и противоречивой:

DALL E 3 (интегрированный с ChatGPT Plus) радикально улучшил понимание промптов. Теперь можно вести диалог о желаемом результате — ИИ гораздо лучше улавливает контекст и нюансы.

Midjourney V6 поднял визуальное качество на новый уровень: улучшилась прорисовка текста (пусть и не идеальная), а стили стали заметно более управляемыми.

Stable Diffusion XL и далее продолжает развиваться: сообщество open source создаёт специализированные модели — от аниме и фотореализма до отдельных художественных стилей.

Adobe Firefly — это пример «ответственного ИИ»: модель обучена исключительно на изображениях Adobe Stock и контенте из общественного достояния, а коммерческое лицензирование встроено по умолчанию. По возможностям она уступает Stable Diffusion, зато считается более безопасной с юридической точки зрения для коммерческого использования.

Генерация видео: следующий рубеж

Генерация изображений по тексту была лишь началом. В 2024 году произошёл серьёзный прорыв в создании видео с помощью ИИ:

Runway Gen 2 и Pika умеют создавать короткие видеоклипы по текстовому описанию или изображению. Качество пока нестабильное: объекты могут неестественно трансформироваться, физика иногда «ломается», но с каждым месяцем модели заметно прогрессируют.

OpenAI's Sora (анонсирована в феврале 2024 года, с ограниченным доступом) показала фотореалистичное, цельное видео длительностью до минуты. Демонстрационные ролики произвели ошеломляющее впечатление. Одновременно они напугали многих: стало ясно, что дипфейки были проблемой ещё до того, как ИИ научился убедительно создавать видео по текстовому описанию.

3D и не только

ИИ‑арт выходит за рамки 2D‑изображений:

Point E и Shap E (OpenAI) создают 3D‑модели по текстовым запросам. Качество пока ограничено, но направление развития очевидно.

Технология NeRF (Neural Radiance Fields) позволяет создавать 3D‑сцены на основе 2D‑изображений — с потенциалом применения от кинопроизводства и геймдева до архитектурной визуализации.

Музыка, текст и мультимодальность

Генерация музыки с помощью ИИ (Suno, Udio) к 2024 году вышла на уровень «вполне достойно». ИИ не заменил музыкантов, но заметно упростил и удешевил создание функциональной фоновой музыки.

Мультимодальные модели (GPT‑4 с поддержкой зрения, Gemini) умеют анализировать изображения, создавать по ним тексты, а затем генерировать новые изображения на основе этого описания. Граница между текстовым ИИ и визуальным ИИ стремительно стирается.

Что дальше: прогнозы и новые возможности

Ближайшая перспектива (2025–2027)

Вероятно:

- Генерация видео выходит на уровень массового, практического использования

- Стабильная генерация персонажей (один и тот же человек в серии изображений) становится надежной

- Появляется больше правовой ясности в вопросах авторского права (во многом под давлением судебных разбирательств)

- Консолидация рынка: небольшие игроки поглощаются или уходят с рынка

- Усиливается негативная реакция — некоторые платформы и клиенты запрещают использование ИИ-арта

Возможно:

- Генерация видео в реальном времени во время видеозвонков и стриминга

- ИИ-арт становится стандартным инструментом в профессиональных креативных процессах

- Появление категории «сертифицированное искусство, созданное человеком» как премиального сегмента

- Крупная музейная выставка, посвящённая истории ИИ-арта (а не отдельным инсталляциям)

Среднесрочный период (2027–2030)

Предположительно, но правдоподобно:

- Единые модели объединяют генерацию текста, изображений, видео, 3D и аудио

- Персональные ИИ-модели, обученные на индивидуальных художественных стилях, становятся повседневной практикой

- Интеграция AR/VR позволяет переносить ИИ-арт в физическое пространство через гарнитуры

- Правовые рамки формируют (скорее всего, неоднозначные) компромиссы вокруг использования данных для обучения

- Появляются новые художественные направления, изначально рожденные ИИ, а не адаптации до-ИИшных стилей

В долгосрочной перспективе: ключевые вопросы

Превзойдёт ли ИИ человеческое творчество? Неправильный вопрос — это разные вещи.

Станут ли художники‑люди не нужны? Вряд ли. По мере того как ИИ заливает рынок простым контентом, спрос на по‑настоящему «человеческие» работы может даже вырасти.

Кому принадлежит искусство, созданное ИИ? Этот вопрос до сих пор оспаривается в судах. По действующему законодательству США такие работы не имеют владельца (нет человеческого авторства), но это, вероятно, изменится.

Как справедливо вознаграждать художников, чьи работы используются для обучения ИИ? Это вопрос на миллиарды долларов — без преувеличений. Среди возможных решений называют лицензионные отчисления, микроплатежи за каждое использование, обязательные лицензии по аналогии с музыкальной индустрией. Но ни одна из этих моделей пока не работает в реальном масштабе.

Нужны ли зоны без ИИ? Одни считают, что в отдельных сферах — детские книги, мемориальные проекты, юридические доказательства — право на создание должно оставаться за человеком. Другие называют это луддизмом. Споры продолжаются.

Уроки истории

Если оглянуться на более чем 50 лет истории ИИ-искусства, можно заметить несколько устойчивых закономерностей:

- Инструменты становятся массовыми. AARON требовал навыков программирования. GAN — понимания машинного обучения. Современным инструментам достаточно аккаунта в Discord. Каждое новое поколение — доступнее предыдущего.

- Первоначальный хайп почти всегда опережает реальность. Каждый прорыв сопровождается заявлениями «искусство умерло». Но искусство не умирает — оно меняется.

- Правовые и этические нормы не успевают за технологиями. Мы до сих пор спорим об авторских правах на технологии, запущенные три года назад. Закон движется медленно, технологии — нет.

- Страхи о вытеснении профессий нередко обоснованы, но неполны. Да, одни роли исчезают. Зато появляются новые. Переходный период болезненный — особенно для тех, кто оказался внутри него.

- Искусство выживает. Фотография не убила живопись. Цифровые инструменты не уничтожили традиционные медиа. ИИ не убьёт человеческое творчество. Но он изменит то, как, зачем и что мы создаём.

Заключение: пишем следующую главу

От кропотливого программирования Гарольда Коэна в 1973 году до миллионов людей, создающих изображения за считаные секунды сегодня, история ИИ-арта — это прежде всего история эволюции отношений между человеческим творчеством и вычислительными возможностями.

Вопросы, которые стоят перед нами сегодня, — уже не столько технические: технологии работают и развиваются стремительно. Это вопросы о человеке.

- Как сделать так, чтобы ИИ усиливал человеческое творчество, а не вытеснял его?

- Как справедливо вознаграждать художников, благодаря чьим работам ИИ вообще стал возможен?

- Кто получит доступ и право участвовать в этом новом креативном пространстве?

- Какие аспекты творчества мы хотим сохранить исключительно за человеком?

- Как сохранить художественные профессии и источники дохода в период технологических перемен?

На эти вопросы нет простых ответов. Они требуют диалога и компромисса между художниками, технологами, компаниями, законодателями и обществом. История ИИ-арта ещё не завершена — мы прямо сейчас переживаем одну из самых определяющих её глав.

Ясно одно: игнорирование ИИ не заставит его исчезнуть — как и попытки делать вид, что он не поднимает реальных проблем. Движение вперёд требует вовлечённости: честного разговора о рисках, открытости новым возможностям и настойчивого стремления к справедливости.

Вопрос о том, способен ли ИИ «по‑настоящему» быть креативным, возможно, просто поставлен неверно. Креативность — не бинарное качество, которое либо есть, либо нет. Она существует в спектрах, в сотрудничестве, в неожиданных сочетаниях. Если первые 50 лет ИИ‑арта чему‑то нас и научили, так это тому, что творчество куда шире и страннее, чем мы предполагали. А люди — к лучшему или к худшему — явно намерены делиться им.

Следующая глава пишется прямо сейчас. Внесите свой осмысленный вклад.