AI 아트의 완전한 역사: AARON에서 Midjourney까지 (1973–2025)

마지막 업데이트: 2026-01-22 18:07:34

[Context: AI art history 1973–2025: AARON to GANs, Midjourney & diffusion models timeline.] [Reference terms: AI 아트, AI 아트 역사, AI 미술 연대기, 1973–2025 AI 아트, AARON 컴퓨터 아트, 생성 예술, 알고리즘 아트, 컴퓨터 생성 예술, AI 이미지 생성기, 텍스트-투-이미지, 확산 모델, 디퓨전 모델, GAN 아트, 생성적 적대 신경망, 미드저니, AI로 그림 만들기, AI로 이미지 만들기, 크리스티 경매 AI 작품, 에드몽 드 벨라미 초상, AI 일러스트 생성]

인공지능이 학문적 호기심에서 예술적 혁명으로 진화한 과정과, 그 변화가 왜 중요한지

이 가이드는 규칙 기반 시스템의 초기 실험부터 오늘날의 확산 모델까지 AI 아트의 흐름을 짚어보며, 각 기술적 도약이 예술가들의 표현 방식을 어떻게 바꿔왔는지 한눈에 보여줍니다.

로봇이 만든 작품이 50만 달러 가까이에 팔린 순간

2018년 10월, 뉴욕 크리스티 경매에서 전례 없는 일이 벌어졌습니다. 18세기 유럽 회화를 연상시키는 다소 흐릿한 초상화 한 점이 43만 2,500달러에 낙찰된 것입니다. 구매자는 익명의 컬렉터, 판매자는 프랑스 아트 콜렉티브 Obvious. 그리고 작가는 다름 아닌 알고리즘이었습니다.

‘에드몽 드 벨라미의 초상(Portrait of Edmond de Belamy)’은 인간의 손으로 그려진 작품이 아닙니다. 15,000점의 역사적 초상화를 학습한 생성적 적대 신경망(GAN)이 만들어낸 이미지입니다. 캔버스 한쪽에 적힌 서명 역시 화가의 이름이 아니라, “min max Ex[log(D(x))] + Ez[log(1 D(G(z)))]”라는 수학 공식이었습니다.

미술계는 둘로 갈렸다. 어떤 이들은 역사적 전환점이라 불렀고, 다른 이들은 단순한 눈속임이자 심지어 스캔들이라고까지 했다. 특히 그 집단이 원 개발자인 Robbie Barrat에 대한 적절한 출처 표기 없이 오픈 소스 코드를 사용했다는 사실이 드러나면서 논란은 더욱 커졌다. 그러나 논쟁의 여지와는 별개로 한 가지는 분명해졌다. AI가 만들어낸 예술은 이미 현실이 되었고, 이 흐름은 더 이상 되돌릴 수 없다는 점이다.

하지만 많은 사람들이 놓치는 사실이 있습니다. 2018년의 그 경매가 AI 아트의 시작은 아니라는 점이죠. 사실은 전혀 아닙니다. 이야기는 그보다 45년 전, 한 대학의 컴퓨터 실험실에서 시작됩니다. 붓만으로는 더 이상 만족할 수 없다고 느낀 한 영국인 화가가 있었거든요.

한눈에 보는 타임라인:

1960년대: 초기 컴퓨터/알고리즘 아트 실험이 토대를 마련

1973: 해럴드 코언, AARON 개발 시작

2015: DeepDream + 초기 스타일 트랜스퍼가 바이럴 확산

2014–2018: GANs가 이미지 사실성을 비약적으로 끌어올리며, AI 아트가 갤러리와 경매 시장에 본격 진입

2021: CLIP, 텍스트와 이미지를 함께 이해하는 시대를 열다

2022: 확산 모델과 Midjourney / DALL·E / Stable Diffusion의 등장으로 AI 아트가 대중화

2023–2025: 저작권, 데이터셋 동의, 출처 추적 도구를 둘러싼 규제 논쟁이 본격화

우연한 개척자: 한 화가가 최초의 AI 아티스트를 탄생시키다

해럴드 코헨과 AARON (1973–2016)

1968년, 해럴드 코헨은 예술가로서 정점에 서 있었습니다. 베니스 비엔날레에서 영국을 대표했고, 그의 추상 회화는 유수의 갤러리에 전시되고 있었죠. 하지만 마음 한켠에는 늘 질문이 남아 있었습니다. 훗날 그는 이렇게 회상합니다. “어쩌면 내 작업실 안보다 밖에서 더 흥미로운 일들이 벌어지고 있는지도 모른다.”

코헨은 UC San Diego에서 가르치던 시절, 컴퓨터와 마주했다. 그것은 기존 작업을 디지털화하는 도구가 아니라, 더 근본적인 질문이었다—컴퓨터 그 자체가 예술을 만들 수 있을까? 재현도 복사도 아닌, 진정으로 창작할 수 있을까?

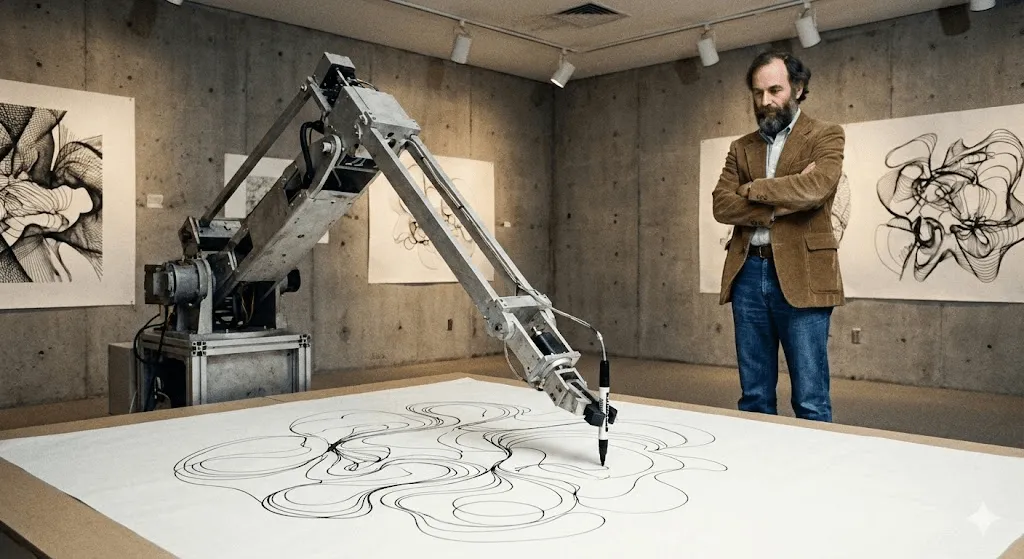

그 결과 탄생한 것이 AARON입니다. 이름은 성경 출애굽기에 등장하는 모세의 형 아론에서 일부를 따왔죠. 1974년, 코헨이 UC Berkeley에서 처음 시연했을 당시 AARON은 추상적인 패턴만 생성할 수 있었습니다. 하지만 진짜 혁신은 다른 데 있었습니다. AARON은 미리 정해진 지시를 그대로 실행하는 프로그램이 아니었습니다. 코헨은 화가로서 이해하고 있던 구도, 폐합, 형태에 대한 개념을 규칙으로 설계했고, 그 틀 안에서 AARON은 스스로 판단하고 선택하며 이미지를 만들어냈습니다.

이렇게 생각해보면 이해가 쉽습니다. 코언은 AARON에게 시각 언어의 문법을 가르쳤고, 실제 문장은 AARON이 스스로 써 내려갔습니다.

1980년대에 이르러 AARON은 인간 형상, 식물, 실내 장면처럼 알아볼 수 있는 이미지를 만들어내기 시작했다. 코헨은 코드가 물리적 세계에서 어떻게 ‘그릴’ 수 있는지를 탐구하며(대학 연구 환경에서 협업자들과 함께 제작한) 로봇 드로잉 암에 AARON을 맡겼고, 그 결과 정교한 드로잉들이 탄생했다. 작품 하나하나가 모두 유일했다. 모두가 분명히 AARON의 스타일이었지만, 동시에 모두 서로 달랐다.

흥미로운 점은 코헨조차도 AARON이 무엇을 만들어낼지 끝까지 예측할 수 없었다는 사실입니다. 그가 작성한 일부 프로그램 지시는 스스로도 상상하지 못했던 형태를 만들어냈죠. 기계는 그가 구축한 예술적 시스템 안에 숨어 있던, 아직 보지 못했던 가능성을 오히려 그에게 보여주고 있었습니다.

AARON은 40년이 넘는 시간 동안 계속 진화했다. 2001년 버전에서는 인물과 식물이 어우러진 다채로운 장면을 만들어냈고, 2007년 버전인 ‘Gijon’은 정글을 연상시키는 풍경을 그려냈다. 2016년 Cohen이 세상을 떠났을 때, 그가 남긴 것은 수천 점의 작품만이 아니었다. AARON이 창작자를 놀라게 할 만큼 새로운 구성을 만들어냈다면, 그것을 과연 ‘창의적’이라고 부를 수 있을까라는 근본적인 질문이었다.

휘트니 미술관을 비롯한 주요 미술 기관들은 코언의 AARON 관련 작품과 아카이브를 전시하며, 디지털 아트 역사에서 그 중요성을 분명히 해왔습니다. 오늘날에도 AARON은 여전히 이미지를 생성하고 있지만, 코언 사후에 만들어진 결과물은 진정성을 둘러싼 논란의 대상이 되고 있습니다.

AARON 이전: 생성 예술과 초기 컴퓨터 실험(1960년대)

오늘날의 모델이 등장하기 훨씬 전부터, 예술가들은 이미 알고리즘을 활용해 시각적 형태를 만들어왔습니다. 1960년대의 초기 컴퓨터 플로터 드로잉과 규칙 기반 ‘생성 예술’은 AI 아트를 관통하는 핵심 개념을 제시했습니다. 즉, 예술가는 하나의 시스템을 설계하고, 그 시스템이 인간의 손작업을 넘어서는 다양한 변주를 스스로 만들어낸다는 아이디어입니다.

조용한 시대: 붐 이전의 AI 아트 (1980s–2000s)

코언이 AARON을 개발하던 동안에도 다른 예술가들은 계산적 창의성을 탐구하고 있었지만, 학계 밖에서는 거의 주목받지 못했다.

Karl Sims는 이 시기를 대표하는 인물 중 하나로, 디지털 아트 분야에서는 비교적 잘 알려진 이름입니다. 1980년대 MIT 미디어랩에서 활동했고, 이후에는 초고성능 컴퓨터 기업인 Thinking Machines에서 일했습니다. Sims는 ‘인공 진화(artificial evolution)’라는 개념을 활용해 3D 애니메이션을 제작했습니다. 무작위로 생성한 3D 형태를 변이시키고, 그중 흥미로운 결과를 선택해 다시 반복하는 방식이었죠. 말하자면 디지털 생명체에 자연선택을 적용한 실험이었습니다.

그의 1991년 작품 "Panspermia"와 1992년작 "Liquid Selves"는 권위 있는 디지털 아트 페스티벌인 Ars Electronica에서 최고상을 수상했다. 자연에 존재하는 것 같지는 않지만 묘하게 살아 있는 듯한, 최면을 거는 유기적 3D 애니메이션을 본 적이 있다면—그 미학을 개척한 인물이 바로 Sims다.

Scott Draves는 1999년 「Electric Sheep」로 완전히 다른 접근을 선보였습니다. 스크린세이버—기억하시죠?—이긴 한데, 그냥 반복 재생이 아니라 스스로 학습하는 시스템이었죠. 수천 대의 컴퓨터에 분산되어 실행되며 ‘sheep’이라 불리는 프랙털 애니메이션을 끊임없이 생성합니다. 시청자들이 마음에 드는 패턴에 투표하면, 시스템은 그 취향을 반영해 비슷한 패턴을 ‘번식’시키죠. 놀랍게도 이 프로젝트는 지금도 계속 운영 중입니다. electricsheep.org에 접속하면 직접 감상할 수 있어요.

이 시기부터 ‘생성 예술(generative art)’이라는 개념이 본격적으로 자리 잡기 시작했습니다. 작가들은 규칙과 파라미터를 코드로 정의하고, 그 범위 안에서 알고리즘이 작품을 만들어내도록 했죠. 2001년에는 예술가를 위해 설계된 프로그래밍 언어인 Processing이 등장하며, 이러한 작업 방식이 훨씬 더 많은 사람들에게 열리게 됩니다.

하지만 중요한 점이 하나 있습니다. 대부분의 사람들에게 이 모든 것은 ‘AI’처럼 느껴지지 않았다는 거죠. 멋진 디지털 아트 프로젝트이긴 했지만, 지능적으로 보이진 않았습니다. 자신이 무엇을 만들고 있는지 이해하지 못했고, 아무리 복잡해도 정해진 규칙을 따를 뿐이었습니다.

하지만 곧 상황은 완전히 달라지기 시작합니다.

딥러닝, 모든 것을 바꾸다 (2012–2015)

2010년대 초, 판을 바꾸는 전환이 일어났다. 세 가지 흐름이 한데 모였다:

먼저 GPU(그래픽 처리 장치)가 대규모 신경망을 학습시킬 만큼 충분히 강력해졌습니다. 아이러니하게도, 원래 게임을 위해 설계된 칩이 AI 혁신의 발판이 된 셈이죠.

두 번째 변화는 대규모 데이터셋의 등장입니다. 2009년에 공개된 ImageNet은 수백만 장의 라벨링된 이미지를 담고 있습니다. 이로써 신경망이 패턴을 실제로 학습할 수 있을 만큼 충분한 예제가 한꺼번에 확보됐습니다.

셋째, 딥러닝 알고리즘이 비약적으로 발전했습니다. 2012년, 딥러닝 모델은 이미지 인식 벤치마크(특히 ImageNet)를 통해 기존 컴퓨터 비전 기법을 압도하는 성과를 내며 큰 주목을 받았습니다. 이는 신경망이 대규모로 시각적 패턴을 학습할 수 있다는 신호였죠. 연구자들은 깨달았습니다. 신경망을 충분히 깊게 쌓고(다층 구조), 방대한 데이터와 강력한 연산 자원을 제공하면, 놀랄 만큼 ‘지능적으로’ 보이는 결과를 만들어낸다는 사실을요.

예술에 있어 그 영향은 실로 거대했습니다.

딥드림의 등장 (2015)

2015년 6월, 구글 엔지니어 Alexander Mordvintsev가 꽤 기묘한 결과물을 공개했습니다. 그는 신경망이 사물을 어떻게 인식하는지 시각화하는 작업을 하고 있었죠. 발상은 이랬습니다. 개를 인식하도록 학습된 네트워크가 있다면, 과정을 거꾸로 돌려 이미지 속에서 ‘개처럼 보이는 패턴’을 발견할 때마다 그것을 더 강하게 증폭시키면 어떤 일이 벌어질까?

결과는 말 그대로 트리피했다. 사이키델릭했고, 환각적이기까지 했다. 구름 사진을 입력하면 네트워크는 곳곳에서 개의 얼굴, 눈, 건축적 요소를 포착해내고, 이를 증폭시켜 초현실적인 풍경으로 바꿔놓았다. 예술계는 순식간에 열광했다.

구글은 이 기술을 DeepDream(공식 명칭은 ‘Inceptionism’)이라 불렀습니다. 공개된 지 불과 몇 주 만에 아티스트들은 DeepDream 작품으로 가득한 갤러리를 만들기 시작했죠. 눈이 빽빽하게 겹쳐지고 유기적인 패턴이 소용돌이치는 이미지—그 자체로 하나의 독립적인 미학이 되었습니다. 지금도 DeepDream 이미지는 한눈에 알아볼 수 있을 정도로 강렬한 정체성을 갖고 있습니다.

문화적으로 의미 있었던 이유는 단지 비주얼 때문만은 아니었습니다. 핵심은 이 깨달음이었죠. 신경망이 세상을 바라볼 때 보는 것이 바로 이것이라는 점입니다. 그것은 우리가 보는 방식이 아닙니다. 패턴과 상관관계, 통계적 관계를 봅니다. 그리고 그 패턴들이 시각화되면, 마치 열에 들뜬 꿈처럼 보이게 됩니다.

묘하게 낯설었고, 사람들은 열광했다.

스타일 트랜스퍼: 예술가가 된 신경망 (2015–2016)

비슷한 시기, 연구자들은 신경망으로 ‘스타일 트랜스퍼’를 구현하는 방법을 찾아냈습니다. 한 이미지의 화풍을 다른 이미지에 입히는 기술이죠. 내 사진을 반 고흐의 「별이 빛나는 밤」 스타일로 보고 싶다고요? 몇 초면 충분했습니다.

기술 논문 자체는 꽤 난해했지만(Gatys et al., 2015), 이를 구현한 앱들은 빠르게 확산됐다. 2016년에는 Prisma가 바이럴 히트를 기록했고, 그 순간 스마트폰만 있으면 누구나 유명 화가의 작품처럼 보이는 ‘아트’를 만들어낼 수 있게 됐다.

비평가들은 이것이 진정한 창작이 아니라 알고리즘에 의한 모방에 불과하다고 지적했다. 하지만 신경망이 예술적 스타일을 충분히 이해하고 재현할 수 있다는 점을 보여줬다는 사실만큼은 분명히 새로운 일이었다.

GANs: 판을 바꾼 결정적 기술 (2014–2020)

예술가들에게 GAN이 중요했던 이유는 데이터로부터 ‘스타일’을 학습하게 만들어, 모든 규칙을 일일이 코딩하지 않아도 하나의 시각적 세계를 탐험할 수 있게 했기 때문이다.

수식 없이 이해하는 GAN의 작동 원리

2014년, 몬트리올 대학교 박사 과정이던 Ian Goodfellow는 이후 머신러닝 분야에서 가장 많이 인용되는 논문 중 하나가 된 연구를 통해 생성적 적대 신경망(GAN)을 소개했습니다. 딥러닝의 창시자 중 한 명인 Yann LeCun은 GAN을 두고 “지난 10년간 머신러닝에서 나온 가장 흥미로운 아이디어”라고 평가했습니다.

핵심 개념은 이렇습니다: 두 개의 신경망이 서로 게임을 하듯 맞붙는다고 상상해 보세요.

Network 1 (the Generator): 진짜처럼 보이는 가짜 이미지를 만들어내려고 합니다.

네트워크 2(판별자, Discriminator): 생성된 이미지가 가짜인지, 실제 이미지인지 구분하려고 학습합니다.

처음에 Generator는 무작위 노이즈만 만들어내며 형편없습니다. Discriminator는 가짜를 손쉽게 가려내죠. 하지만 핵심은 여기 있습니다. Generator는 실패에서 배우며, Discriminator를 속이도록 스스로를 조정합니다. 그러면 Discriminator는 더 정교하게 가짜를 판별하고, Generator는 다시 한 번 진화합니다. 이 공방이 수천 번 반복됩니다.

결국 생성기는 판별기조차 진짜와 가짜를 안정적으로 구분하지 못할 만큼 정교해집니다. 이 단계에 이르면, 아무것도 없는 상태에서 사실적인 이미지를 만들어내는 신경망이 완성되는 셈입니다.

결정적 전환점은 GAN이 모든 결과에 대해 인간이 라벨링한 학습 데이터를 필요로 하지 않는다는 점이었습니다. 얼굴, 풍경 등 학습한 대상의 통계적 분포 자체를 이해하고, 그 안에서 무한한 변형을 스스로 만들어낼 수 있게 된 것이죠.

기묘한 얼굴에서 완성도 높은 예술로 (2015–2018)

초기의 GAN 결과물은… 한마디로 말해 ‘실험적’이었습니다. 2015년 전후로 떠돌던, 일그러지고 섬뜩한 언캐니 밸리의 AI 생성 얼굴들을 기억하시나요? 그게 바로 초기 GAN의 모습이었죠. 연구자들은 개념 증명 차원에서 이를 공개했고, 곧바로 밈으로 퍼져 나갔습니다.

하지만 기술 발전은 매우 빨랐습니다. 2017년에는 NVIDIA의 Progressive GAN이 1024×1024 해상도의 얼굴 이미지를 사진과 구별하기 어려울 정도로 생성해냈죠. 이어 2018년 등장한 StyleGAN은 해상도를 한층 더 끌어올리는 동시에, 이미지의 다양한 요소를 세밀하게 제어할 수 있는 가능성을 열었습니다.

예술가들의 실험도 본격화됐다. 독일 출신 아티스트 Mario Klingemann은 두 개의 화면에서 끝없이 생성되는 초상화를 보여주는 설치 작품 “Memories of Passersby I”(2018)을 선보였다. 기억처럼 스쳐 지나가는 얼굴들은 단 한 번도 같은 모습으로 반복되지 않는다. 이 작품은 소더비 경매에서 £40,000에 낙찰됐다.

Helena Sarin은 다른 길을 택했습니다. 사진이 아닌 자신의 드로잉을 학습 데이터로 GANs를 훈련시킨 것이죠. 이를 통해 AI의 생성력을 활용하면서도 작가로서의 통제력을 유지할 수 있었습니다. 그녀의 “AI Candy Store” 시리즈는 한눈에 AI 작업임을 알아볼 수 있는 독특한 미감을 지니면서도, 개인적인 스타일이 자연스럽게 스며들어 있습니다.

Robbie Barrat는 당시 고등학생 신분으로 고전 미술을 학습한 GAN을 훈련하고, 그 코드를 GitHub에 공개했다. (이 코드는 이후 Obvious가 크리스티 경매에 출품한 작품에 사용되며, 저작권과 예술적 크레딧을 둘러싼 논란을 촉발했다.)

더 넥스트 렘브란트 (2016)

Obvious가 경매에서 화제를 모으기 전, 2016년에는 ING 은행과 여러 네덜란드 기관이 진행한 마케팅 프로젝트 ‘The Next Rembrandt’가 있었습니다. 이들은 렘브란트의 회화 346점을 스캔해 그의 화풍을 학습하는 알고리즘을 만들고, 이를 통해 ‘새로운’ 렘브란트 초상화를 생성했습니다.

기술적으로는 GAN이 아니었지만, 질문은 같았습니다. AI가 특정 예술가의 스타일로 창작할 수 있을까? 이 프로젝트는 언론의 집중 조명을 받았고, 평단에서는 기술적 성과라는 평가와 함께 이것이 과연 예술인지, 아니면 정교한 모방에 불과한지에 대한 논쟁이 이어졌습니다.

이때 제기된 질문은 지금까지도 이어지고 있습니다. 특정 작가의 작품을 학습하는 것은 존중의 오마주일까요, 아니면 계산된 전유일까요? 영감은 어디까지가 창작이고, 어디서부터 도용이 될까요?

폭발적 확산: AI 아트가 대중화된 순간 (2022–현재)

CLIP: 텍스트와 이미지를 이해하도록 AI를 학습시키다 (2021)

다음 결정적 전환점은 2021년 1월, OpenAI가 공개한 CLIP(Contrastive Language Image Pre training)이었습니다. 기술적인 설명은 복잡하지만, 영향은 명확했습니다. CLIP은 텍스트와 이미지 사이의 관계를 이해할 수 있었던 최초의 모델이었습니다.

기존 시스템은 “이건 고양이”, “이건 개”처럼 라벨이 붙은 데이터가 필요했습니다. 반면 CLIP은 인터넷에서 수집한 4억 개의 이미지–텍스트 쌍을 통해 학습했습니다. 어떤 단어가 어떤 시각적 특징과 함께 등장하는지를 스스로 익힌 것이죠. 그 결과, 텍스트와 이미지를 같은 기준에서 비교할 수 있는 공통된 ‘공간’이 만들어졌습니다.

왜 중요했을까? CLIP을 생성 모델과 결합하면서, 텍스트 설명만으로 이미지를 만들어낼 수 있는 시대가 열렸기 때문입니다. “말을 타는 우주비행사”라고 입력하면, 시스템이 그 장면이 어떤 모습인지 이해하고 이미지로 구현해냅니다.

아티스트들은 곧바로 CLIP을 작업 흐름에 끌어들였습니다. GAN이나 다른 생성기와 결합해, 언어로 이미지 생성을 제어할 수 있었죠. 다소 투박했지만, 충분히 가능성을 보여줬습니다.

2022년의 혁명: DALL·E 2, Midjourney, Stable Diffusion

그리고 2022년이 도래하며, 모든 것이 한순간에 달라졌습니다.

DALL E 2(OpenAI, 2022년 4월)는 CLIP과 디퓨전 모델(이에 대해서는 잠시 후 더 자세히 다룹니다)을 결합해 텍스트만으로도 완성도 높고 일관된 이미지를 생성해냈습니다. 초기에는 일부 아티스트와 연구자에게만 제한적으로 공개되었고, 대기자 명단은 순식간에 100만 명을 넘어섰습니다. OpenAI가 공개한 이미지들은 놀라울 만큼 창의적이었고, 구조적으로도 탄탄했으며, 무엇보다 아름다웠습니다.

Midjourney (Midjourney Inc., 2022년 7월)는 전혀 다른 길을 선택했습니다. 커뮤니티 중심, Discord 기반, 그리고 ‘미적 완성도’에 집중한 접근이었죠. 회화적이고 극적이며 종종 판타지적인 고유한 스타일을 빠르게 만들어냈고, 이에 수많은 아티스트들이 몰려들었습니다. Midjourney의 Discord 서버는 곧 온라인에서 가장 활발한 창작 커뮤니티 중 하나로 자리 잡았습니다.

Stable Diffusion (Stability AI, 2022년 8월)은 접근성의 판도를 바꾼 결정적 전환점이었습니다. 웹 전용의 제한적 접근 방식이었던 DALL·E 2나 구독 기반의 Midjourney와 달리, Stable Diffusion은 오픈 소스였습니다. 누구나 다운로드해 로컬에서 실행하고, 자유롭게 수정할 수 있었죠.

불과 몇 달 만에 웹 인터페이스, 모바일 앱, 포토샵 플러그인, 특정 스타일에 맞춰 학습된 수백 개의 커스텀 모델까지—하나의 거대한 생태계가 순식간에 형성되었습니다. 그 확산 속도와 규모는 전례 없는 수준이었습니다.

2022년 말, 소셜 미디어는 AI 아트로 넘쳐났다. ‘프롬프트 엔지니어링’이 하나의 역량으로 자리 잡았고, 더 나은 결과를 얻는 노하우가 활발히 공유됐다. 이것이 예술을 대중화하는 일인지, 아니면 예술을 파괴하는 일인지에 대한 논쟁도 끊이지 않았다.

확산 모델: 마법 같은 결과를 만드는 핵심 기술

그렇다면 확산 모델이란 무엇일까요? 간단히 말해, 물리학에서 영감을 받은 개념으로, 입자가 매질 안에서 서서히 퍼져 나가는 원리를 기반으로 합니다.

학습 과정:

- 실제 이미지를 준비합니다

- 노이즈를 점진적으로 추가해 완전히 무작위한 정적 상태로 만듭니다(정방향 확산, forward diffusion)

- 이 과정을 거꾸로 수행해 노이즈를 제거하도록 신경망을 학습시킵니다(역방향 확산, reverse diffusion)

생성 과정: 순수한 노이즈에서 출발해 역확산 과정을 거치며 점차 일관된 이미지로 완성됩니다. 텍스트 조건화(CLIP를 통해)가 어떤 이미지가 생성될지를 방향 잡아줍니다.

이 분야에서 확산 모델(diffusion models)이 GAN을 앞선 이유는 명확합니다. 학습이 더 안정적이고, 훈련이 수월하며, 텍스트 프롬프트를 훨씬 잘 따르기 때문이죠. GAN도 일부 용도에서는 여전히 쓰이지만, 2022년의 폭발적 확산을 주도한 것은 확산 모델이었습니다.

기술적인 참고: 핵심 논문은 Ho et al.(2020)의 「Denoising Diffusion Probabilistic Models」입니다. 다만 Sohl Dickstein et al.(2015)의 선행 연구가 중요한 토대를 마련했죠. 이 분야를 제대로 이해하고 싶다면 이 논문들이 좋은 출발점이 될 겁니다—단, 수식이 상당히 많다는 점은 각오하세요.

숫자로 살펴보기

- 2023년 초에 이르러 이러한 도구들은 수백만 명의 사용자를 확보했고, AI로 생성된 이미지가 소셜 플랫폼 전반에 빠르게 확산되기 시작했습니다.

- DALL·E: 사용자 300만 명 이상(대기자 명단 해소)

- Stable Diffusion: 오픈소스·분산형 특성상 정확한 집계는 불가하나, GitHub 통계 기준 수백만 명 규모로 추정

사람들은 수억 장의 AI 이미지를 만들어냈고, AI 아트 서비스를 내세운 비즈니스가 우후죽순처럼 등장했습니다. 스톡 이미지 사이트들은 급히 정책을 재정비해야 했고, 전통 예술가들은 ‘AI 아티스트’가 하나의 직업명이 되는 모습을 혼란스럽게 지켜볼 수밖에 없었습니다.

또 다른 AI 아트: 학술적 활용

모두가 텍스트-투-이미지 생성기에 주목하던 사이, 연구자들은 AI를 활용해 미술사 연구 자체를 근본적으로 바꾸고 있었습니다. 이 흐름은 AI 아트 역사에서 상대적으로 덜 알려져 있지만, 학문적 영향력만 놓고 보면 오히려 더 중요한 전환점이라 할 수 있습니다.

작품 귀속 및 분석을 위한 컴퓨터 비전

미술사학자들은 언제나 작품의 저자를 가려내는 문제와 싸워 왔습니다. 이제는 신경망이 그 해답을 돕고 있습니다.

Rutgers Art & AI Lab은 Ahmed Elgammal의 주도로 붓 터치, 구성 요소, 스타일적 특징을 분석해 작가를 식별하거나 위작을 판별하는 시스템을 개발했습니다. 2017년에는 통제된 실험 환경에서 작가 정보가 없는 작품의 제작자를 90% 이상의 정확도로 맞혀 주목을 받았습니다.

유실 작품의 재구성: 한 예술가의 기존 작품을 학습한 신경망은 분실되거나 훼손된 작품을 그럴듯하게 재구성해낼 수 있습니다. 가장 유명한 사례로는 1715년에 손상된 렘브란트의 「야경(The Night Watch)」을 AI로 추정 복원해, 잘려 나간 부분이 어떤 모습이었을지를 보여준 작업이 있습니다. (물론 정확성에 대해서는 미술사학자들 사이에 논쟁이 있으며, 이는 ‘복원’이라기보다 근거 있는 추정에 가깝습니다.)

헤르쿨라네움 두루마리: 2023년, 컴퓨터 과학자들은 머신러닝을 활용해 서기 79년 베수비오 화산 폭발로 탄화된 고대 두루마리의 글자를 읽어내는 데 성공했습니다. 두루마리는 너무 약해 펼칠 수 없지만, CT 스캔과 학습된 신경망을 결합해 잉크의 흔적을 감지할 수 있었죠. AI 덕분에 약 2,000년 만에 처음으로 고대 문헌의 내용을 해독할 수 있게 된 사례입니다. (출처: Nature, 2023)

미술관과 AI

세계 주요 기관들도 AI를 활용한 흥미로운 실험을 이어왔습니다:

메트로폴리탄 미술관(The Met)은 AI 기반 컬렉션 시각화를 실험하며, 방대한 미술관 아카이브를 하나의 ‘잠재 공간(latent space)’으로 매핑해 작품 간의 예상치 못한 관계를 드러냈습니다.: 메트로폴리탄 미술관, MIT, 그리고 아티스트 레픽 아나돌(Refik Anadol)의 협업으로 진행된 프로젝트입니다. 메트 소장품 전체(37만 5천 점 이상)를 학습한 신경망을 통해, 서로 다른 유형의 작품들이 개념적으로 연결되는 영역, 즉 ‘잠재 공간’을 시각화했습니다. 그 결과 고대 페르시아 주전자와 19세기 화병처럼, 인간 큐레이터조차 미처 발견하지 못했던 놀라운 연결성이 드러났습니다.

MoMA의 AI 실험: 레픽 아나돌의 <Unsupervised>(2022–2023)는 MoMA 소장 컬렉션을 학습한 머신러닝을 활용해, 미술관 로비에 흐르듯 변화하는 몽환적인 프로젝션을 구현했다. 미술계의 반응은 엇갈렸다. 일부는 보여주기식 연출이라 평가한 반면, 또 다른 이들은 미술관 아카이브를 경험하는 완전히 새로운 방식으로 받아들였다.

LMU 뮌헨의 Transparent AI 프로젝트: 후베르투스 콜레(Hubertus Kohle) 교수가 이끄는 이 연구는 판단 근거를 설명하는 미술사 AI 도구를 개발합니다. 일반적인 신경망은 ‘블랙박스’에 가깝습니다. 결과는 나오지만 왜 그런 결론에 이르렀는지는 알기 어렵죠. 이 프로젝트는 AI의 의사결정을 투명하게 만들어, 학술적 신뢰와 수용에 필수적인 조건을 충족합니다. 연구팀은 작품 간 시각적 유사성을 식별하고, 어떤 특징이 그 결론을 이끌었는지 설명할 수 있도록 모델을 훈련하고 있습니다.

이런 애플리케이션은 새로운 예술 작품을 만들어내지는 않지만, 우리가 미술사를 연구하는 방식 자체를 바꾸고 있습니다. 어쩌면 어떤 생성 이미지보다도 더 오래 지속될 변화일지도 모릅니다.

논쟁의 중심: 저작권, 윤리, 그리고 창작의 미래

바로 이 지점부터 논쟁이 본격적으로 달아오릅니다. 기술적 성취는 분명 놀랍지만, 그에 따른 윤리적 함의는 결코 단순하지 않습니다.

저작권 전쟁

핵심 쟁점은 이렇습니다. AI 아트 모델은 인터넷에서 수집한 수십억 장의 이미지로 학습됩니다. 그중 상당수는 저작권이 있는 작품이죠. 하지만 많은 아티스트들은 사전 동의를 받지 못했고, 보상도 받지 못했습니다. 그 결과, 그들의 작품을 학습한 시스템이 이제는 몇 초 만에 ‘특정 작가의 스타일’을 그대로 재현한 이미지를 만들어내고 있습니다.

주요 소송 제기:

Getty Images vs. Stability AI (2023년 1월): Getty Images는 Stable Diffusion 학습 과정에서 자사 이미지를 수백만 장 무단 수집·활용했다고 주장했습니다. 실제로 일부 생성 이미지에 Getty 워터마크의 일부가 그대로 남아 있어, 학습 데이터 출처를 직접적으로 보여주는 증거로 제시되었습니다.

아티스트 집단 소송: Midjourney, Stable Diffusion, DeviantArt 상대 (2023년 1월): 아티스트 사라 앤더슨(Sarah Andersen), 켈리 맥커넌(Kelly McKernan), 칼라 오르티즈(Karla Ortiz)가 주도한 소송으로, 대규모 저작권 침해를 주장하고 있다. 이 사건은 2024년 말 기준으로도 여전히 진행 중이며, 향후 판결에 대해서는 법조계에서도 의견이 엇갈리고 있다.

법적 쟁점은 이것입니다. 저작권이 있는 이미지를 학습에 사용하는 것이 기존 작품을 보고 배우는 학생처럼 ‘공정 이용’에 해당할까요? 아니면 상업적 이익을 위해 허락 없이 작품을 활용하는 ‘저작권 침해’일까요?

아직 법원의 판단은 나오지 않았습니다. 이 결정이 앞으로 업계 전체의 방향을 좌우하게 될 것입니다.

아티스트들의 대응: 반격

예술가들은 법원의 판단을 마냥 기다리지 않습니다. 직접 기술적 대응책을 만들어가고 있습니다.

Glaze (시카고대학교, 2023): 인간의 눈에는 거의 보이지 않게 디지털 아트를 미세하게 변형해 AI 학습을 ‘오염’시키는 소프트웨어입니다. 모델이 Glaze 처리된 이미지를 학습하면 결과물이 왜곡됩니다. 식별을 위한 워터마크가 아니라, 학습 자체를 교란하는 능동형 워터마크에 가깝습니다.

Nightshade (시카고대학교, 2023): Glaze보다 훨씬 공격적인 방식입니다. Nightshade 처리된 이미지를 보호하는 데 그치지 않고, 모델 전체의 성능 자체를 저하시킵니다. 예를 들어 고양이 이미지를 ‘dog’으로 라벨링한 Nightshade 이미지를 충분히 업로드하면, 결국 모델은 ‘개’가 무엇인지 제대로 구분하지 못하게 됩니다.

이 도구들은 논란의 중심에 있다. AI 연구자들은 이를 유해한 파괴 행위로 보고, 예술가들은 자기방어라고 말한다. 양쪽 모두 일리가 있다.

‘Do Not Train’ 제안: 예술가들과 옹호 단체들은 작품을 AI 학습에서 제외하겠다는 의미의 메타데이터 태그 도입을 제안해 왔습니다. 일부 플랫폼(DeviantArt, Shutterstock)은 옵트아웃 시스템을 도입했지만, 실제 집행은 미미한 수준입니다. AI 기업들은 이 태그를 그냥 무시할 수 있고, 실제로 그렇게 하는 경우도 많습니다.

창의성 논쟁

저작권을 넘어서는 더 근본적인 질문이 있습니다: AI가 생성한 작품은 과연 예술일까요?

해당하지 않는 주장:

- 인간 고유의 의도성과 감정적 깊이가 결여되어 있다

- 기존 작품을 재조합할 뿐, 진정으로 새로운 것을 창조하지는 못한다

- 특별한 기술이 필요 없다—누구나 프롬프트만 입력하면 된다

- 예술의 가치를 이루는 핵심인 인간의 창의성과 고투를 훼손한다

해당한다는 주장:

- 도구가 예술의 가치를 떨어뜨리지는 않습니다 (카메라가 회화를 끝내지 않았듯이)

- 프롬프트 설계와 결과 선별 자체가 하나의 창작 역량입니다

- 인간이 방향을 제시하고 선택하며, AI는 그 과정을 확장합니다

- 이전에는 불가능했던 새로운 표현 방식이 열립니다

내 생각: 이건 논점이 잘못됐어요. 1850년에 사진이 예술이냐 아니냐를 따지는 것과 다를 바 없죠. AI가 예술을 만들 수 있다는 건 이미 우리가 직접 보고 있습니다. 더 중요한 질문은 이거예요. 인간의 창의성과 기계의 창의성이 어떤 관계를 맺게 될까? 그 과정에서 누가 이득을 보고, 무엇을 잃고, 또 무엇을 얻게 될까?

일자리 대체의 현실

이건 이론적인 이야기가 아닙니다. 실제로 사람들이 일자리를 잃고 있습니다.

Concept Art Association가 2023년에 실시한 설문조사에 따르면:

- 컨셉 아티스트의 73%가 일자리 기회가 줄었다고 답했습니다

- 62%는 AI로 인해 프리랜스 작업을 잃었다고 밝혔습니다

- 엔트리급 포지션이 가장 빠른 속도로 사라지고 있습니다

기업들은 초기 콘셉트 작업, 스토리보드, 배경 디자인 등—과거에는 신입·주니어 아티스트들이 맡던 영역—에 AI를 활용하고 있다. 이를 옹호하는 이들은 디지털 도구가 전통 기법을 대체해 온 것과 다르지 않다고 말한다. 하지만 변화의 속도는 전례가 없고, 영향을 받는 아티스트들이 분노하는 것도 충분히 이해할 만하다.

한편으로는 새로운 역할들도 등장하고 있습니다. AI 아트 디렉터, 프롬프트 엔지니어, 그리고 인간과 AI의 하이브리드 작업 흐름을 설계하는 전문가들입니다. 다만 이러한 직무들이 사라진 일자리를 1:1로 대체할 수 있을지는 아직 지켜봐야 할 문제입니다.

편향 문제

AI 아트 모델은 학습 데이터에 담긴 편향을 그대로 물려받습니다. “CEO”를 요청하면 백인 남성이 나오고, “간호사”는 여성으로 생성됩니다. “아름다운 사람”을 입력하면 젊고 백인이며 전형적으로 매력적인 얼굴로 크게 치우칩니다.

Google의 Gemini는 2024년 역사 이미지의 다양성을 확대하려다 과도한 보정을 하면서 논란을 불러일으켰다. 역사적 정확성, 대표성, 안전성 사이의 균형을 모델이 어떻게 맞춰야 하는지를 두고 논쟁이 커졌고, 18세기 유럽 귀족을 인종적으로 다양하게 묘사한 결과가 문제로 지적됐다. Google은 사과와 함께 해당 기능을 일시 중단했다. 이 사건은 역사적 정확성과 대표성을 동시에 충족시키는 일이 얼마나 어려운지 여실히 보여줬다.

편향은 인구통계의 문제만이 아닙니다. AI 아트는 세련되고 상업적이며 전통적으로 ‘예쁜’ 미학에 쏠리는 경향이 있습니다. 실험적이거나 아방가르드한, 의도적으로 불편하고 못생긴 예술은 학습 데이터에서도 드물고 보상도 적기 때문에 결과물에서도 잘 나타나지 않습니다. 그런 점에서 AI는 기술적으로는 급진적일지 몰라도, 예술적으로는 오히려 보수적일 수 있습니다.

지금, 우리는 어디에 있는가 (2024–2025)

현재의 판도

2024년 말~2025년 초 현재, AI 아트 분야는 한층 성숙했지만 여전히 변화와 논쟁이 끊이지 않는 역동적인 국면에 있습니다:

DALL E 3는 ChatGPT Plus와 통합되면서 프롬프트 이해력이 크게 향상되었습니다. 이제 원하는 이미지를 대화하듯 설명하면, AI가 맥락과 뉘앙스를 훨씬 정확하게 파악합니다.

Midjourney V6는 미적 완성도를 한 단계 더 끌어올리며, 아직 완벽하진 않지만 텍스트 표현력이 개선되었고 스타일 제어도 훨씬 정교해졌습니다.

Stable Diffusion XL 그 이후도 진화를 멈추지 않고 있습니다. 오픈 소스 커뮤니티를 중심으로 애니메이션, 포토리얼리즘, 특정 예술 스타일 등 목적에 맞춘 다양한 전문 모델들이 계속해서 등장하고 있습니다.

Adobe Firefly는 Adobe Stock 이미지와 퍼블릭 도메인 콘텐츠만으로 학습한 ‘책임 있는 AI’ 접근을 대표합니다. 상업용 라이선스가 기본으로 포함되어 있어, Stable Diffusion에 비해 기능은 다소 제한적이지만 상업적 활용 측면에서는 법적 리스크가 훨씬 적습니다.

비디오 생성: 다음 프런티어

텍스트-투-이미지는 시작에 불과했습니다. 2024년에는 AI 영상 생성에서 눈에 띄는 진전이 있었습니다:

Runway Gen 2와 Pika는 텍스트나 이미지를 바탕으로 짧은 영상 클립을 생성할 수 있습니다. 다만 품질은 아직 들쭉날쭉해 사물이 부자연스럽게 변형되거나 물리 표현이 어색한 경우가 있지만, 매달 꾸준히 개선되고 있습니다.

OpenAI의 Sora(2024년 2월 공개, 제한적 출시)는 최대 1분 길이의 영상에서도 놀라울 만큼 사실적이고 일관된 결과물을 보여주었습니다. 공개된 데모 영상은 그야말로 충격적이었죠. 동시에, 텍스트만으로도 그럴듯한 영상을 만들어내는 시대가 오기 전부터 이미 딥페이크가 심각한 문제였다는 사실을 많은 사람들에게 다시 한 번 각인시켰습니다.

3D 그 이상

AI 아트는 이제 2D 이미지를 넘어 더 넓은 영역으로 확장되고 있습니다:

Point E와 Shap E(OpenAI)는 텍스트 프롬프트만으로 3D 모델을 생성합니다. 아직 완성도에는 한계가 있지만, 기술의 발전 방향은 분명합니다.

NeRF (Neural Radiance Fields) 기술은 2D 이미지로부터 사실적인 3D 장면을 생성해, 영화 제작부터 게임 개발, 건축 시각화에 이르기까지 다양한 분야에 새로운 가능성을 열어줍니다.

음악, 텍스트, 그리고 멀티모달리티

2024년을 기점으로 AI 음악 생성(Suno, Udio)은 ‘이제 꽤 쓸 만한’ 수준에 도달했습니다. 음악가를 대체하진 않았지만, 배경 음악처럼 목적이 분명한 사운드는 훨씬 빠르고 저렴하게 만들 수 있게 되었죠.

멀티모달 모델(GPT 4 with vision, Gemini)은 이미지를 분석하고 그에 대한 텍스트를 생성한 뒤, 다시 그 텍스트를 바탕으로 새로운 이미지를 만들어냅니다. 텍스트 AI와 이미지 AI의 경계가 빠르게 허물어지고 있습니다.

다음 단계: 예측과 가능성

단기 (2025–2027)

유력:

- 영상 생성 기술이 본격적으로 실사용 단계에 진입

- 여러 이미지에서 동일 인물을 일관되게 생성하는 기술이 안정화

- 진행 중인 소송을 계기로 저작권 관련 법적 기준이 점차 명확해짐

- 소규모 플레이어의 인수·퇴출로 업계 재편 가속

- AI 아트를 금지하는 플랫폼·클라이언트가 늘며 반발 심화

가능:

- 영상 통화나 라이브 스트리밍 중 실시간 비디오 생성

- 전문 크리에이티브 워크플로우에서 AI 아트가 표준 도구로 자리 잡음

- ‘certified human made’ 아트가 프리미엄 카테고리로 등장

- 단일 설치를 넘어선 AI 아트 역사 대형 미술관 전시

중기 (2027–2030)

가설적이지만 충분히 그럴듯한 내용:

- 텍스트, 이미지, 영상, 3D, 오디오 생성이 하나의 통합 모델로 묶임

- 개인의 예술 스타일을 학습한 맞춤형 AI 모델이 보편화

- AR/VR 헤드셋을 통해 물리적 공간에서도 AI 아트를 구현

- 학습 데이터에 대한 법적 기준이 마련되며(다소 복잡한 절충안이 될 가능성)

- 기존 미술의 연장이 아닌, AI에 고유한 새로운 예술 사조 등장

장기적 관점: 본질적인 질문들

AI가 인간의 창의성을 뛰어넘을까요? 질문 자체가 잘못됐습니다. 둘은 서로 다른 것입니다.

인간 예술가는 사라질까요? 그럴 가능성은 낮습니다. 오히려 AI가 손쉽게 만든 콘텐츠로 시장이 넘쳐날수록, ‘진짜 인간의 손길’이 담긴 작업에 대한 수요는 더 커질 수 있습니다.

AI가 만든 작품의 저작권은 누구에게 있을까요? 아직도 법정에서 치열하게 다투고 있습니다. 현재 미국 저작권법은 ‘인간의 저작물이 아니다’라는 이유로 소유권을 인정하지 않지만, 이 기준 역시 앞으로 바뀔 가능성이 큽니다.

AI 학습에 사용된 작품의 창작자에게 어떻게 보상을 해야 할까요? 말 그대로 수십억 달러가 걸린 핵심 질문입니다. 라이선스 비용, 사용량 기반 마이크로페이먼트, 음악 산업처럼 의무 라이선스 제도 같은 해법이 거론되지만, 아직 어느 것도 본격적으로 작동하는 단계는 아닙니다.

AI 없는 구역이 필요할까요? 일부는 아동 도서, 추모물, 법적 증거처럼 특정 영역만큼은 인간 창작자에게 맡겨야 한다고 주장합니다. 반면 이런 시각을 시대착오적인 러다이트 운동이라 보는 의견도 있죠. 논쟁은 여전히 진행 중입니다.

역사가 주는 인사이트

50년이 넘는 AI 아트의 역사를 돌아보면, 몇 가지 뚜렷한 흐름이 보입니다:

- 도구는 점점 대중화됩니다. AARON은 프로그래밍 지식이 필요했고, GAN은 머신러닝 이해가 필수였습니다. 지금의 도구는 디스코드 계정만 있으면 됩니다. 세대가 바뀔수록 접근성은 높아집니다.

- 초기 기대는 언제나 현실을 앞섭니다. 새로운 기술이 나올 때마다 “예술의 종말”이라는 말이 반복됩니다. 하지만 예술은 사라지지 않습니다. 늘 형태를 바꿔 적응해왔습니다.

- 법과 윤리는 기술을 따라가지 못합니다. 우리는 아직도 3년 전에 등장한 기술의 저작권 문제를 논의 중입니다. 기술은 빠르게 진화하지만, 법은 그렇지 않습니다.

- 일자리 대체에 대한 우려는 타당하지만 충분하지는 않습니다. 일부 직업은 사라지지만, 동시에 새로운 역할이 생겨납니다. 그 전환기는 특히 당사자들에게 고통스럽습니다.

- 예술은 살아남습니다. 사진이 회화를 죽이지 않았고, 디지털 도구가 전통 매체를 없애지 않았습니다. AI도 인간의 창의성을 없애지 않습니다. 다만 우리가 무엇을, 왜, 어떻게 창작하는지는 바꿔놓을 것입니다.

결론: 다음 장을 열다

1973년 해럴드 코헨이 인내심 있게 코드를 짜던 시절부터, 오늘날 수백만 명이 몇 초 만에 이미지를 만들어내는 시대까지. AI 아트의 역사는 인간의 창의성과 컴퓨팅 기술이 어떻게 관계를 맺어왔는지를 보여주는 변화의 기록입니다.

지금 우리가 마주한 질문은 더 이상 기술적인 문제가 아닙니다. 기술은 이미 작동하고 있고, 그 발전 속도는 놀라울 정도로 빠릅니다. 이제 남은 건 인간에 대한 질문입니다.

- AI가 인간의 창의성을 대체하는 것이 아니라, 어떻게 하면 더 크게 확장하고 증폭할 수 있을까?

- AI를 가능하게 한 예술가들의 작업에 대해 어떻게 공정하게 보상할 수 있을까?

- 이 새로운 창작 생태계에 누가, 어떤 방식으로 참여할 수 있을까?

- 창의성 중에서 어떤 영역을 ‘인간만의 것’으로 남기고 싶은가?

- 기술 전환의 시대 속에서 예술가의 커리어와 생계를 어떻게 지켜낼 수 있을까?

이 질문들에는 쉽게 답할 수 있는 해법이 없습니다. 예술가와 기술자, 기업, 정책 입안자, 그리고 대중 사이의 지속적인 조율과 합의가 필요합니다. AI 아트의 역사는 아직 끝나지 않았고, 우리는 바로 지금 그 역사에서 가장 중대한 장 중 하나를 살아가고 있습니다.

분명한 건, AI를 외면한다고 해서 사라지지 않으며, 실제로 존재하는 문제를 없던 일로 한다고 해결되지는 않는다는 점입니다. 앞으로 나아가기 위해서는 참여가 필요합니다. 문제에는 솔직하고, 가능성에는 열려 있으며, 공정함에 대해서는 분명한 태도를 유지해야 합니다.

AI가 과연 진짜로 창의적일 수 있느냐는 질문 자체가 어쩌면 빗나간 질문일지도 모릅니다. 창의성은 있고 없고로 나뉘는 이분법적 속성이 아니기 때문입니다. 그것은 스펙트럼 위에 존재하고, 협업 속에서 나타나며, 예상치 못한 조합에서 탄생합니다. 지난 50년간의 AI 아트 역사가 우리에게 보여준 것이 있다면, 창의성은 우리가 생각했던 것보다 훨씬 더 넓고, 낯설며, 복잡하다는 사실입니다. 그리고 좋든 싫든 인간은 그 창의성을 AI와 나누려는 선택을 계속해왔습니다.

다음 장은 지금도 쓰이고 있습니다. 사려 깊은 기여를 더해 주세요.