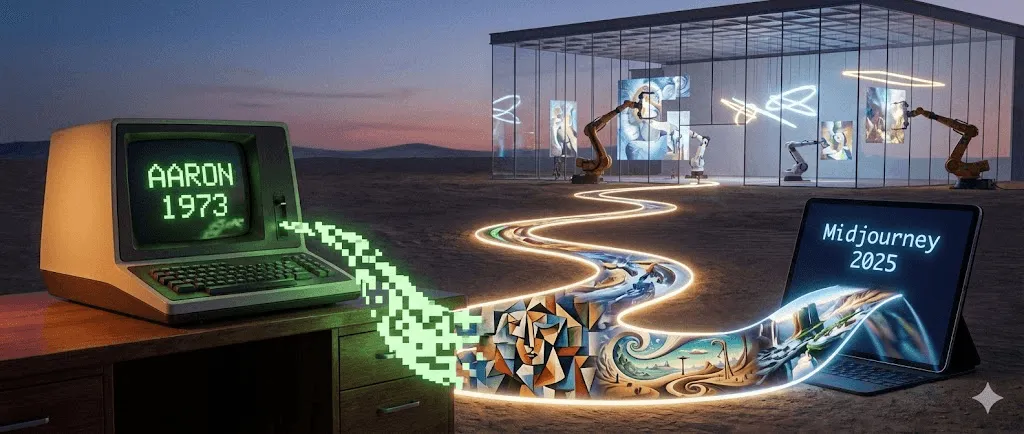

La historia completa del arte con IA: de AARON a Midjourney (1973–2025)

Última actualización: 2026-01-22 18:07:34

Cómo la inteligencia artificial pasó de una curiosidad académica a una revolución artística, y por qué es importante

Esta guía recorre la historia del arte con IA desde los primeros sistemas basados en reglas hasta los actuales modelos de difusión, para mostrar cómo cada avance transformó lo que los artistas podían crear.

Cuando un robot vendió arte por casi medio millón de dólares

En octubre de 2018 ocurrió algo sin precedentes en la casa de subastas Christie’s de Nueva York. Un retrato ligeramente borroso, que evocaba vagamente la pintura europea del siglo XVIII, se vendió por $432,500. ¿El comprador? Un coleccionista anónimo. ¿El vendedor? El colectivo francés Obvious. ¿El artista? Un algoritmo.

"Portrait of Edmond de Belamy" no fue pintado por manos humanas. Fue generado por una Red Generativa Adversarial (GAN) entrenada con 15.000 retratos históricos. La firma en la esquina no era un nombre, sino una fórmula matemática: "min max Ex[log(D(x))] + Ez[log(1 D(G(z)))]."

El mundo del arte se dividió. Para algunos fue un punto de inflexión histórico. Para otros, un simple truco, incluso un escándalo, sobre todo cuando salió a la luz que el colectivo había utilizado código de código abierto sin atribuirlo correctamente a su autor original, Robbie Barrat. Pero más allá de la polémica, algo quedó claro: el arte generado con IA había llegado para quedarse, y ya no había forma de volver a meter a ese genio en la botella.

Pero hay algo que casi nadie sabe: aquella subasta de 2018 no marcó el inicio de la historia del arte con IA. Ni de lejos. La historia empieza en realidad 45 años antes, en el laboratorio de informática de una universidad, con un pintor británico que llegó a la conclusión de que el pincel ya no suponía un reto suficiente.

Cronología rápida:

Década de 1960: Los primeros experimentos de arte por computadora y arte algorítmico sientan las bases

1973: Harold Cohen inicia AARON

2015: DeepDream + las primeras técnicas de transferencia de estilo se vuelven virales

2014–2018: los GANs llevan el realismo de las imágenes a otro nivel; el arte con IA entra en galerías y subastas

2021: CLIP desbloquea la comprensión texto-imagen

2022: Modelos de difusión + Midjourney / DALL·E / Stable Diffusion llevan el arte con IA al gran público

2023–2025: Derechos de autor, consentimiento de datasets, herramientas de procedencia y debates regulatorios se intensifican

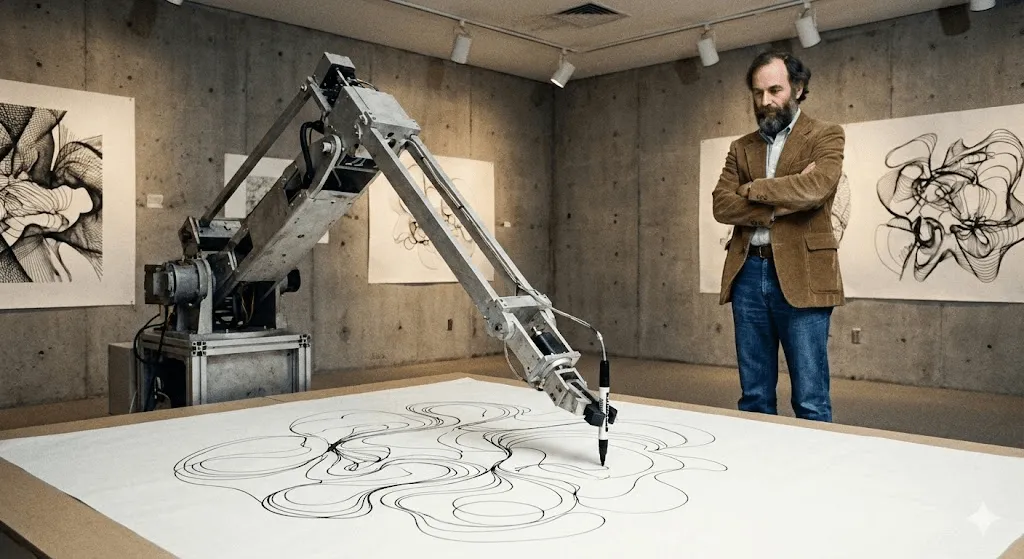

El pionero accidental: cómo un pintor creó al primer artista de IA

Harold Cohen y AARON (1973–2016)

En 1968, Harold Cohen estaba en la cima de su carrera. Había representado a Gran Bretaña en la Bienal de Venecia. Sus pinturas abstractas se exhibían en galerías de prestigio. Pero algo no terminaba de cuadrarle. Como recordaría más tarde: «Tal vez estén pasando cosas más interesantes fuera de mi estudio que dentro de él».

Cohen daba clases en la Universidad de California en San Diego cuando se cruzó por primera vez con las computadoras. No las vio como una simple herramienta para digitalizar su obra existente, sino como algo mucho más profundo: ¿podía una computadora crear arte por sí misma? No reproducir, no copiar, sino crear de verdad.

El resultado fue AARON, llamado en parte por Aarón, el hermano de Moisés en el Éxodo. Cuando Cohen lo presentó por primera vez en la UC Berkeley en 1974, AARON solo podía generar patrones abstractos. Pero aquí está lo revolucionario: no se limitaba a ejecutar instrucciones predeterminadas. Cohen lo había programado con reglas sobre composición, cierre y conceptos de forma que él entendía como pintor, pero dentro de esas reglas, AARON tomaba sus propias decisiones.

Piénsalo así: Cohen le enseñó a AARON la gramática del lenguaje visual, pero AARON fue quien escribió sus propias frases.

Para la década de 1980, AARON ya producía imágenes reconocibles: figuras humanas, plantas, escenas de interiores. Cohen lo dejaba trabajar con un brazo robótico de dibujo (desarrollado junto a colaboradores en entornos de investigación universitaria, mientras exploraba cómo el código podía “dibujar” en el mundo físico), y el sistema generaba dibujos de gran complejidad. Cada uno era único. Todos inconfundiblemente del estilo de AARON, pero ninguno igual a otro.

Lo fascinante es que Cohen nunca pudo predecir por completo qué iba a crear AARON. Descubrió que algunas de sus instrucciones de programación generaban formas que él mismo no había imaginado. La máquina le estaba revelando posibilidades dentro de su propio sistema artístico que hasta entonces no había visto.

AARON siguió evolucionando durante más de 40 años. La versión de 2001 generaba escenas coloridas con figuras y plantas. La versión de 2007 («Gijon») creaba paisajes de apariencia selvática. Cuando Cohen murió en 2016, dejó tras de sí no solo miles de obras, sino una pregunta profunda: si AARON sorprendía a su propio creador con composiciones inéditas, ¿era realmente creativo?

Grandes instituciones, incluido el Whitney, han expuesto obras y documentación relacionadas con AARON de Cohen, lo que subraya su relevancia en la historia del arte digital. A día de hoy, AARON sigue generando imágenes; sin embargo, todo lo creado después de la muerte de Cohen se considera de forma polémica inauténtico.

Antes de AARON: arte generativo y primeros experimentos con computadoras (década de 1960)

Mucho antes de los modelos actuales, los artistas ya utilizaban algoritmos para generar formas visuales. Los primeros dibujos realizados con plotters y el “arte generativo” basado en reglas de los años sesenta introdujeron una idea clave que aún define el arte con IA: el artista diseña un sistema y el sistema produce variaciones más allá de la repetición manual.

Las décadas silenciosas: el arte con IA antes del boom (años 80–2000)

Mientras Cohen trabajaba en AARON, otros artistas exploraban la creatividad computacional, aunque fuera de los círculos académicos casi nadie lo notó.

Karl Sims es probablemente el nombre más reconocible de esta etapa, al menos dentro del mundo del arte digital. En los años 80 trabajó en el MIT Media Lab y más tarde en Thinking Machines (una empresa de supercomputación), donde creó animaciones 3D mediante “evolución artificial”. Su método era simple y potente: generar formas 3D aleatorias, dejar que mutaran, elegir las más interesantes y repetir el proceso. En esencia, una selección natural aplicada a criaturas digitales.

Su obra de 1991, "Panspermia", y "Liquid Selves" de 1992 ganaron los máximos premios en Ars Electronica, el prestigioso festival de artes digitales. Si has visto esas animaciones 3D hipnóticas y orgánicas que no se parecen del todo a nada en la naturaleza pero se sienten extrañamente vivas, Sims fue pionero de esa estética.

Scott Draves tomó un camino distinto con “Electric Sheep” (1999). Es un salvapantallas —sí, de esos, ¿te acuerdas?— pero uno que aprende. Distribuido en miles de computadoras, genera animaciones fractales en evolución llamadas “sheep”. Cuando los espectadores votan los patrones que más les gustan, el sistema “cría” más de esos patrones. Y sigue activo hoy en día. Entra a electricsheep.org y míralo en acción.

Durante este periodo, el término «arte generativo» se popularizó. Los artistas escribían código que establecía reglas y parámetros, y dejaban que los algoritmos crearan dentro de esos límites. Processing, un lenguaje de programación diseñado específicamente para artistas, se lanzó en 2001 y hizo que todo esto fuera mucho más accesible.

Pero aquí está el punto clave: para la mayoría de la gente, nada de esto se sentía realmente como “IA”. Eran proyectos de arte digital interesantes, sí, pero no parecían inteligentes. No entendían lo que estaban creando. Simplemente seguían reglas, por complejas que fueran.

Eso estaba a punto de cambiar.

El deep learning lo cambia todo (2012–2015)

A principios de la década de 2010 se produjo un cambio fundamental. Tres factores convergieron:

Primero, las GPUs (unidades de procesamiento gráfico) se volvieron lo suficientemente potentes como para entrenar redes neuronales masivas. Irónicamente, chips creados para videojuegos hicieron posibles avances clave en la IA.

En segundo lugar, llegaron los grandes conjuntos de datos. ImageNet, lanzado en 2009, reunió millones de imágenes etiquetadas. Por primera vez, las redes neuronales contaban con suficientes ejemplos para aprender patrones de verdad.

En tercer lugar, los algoritmos de deep learning mejoraron de forma radical. En 2012, los modelos de aprendizaje profundo lograron avances espectaculares en los benchmarks de reconocimiento de imágenes (popularizados por ImageNet), dejando atrás a los enfoques tradicionales de visión por computadora. Quedó claro para la comunidad investigadora: si haces que las redes neuronales sean lo suficientemente profundas (con muchas capas), les das suficientes datos y potencia de cómputo, empiezan a mostrar comportamientos sorprendentemente inteligentes.

Para el mundo del arte, las implicaciones fueron profundas.

El momento Deep Dream (2015)

En junio de 2015, el ingeniero de Google Alexander Mordvintsev publicó algo bastante extraño. Estaba investigando cómo las redes neuronales reconocen objetos visuales. La pregunta era: si una red se entrena para identificar perros, ¿qué ocurre si se invierte el proceso y se le pide que potencie cualquier patrón parecido a un perro que detecte en una imagen?

Los resultados eran una auténtica locura. Psicodélicos. Casi alucinatorios. Le dabas una foto de nubes y la red empezaba a ver caras de perros, ojos y elementos arquitectónicos por todas partes, amplificándolos hasta convertirlos en paisajes surrealistas. La comunidad artística enloqueció.

Google lo llamó DeepDream (oficialmente “Inceptionism”). En cuestión de semanas, los artistas empezaron a crear galerías enteras de arte DeepDream. Se convirtió en una estética propia: imágenes cubiertas de ojos y patrones orgánicos en espiral. Incluso hoy, una imagen de DeepDream se reconoce al instante.

Lo que lo volvió culturalmente significativo no fueron solo las imágenes. Fue la revelación: esto es lo que una red neuronal ve cuando observa el mundo. No ve lo mismo que nosotros. Ve patrones, correlaciones, relaciones estadísticas. Y esos patrones, al hacerse visibles, parecen sueños febriles.

Era rarísimo. Y a la gente le encantó.

Transferencia de estilo: las redes neuronales como artistas (2015–2016)

Por esos mismos años, los investigadores descubrieron cómo usar redes neuronales para hacer “transferencia de estilo”: tomar el estilo de una imagen y aplicarlo a otra. ¿Quieres ver tu foto transformada con el estilo de La noche estrellada de Van Gogh? Listo en cuestión de segundos.

El artículo técnico era denso (Gatys et al., 2015), pero pronto empezaron a surgir aplicaciones que lo llevaban a la práctica. Prisma se volvió viral en 2016. De repente, cualquiera con un smartphone podía crear “arte” con el estilo de grandes maestros de la pintura.

Los críticos señalaron que esto no era realmente crear arte nuevo, sino una imitación algorítmica. Pero demostró algo clave: las redes neuronales podían comprender el estilo artístico lo suficiente como para replicarlo. Y eso sí era nuevo.

GANs: la tecnología que marcó un antes y un después (2014–2020)

Para los artistas, los GANs fueron clave porque hicieron que el “estilo” pudiera aprenderse a partir de datos, permitiéndote explorar un universo visual sin tener que programar a mano cada regla.

Cómo funcionan las GAN (sin entrar en matemáticas)

En 2014, Ian Goodfellow, entonces doctorando en la Universidad de Montreal, presentó las Generative Adversarial Networks (GAN) en un artículo que se convertiría en uno de los más citados del aprendizaje automático. Yann LeCun, uno de los padres fundadores del deep learning, calificó a las GAN como «la idea más interesante del aprendizaje automático de los últimos 10 años».

La idea es esta: imagina dos redes neuronales jugando una contra la otra.

Red 1 (el Generador): Busca crear imágenes falsas que parezcan reales.

Network 2 (the Discriminator): Intenta distinguir las imágenes falsas de las reales.

Al principio, el Generador es desastroso: solo produce ruido aleatorio. El Discriminador detecta las falsificaciones sin esfuerzo. Pero aquí está lo interesante: el Generador aprende de sus errores. Se ajusta para engañar al Discriminador. El Discriminador, a su vez, mejora para detectar lo falso. El Generador vuelve a adaptarse. Y así, ida y vuelta, miles de veces.

Con el tiempo, el Generador se vuelve tan bueno que ni siquiera el Discriminador puede distinguir con fiabilidad lo falso de lo real. En ese punto, tienes una red neuronal capaz de crear imágenes convincentes desde cero.

El gran avance: las GAN no necesitan datos de entrenamiento etiquetados por humanos para cada resultado posible. Aprenden la distribución estadística subyacente de aquello con lo que se entrenan —rostros, paisajes, lo que sea— y pueden generar variaciones infinitas.

De caras extrañas a arte convincente (2015–2018)

Los primeros resultados con GAN eran… digamos que “experimentales”. Si recuerdas esas caras generadas por IA de alrededor de 2015, deformadas y propias del valle inquietante, auténtico material de pesadilla, eso eran los primeros GAN. Los investigadores las compartían como prueba de concepto y, casi de inmediato, se convertían en memes.

Pero la tecnología avanzó a gran velocidad. Para 2017, el Progressive GAN de NVIDIA ya podía generar rostros de 1024×1024 indistinguibles de fotografías. En 2018, StyleGAN elevó aún más la resolución y añadió un mayor control sobre distintos aspectos de la imagen.

Los artistas empezaron a experimentar. Mario Klingemann, artista alemán, creó "Memories of Passersby I" (2018), una instalación con dos pantallas que muestran retratos generados de forma infinita. Desfilan como recuerdos, sin repetirse nunca. Se vendió en Sotheby's por £40,000.

Helena Sarin optó por un enfoque distinto: entrenar GANs con sus propios dibujos en lugar de fotografías. Así pudo mantener el control artístico mientras aprovechaba el poder generativo de la IA. Su serie "AI Candy Store" tiene una estética inconfundible, claramente vinculada a la IA, pero impregnada de su estilo personal.

Robbie Barrat, por entonces estudiante de secundaria, entrenó GANs con arte clásico y compartió su código abiertamente en GitHub. (Es el código que más tarde utilizaría Obvious para la subasta de Christie's, lo que desató la controversia sobre la atribución y el crédito artístico).

El próximo Rembrandt (2016)

Antes del revuelo en subasta de Obvious, estuvo “The Next Rembrandt” (2016), un proyecto de marketing de ING y varias instituciones neerlandesas. Escanearon las 346 pinturas de Rembrandt, entrenaron un algoritmo para comprender su estilo y generaron un retrato “nuevo” de Rembrandt.

No era técnicamente un GAN, pero la idea era similar: ¿puede una IA crear obras en el estilo de un artista concreto? El proyecto tuvo una enorme repercusión mediática. Los críticos lo calificaron como un logro técnico, aunque cuestionaron si podía considerarse arte o simplemente un pastiche sofisticado.

Planteó preguntas con las que aún seguimos lidiando: ¿entrenar modelos con la obra de un artista específico es un homenaje respetuoso o una apropiación computacional? ¿En qué punto la inspiración se convierte en plagio?

La explosión: cuando el arte con IA llegó al gran público (2022–presente)

CLIP: Enseñar a la IA a entender texto e imágenes (2021)

El siguiente gran avance llegó de la mano de OpenAI en enero de 2021: CLIP (Contrastive Language Image Pre training). Los detalles técnicos son complejos, pero su impacto fue claro: CLIP podía entender la relación entre el texto y las imágenes.

Los sistemas anteriores necesitaban datos etiquetados: «esto es un gato», «esto es un perro». CLIP, en cambio, aprendió a partir de 400 millones de pares de imágenes y textos recopilados de internet. Así entendió que ciertas palabras suelen asociarse a determinados rasgos visuales. El resultado fue un “espacio” compartido donde texto e imágenes podían compararse directamente.

Por qué fue clave: al combinar CLIP con un modelo generativo, de repente se hizo posible generar imágenes a partir de descripciones en texto. Escribes «un astronauta montando un caballo» y el sistema entiende cómo debería verse.

Los artistas no tardaron en hackear CLIP e integrarlo en sus flujos de trabajo. Al combinarlo con GANs u otros generadores, podían guiar la creación de imágenes con el lenguaje. Era tosco, pero funcionaba.

La revolución de 2022: DALL E 2, Midjourney y Stable Diffusion

[Contexto: historia del arte con IA 1973–2025: de AARON a las GAN, Midjourney y los modelos de difusión. Línea de tiempo.] [Términos de referencia: arte con IA, historia del arte con IA, historia del AI art, línea de tiempo del arte IA, arte IA 1973–2025, AARON arte por computadora, arte generativo, arte algorítmico, arte generado por computadora, generador de imágenes con IA, texto a imagen, modelos de difusión, diffusion models, arte con GAN, redes generativas adversarias, Midjourney, crear imágenes con IA, hacer arte con inteligencia artificial, subasta de Christie’s IA, Retrato de Edmond de Belamy]

Entonces llegó 2022, y todo cambió de la noche a la mañana.

DALL·E 2 (OpenAI, abril de 2022) combinó CLIP con modelos de difusión (hablaremos de ellos enseguida) para generar imágenes de alta calidad y gran coherencia a partir de texto. El acceso inicial se concedió a artistas e investigadores seleccionados. La lista de espera superó rápidamente el millón de personas. Las imágenes que compartió OpenAI eran sorprendentemente creativas, coherentes y, en muchos casos, bellísimas.

Midjourney (Midjourney Inc., julio de 2022) apostó por un enfoque distinto: impulsado por la comunidad, basado en Discord y centrado en la belleza estética. Rápidamente desarrolló una identidad visual propia: pictórica, dramática y a menudo fantástica. Los artistas acudieron en masa. Su servidor de Discord se convirtió en una de las comunidades creativas más activas de internet.

Stable Diffusion (Stability AI, agosto de 2022) marcó un antes y un después en accesibilidad. A diferencia de DALL E 2 (solo web, acceso controlado) o Midjourney (por suscripción), Stable Diffusion era de código abierto. Cualquiera podía descargarlo, ejecutarlo en local y modificarlo.

En cuestión de meses surgió todo un ecosistema: interfaces web, apps móviles, plugins para Photoshop y cientos de modelos personalizados entrenados para estilos específicos. La explosión no tuvo precedentes.

A finales de 2022, las redes sociales se inundaron de arte con IA. El “prompt engineering” se convirtió en una habilidad en sí misma. La gente compartía trucos para obtener mejores resultados. Y estallaron debates constantes sobre si esto estaba democratizando el arte o acabando con él.

Modelos de difusión: la tecnología detrás de la magia

Entonces, ¿qué es un modelo de difusión? En realidad, está inspirado en la física, concretamente en cómo las partículas se dispersan a través de un medio.

El proceso de entrenamiento:

- Parte de una imagen real

- Añade ruido poco a poco hasta convertirla en estática totalmente aleatoria (difusión directa)

- Entrena una red neuronal para invertir el proceso y eliminar el ruido (difusión inversa)

El proceso de generación: se parte de ruido puro, se ejecuta el proceso de difusión inversa y se obtiene una imagen coherente. El condicionamiento por texto (mediante CLIP) guía el tipo de imagen que emerge.

Por qué los modelos de difusión superaron a los GAN en este caso: son más estables, más fáciles de entrenar y mucho mejores interpretando instrucciones de texto. Los GAN siguen usándose en ciertos ámbitos, pero fueron los modelos de difusión los que impulsaron la explosión de 2022.

Aclaración técnica: el artículo clave fue “Denoising Diffusion Probabilistic Models” (Ho et al., 2020), aunque trabajos anteriores de Sohl-Dickstein et al. (2015) sentaron las bases. Si quieres entender esto a fondo, esos papers son un buen punto de partida, pero aviso: vienen cargados de matemáticas.

Las cifras

- A principios de 2023, estas herramientas ya habían llegado a millones de usuarios y las imágenes generadas por IA empezaron a inundar las plataformas sociales.

- DALL E: más de 3 millones de usuarios (lista de espera eliminada)

- Stable Diffusion: imposible de cuantificar (código abierto y distribuido), pero las estadísticas de GitHub apuntan a millones

Las personas generaron cientos de millones de imágenes con IA. Surgieron empresas enteras dedicadas a ofrecer servicios de arte con IA. Los bancos de imágenes se apresuraron a definir sus políticas. Los artistas tradicionales observaron con desconcierto cómo “artista de IA” se convertía en un nuevo título profesional.

El otro arte con IA: aplicaciones académicas

Mientras todos miraban a los generadores de texto a imagen, los investigadores utilizaban la IA en silencio para revolucionar la investigación en historia del arte. Esta parte de la historia del arte con IA recibe menos atención, pero es, sin duda, la más relevante desde el punto de vista académico.

Visión por computadora para atribución y análisis

Los historiadores del arte siempre han tenido dificultades para atribuir la autoría y determinar quién creó una obra concreta. Hoy, las redes neuronales están empezando a ayudar en esa tarea.

Rutgers Art & AI Lab (dirigido por Ahmed Elgammal) desarrolló sistemas que analizan pinceladas, elementos compositivos y rasgos estilísticos para atribuir autoría o detectar falsificaciones. En 2017, identificaron correctamente a los autores de obras sin atribución con más del 90 % de precisión en pruebas controladas.

Reconstrucción de obras perdidas: Redes neuronales entrenadas con las obras conocidas de un artista pueden generar reconstrucciones plausibles de piezas perdidas o dañadas. El ejemplo más famoso: el uso de IA para extrapolar “La ronda de noche” de Rembrandt, dañada en 1715, y mostrar cómo podrían haber sido las partes recortadas. (Aunque los historiadores del arte debaten su precisión, se trata de una especulación informada, no de una recuperación.)

Pergaminos de Herculano: En 2023, científicos informáticos utilizaron aprendizaje automático para leer textos de antiguos pergaminos carbonizados por el Vesubio en el año 79 d.C. Los pergaminos son demasiado frágiles para desenrollarlos, pero las tomografías computarizadas, combinadas con redes neuronales entrenadas, lograron detectar patrones de tinta. Es la IA permitiéndonos leer textos antiguos por primera vez en 2.000 años. (Fuente: Nature, 2023)

Museos e IA

Instituciones de primer nivel han experimentado con la IA de formas fascinantes:

The Met ha experimentado con visualización de colecciones impulsada por IA, mapeando archivos museísticos a gran escala en un “espacio latente” para revelar relaciones inesperadas entre las obras.: Colaboración entre el Metropolitan Museum, el MIT y el artista Refik Anadol. Entrenaron redes neuronales con la colección completa del Met (más de 375.000 obras) y luego visualizaron ese “espacio latente”: el territorio conceptual entre distintos tipos de objetos. El resultado sacó a la luz conexiones sorprendentes: por ejemplo, un aguamanil persa antiguo y un jarrón del siglo XIX podían estar conceptualmente más cerca de lo que cualquier curador humano habría imaginado.

Los experimentos de IA del MoMA: “Unsupervised” de Refik Anadol (2022–2023) utilizó aprendizaje automático entrenado con la colección del MoMA para generar proyecciones fluidas y oníricas en el vestíbulo del museo. El mundo del arte se dividió: para algunos fue un truco vistoso, para otros, una nueva forma de explorar y vivir los archivos museísticos.

Transparent AI Project de la LMU de Múnich: Liderado por el profesor Hubertus Kohle, este proyecto de investigación desarrolla herramientas de IA para la historia del arte que explican su razonamiento. Las redes neuronales convencionales son “cajas negras”: te dan una respuesta, pero no sabes por qué. Este proyecto vuelve transparentes las decisiones de la IA, algo clave para su aceptación académica. Están entrenando modelos para identificar similitudes visuales entre obras y explicar qué rasgos influyeron en sus conclusiones.

Estas aplicaciones no crean arte nuevo, pero están transformando la forma en que estudiamos la historia del arte. Y eso, probablemente, tenga un impacto más duradero que cualquier imagen generada.

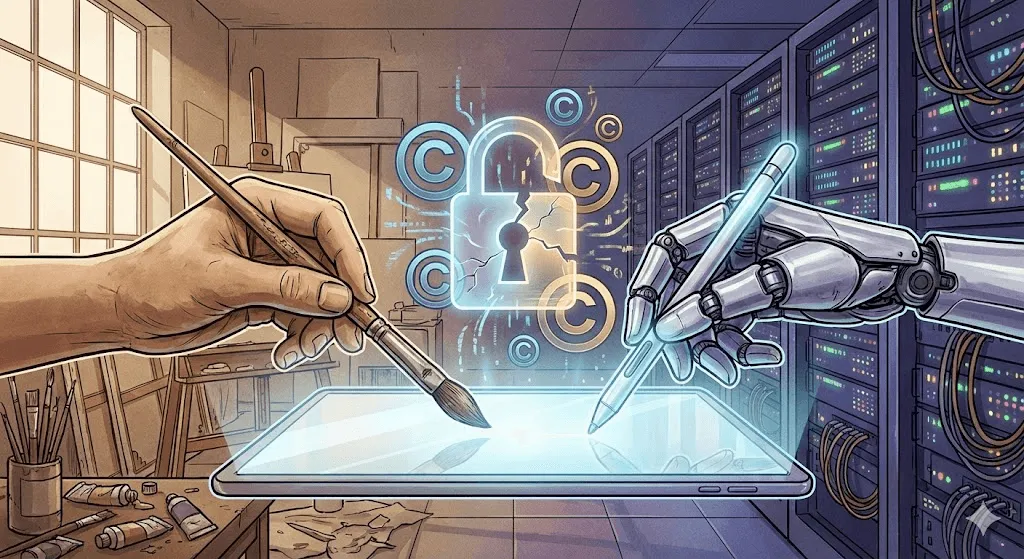

La controversia: derechos de autor, ética y el futuro de la creatividad

Aquí es donde el debate se enciende. Los logros técnicos son impresionantes, pero las implicaciones éticas son… complejas.

La batalla por el copyright

El problema de fondo: los modelos de arte con IA se entrenan con miles de millones de imágenes recopiladas de internet. Muchas tienen derechos de autor. A los artistas no se les pidió permiso. No recibieron compensación. Y ahora, sistemas entrenados con su obra pueden generar imágenes “en su estilo” en cuestión de segundos.

Demandas importantes presentadas:

Getty Images vs. Stability AI (enero de 2023): Getty acusa a Stability de haber recopilado millones de sus imágenes para entrenar Stable Diffusion. Como prueba, señalan que algunas imágenes generadas incluyen fragmentos de las marcas de agua de Getty, dejando visible su origen.

Demanda colectiva de artistas contra Midjourney, Stable Diffusion y DeviantArt (enero de 2023): Encabezada por las artistas Sarah Andersen, Kelly McKernan y Karla Ortiz. Acusa una infracción masiva de derechos de autor. El caso sigue en curso a finales de 2024 y los expertos legales no se ponen de acuerdo sobre su posible desenlace.

La cuestión legal: ¿entrenar con imágenes protegidas por derechos de autor es uso legítimo (como un estudiante que aprende estudiando obras existentes), o es una infracción (usar obras sin permiso con fines comerciales)?

Los tribunales aún no se han pronunciado. La respuesta marcará el rumbo de toda la industria.

Respuestas de los artistas: plantando cara

Los artistas no están esperando a que se pronuncien los tribunales. Están desarrollando contramedidas técnicas.

Glaze (Universidad de Chicago, 2023): Software que modifica sutilmente obras digitales de forma imperceptible para las personas, pero que “envenena” el entrenamiento de modelos de IA. Si un modelo se entrena con imágenes protegidas con Glaze, sus resultados se distorsionan. Funciona como una marca de agua activa: no identifica la obra, sino que degrada el aprendizaje.

Nightshade (también U of Chicago, 2023): Más agresivo que Glaze. No se limita a proteger la imagen con Nightshade; degrada activamente el rendimiento general del modelo. Si se suben suficientes imágenes con Nightshade etiquetadas como “perro” que en realidad muestran gatos, con el tiempo el modelo empieza a confundirse sobre cómo es un perro.

Estas herramientas generan polémica. Los investigadores en IA las consideran un sabotaje perjudicial. Los artistas las ven como una forma de autodefensa. Ambos tienen argumentos válidos.

La propuesta “Do Not Train”: Artistas y defensores han propuesto usar etiquetas de metadatos para marcar obras como no aptas para el entrenamiento de IA. Algunas plataformas (DeviantArt, Shutterstock) han implementado sistemas de exclusión voluntaria. Sin embargo, la aplicación es limitada. Las empresas de IA pueden simplemente ignorar estas etiquetas, y muchas lo hacen.

El debate sobre la creatividad

Más allá del copyright hay una pregunta filosófica: ¿el arte generado por IA es realmente arte?

Lo que no es:

- Carece de intencionalidad humana y profundidad emocional

- Se genera recombinando obras existentes, no creando algo verdaderamente novedoso

- No requiere habilidades: cualquiera puede escribir un prompt

- Socava lo que hace valioso al arte: la creatividad y el esfuerzo humanos

Argumentos de que lo es:

- Las herramientas no hacen que el arte sea menos válido (las cámaras no acabaron con la pintura)

- El prompt engineering y la curaduría también son habilidades creativas

- Las personas guían a la IA y toman las decisiones creativas clave

- Abre nuevas formas de expresión que antes no eran posibles

Mi postura: Este es el debate equivocado. Es como discutir en 1850 si la fotografía es arte. Claro que la IA puede crear arte; ya lo hemos visto. Las preguntas importantes son otras: ¿qué tipo de relación queremos entre la creatividad humana y la de las máquinas? ¿Quién se beneficia? ¿Qué se pierde? ¿Qué se gana?

La realidad del desplazamiento laboral

No es algo teórico. Hay personas reales perdiendo su trabajo.

Una encuesta de 2023 realizada por la Concept Art Association reveló:

- El 73% de los artistas de concept art afirmó tener menos oportunidades laborales

- El 62% perdió trabajos freelance a causa de la IA

- Los puestos de nivel inicial son los que están desapareciendo con mayor rapidez

Las empresas ya usan IA para el trabajo conceptual inicial: bocetos, storyboards y diseños de fondo, justo el tipo de encargos que antes recaían en artistas que empezaban su carrera. Algunos defensores sostienen que no es distinto de cuando las herramientas digitales sustituyeron técnicas tradicionales. Pero la velocidad del cambio no tiene precedentes, y es comprensible que los artistas afectados estén enfadados.

Al mismo tiempo, están surgiendo nuevos perfiles: directores de arte con IA, prompt engineers y especialistas en flujos de trabajo híbridos entre humanos e inteligencia artificial. Aún está por verse si estos roles compensarán, en una proporción 1:1, los empleos que se están perdiendo.

El problema del sesgo

Los modelos de arte con IA heredan los sesgos de los datos con los que se entrenan. Pide “un CEO” y aparecen hombres blancos. “Una enfermera” suele devolver mujeres. “Una persona atractiva” se inclina claramente hacia rostros jóvenes, blancos y que encajan en los cánones de belleza convencionales.

En 2024, Google intentó corregir esto con Gemini al aumentar la diversidad en imágenes históricas, pero la corrección fue excesiva y generó polémica sobre cómo los modelos equilibran la precisión histórica, la representación y la seguridad. El episodio dejó en evidencia lo difícil que es ajustar estos sistemas de forma responsable, especialmente al representar a la nobleza europea del siglo XVIII con diversidad racial. Google pidió disculpas y retiró la función. El caso volvió a mostrar lo complejo que es equilibrar fidelidad histórica y representación.

El sesgo no se limita a lo demográfico. El arte con IA tiende a ciertas estéticas: pulidas, comerciales, convencionalmente bonitas. El arte experimental, vanguardista o deliberadamente feo aparece menos en los resultados porque también es menos frecuente (y menos recompensado) en los datos de entrenamiento. En ese sentido, la IA puede ser artísticamente conservadora incluso cuando es técnicamente radical.

Dónde estamos hoy (2024–2025)

El panorama actual

A finales de 2024 y comienzos de 2025, el panorama del arte con IA ha madurado, pero sigue siendo turbulento:

DALL E 3 (integrado con ChatGPT Plus) mejoró de forma notable la interpretación de prompts. Ahora puedes conversar sobre lo que quieres crear, y la IA entiende los matices con mucha más precisión.

Midjourney V6 llevó la calidad estética un paso más allá, con una mejor representación del texto (aunque todavía imperfecta) y estilos mucho más controlables.

Stable Diffusion XL y más allá sigue evolucionando, con la comunidad de código abierto creando modelos especializados para todo, desde anime y fotorrealismo hasta estilos artísticos específicos.

Adobe Firefly representa el enfoque de “IA responsable”, entrenada únicamente con imágenes de Adobe Stock y contenido de dominio público, con licencias comerciales integradas. Es menos potente que Stable Diffusion, pero ofrece mayor seguridad legal para su uso comercial.

Generación de video: la próxima frontera

El texto a imagen fue solo el comienzo. En 2024 se produjeron avances importantes en la generación de video con IA:

Runway Gen 2 y Pika pueden generar clips de video cortos a partir de texto o imágenes. La calidad aún es irregular: los objetos se deforman de forma poco natural y la física a veces falla, aunque mejora mes a mes.

OpenAI's Sora (anunciado en febrero de 2024, con lanzamiento limitado) demostró video fotorealista y coherente de hasta un minuto de duración. Los videos de demostración dejaban con la boca abierta. También despertaron inquietud: los deepfakes ya eran un problema incluso antes de que la IA pudiera generar video convincente a partir de texto.

3D y más allá

El arte con IA va más allá de las imágenes 2D:

Point E y Shap E (OpenAI) generan modelos 3D a partir de descripciones en texto. La calidad aún es limitada, pero la dirección que está tomando esta tecnología es evidente.

La tecnología NeRF (Neural Radiance Fields) permite generar escenas 3D a partir de imágenes 2D, con aplicaciones que van desde el cine y el desarrollo de videojuegos hasta la visualización arquitectónica.

Música, texto y multimodalidad

La generación de música con IA (Suno, Udio) alcanzó en 2024 un nivel «bastante bueno». La IA no ha reemplazado a los músicos, pero está haciendo que producir música funcional de fondo sea más fácil y económico.

Los modelos multimodales (GPT‑4 con visión, Gemini) pueden analizar imágenes, generar texto a partir de ellas y, después, crear nuevas imágenes basadas en ese texto. Las fronteras entre la IA de texto y la IA de imagen se están difuminando.

Qué viene después: predicciones y posibilidades

Corto plazo (2025–2027)

[Contexto: historia del arte con IA 1973–2025: de AARON a las GAN, Midjourney y la línea de tiempo de los modelos de difusión.] [Términos de referencia: arte con IA, historia del arte con IA, historia del AI art, línea de tiempo del arte IA, arte IA 1973–2025, AARON arte por computadora, arte generativo, arte algorítmico, arte generado por computadora, generador de imágenes con IA, texto a imagen, modelos de difusión, diffusion models, arte con GAN, redes generativas adversarias, Midjourney, crear imágenes con IA, hacer arte con inteligencia artificial, subasta de Christie’s IA, Retrato de Edmond de Belamy]Probable:

- La generación de video alcanza un nivel de uso verdaderamente masivo

- La generación de personajes consistentes (la misma persona en múltiples imágenes) se vuelve fiable

- Mayor claridad legal en torno al copyright, impulsada por litigios en curso

- Consolidación del sector: los actores más pequeños son adquiridos o desaparecen

- Se intensifica el rechazo, con plataformas y clientes que prohíben el arte con IA

Posible:

- Generación de video en tiempo real durante videollamadas o transmisiones en vivo

- El arte con IA se convierte en una herramienta estándar en los flujos de trabajo creativos profesionales

- Aparición del arte "certificado como hecho por humanos" como categoría premium

- Gran exposición en museos dedicada a la historia del arte con IA (más allá de instalaciones aisladas)

Medio plazo (2027–2030)

Especulativo pero plausible:

- Generación de texto, imagen, vídeo, 3D y audio unificada en modelos únicos

- Los modelos de IA personalizados, entrenados con estilos artísticos individuales, se vuelven habituales

- La integración con AR/VR permite llevar el arte con IA a espacios físicos mediante visores

- Los marcos legales establecen compromisos (probablemente complejos) sobre los datos de entrenamiento

- Surgen nuevos movimientos artísticos nativos de la IA, no simples adaptaciones de estilos anteriores a la IA

A largo plazo: las grandes preguntas

¿La IA superará la creatividad humana? Esa es la pregunta equivocada: son cosas distintas.

¿Los artistas humanos se volverán obsoletos? Poco probable. De hecho, la demanda de obras “auténticamente humanas” podría aumentar a medida que la IA inunde el mercado de contenido fácil y abundante.

¿Quién es el dueño del arte generado por IA? Es un debate que todavía se libra en los tribunales. La ley actual de derechos de autor en EE. UU. establece que no pertenece a nadie (al no haber autoría humana), aunque eso está destinado a cambiar.

¿Cómo compensamos a los artistas cuyo trabajo se utiliza para entrenar a la IA? Es la pregunta del millón —literalmente—. Hay posibles vías: licencias, micropagos por uso, sistemas de licencias obligatorias como los de la música. Pero, por ahora, ninguna se ha implementado a gran escala.

¿Debería haber zonas libres de IA? Algunos sostienen que ciertas aplicaciones (libros infantiles, memoriales, pruebas legales) deberían reservarse a creadores humanos. Otros lo consideran ludismo. El debate sigue abierto.

Lecciones de la historia

Al repasar más de 50 años de historia del arte con IA, se revelan algunos patrones:

- Las herramientas se democratizan. AARON exigía saber programar. Los GAN requerían conocimientos de machine learning. Hoy, las herramientas modernas solo necesitan una cuenta de Discord. Cada generación es más accesible que la anterior.

- El entusiasmo inicial suele superar a la realidad. Cada avance provoca titulares de “el arte ha muerto”. El arte no muere: se transforma.

- Los marcos legales y éticos van por detrás de la tecnología. Seguimos debatiendo cuestiones de copyright sobre tecnologías que se lanzaron hace apenas tres años. La ley avanza despacio; la tecnología, no.

- Las preocupaciones por la sustitución laboral suelen ser legítimas, pero incompletas. Sí, algunos trabajos desaparecen. Pero surgen otros nuevos. El periodo de transición es duro, sobre todo para quienes lo viven en primera persona.

- El arte sobrevive. La fotografía no mató a la pintura. Las herramientas digitales no acabaron con los medios tradicionales. La IA no matará la creatividad humana. Pero sí cambiará cómo creamos, por qué creamos y qué creamos.

Conclusión: Escribir el siguiente capítulo

Desde la programación paciente de Harold Cohen en 1973 hasta los millones que hoy generan imágenes en segundos, la historia del arte con IA es, en el fondo, la historia de cómo evoluciona la relación entre la creatividad humana y la capacidad computacional.

Las preguntas a las que nos enfrentamos hoy no son principalmente técnicas: la tecnología funciona y avanza a gran velocidad. Son preguntas humanas:

- ¿Cómo logramos que la IA potencie la creatividad humana en lugar de sustituirla?

- ¿Cómo compensamos de forma justa a los artistas cuyo trabajo hace posible la IA?

- ¿Quiénes pueden participar en este nuevo panorama creativo?

- ¿Qué aspectos de la creatividad queremos que sigan siendo exclusivamente humanos?

- ¿Cómo protegemos las carreras y los medios de vida artísticos durante la transición tecnológica?

Estas preguntas no tienen respuestas fáciles. Exigen negociación entre artistas, expertos en tecnología, empresas, responsables políticos y el público. La historia del arte con IA no ha terminado: estamos viviendo ahora mismo uno de sus capítulos más decisivos.

Lo que está claro es que ignorar la IA no hará que desaparezca, ni tampoco fingir que no plantea desafíos reales. El camino a seguir pasa por involucrarse: ser honestos con los problemas, abiertos a las posibilidades y firmes en la búsqueda de equidad.

En cuanto a si la IA puede ser realmente creativa, quizá estemos haciendo la pregunta equivocada. La creatividad no es una cualidad binaria que se tiene o no se tiene. Existe en espectros, en colaboraciones, en combinaciones inesperadas. Si algo nos han enseñado los primeros 50 años del arte con IA es que la creatividad es más amplia y más extraña de lo que imaginábamos. Y los humanos, para bien o para mal, parecen decididos a compartirla.

El próximo capítulo se está escribiendo ahora. Aporta con criterio.